Equilibrio, estabilidad: el resultado de dos fuerzas contrapuestas

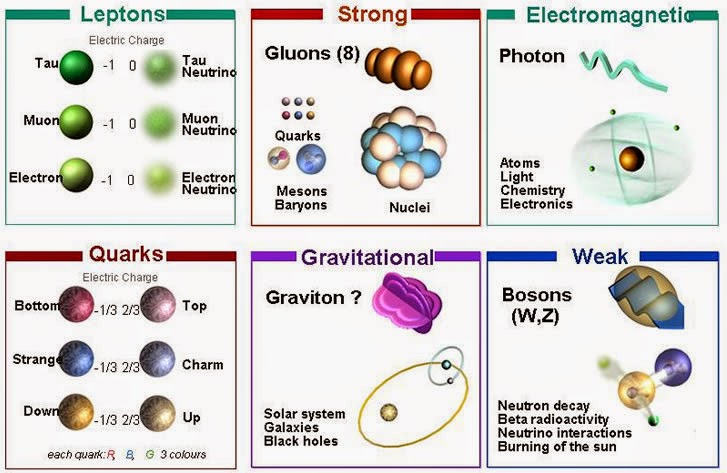

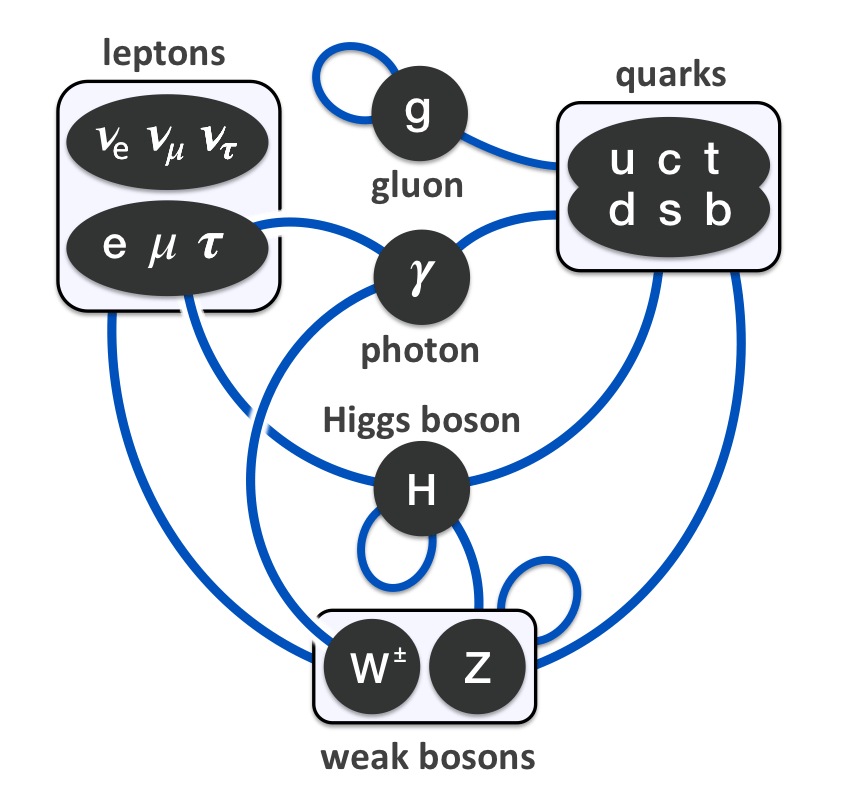

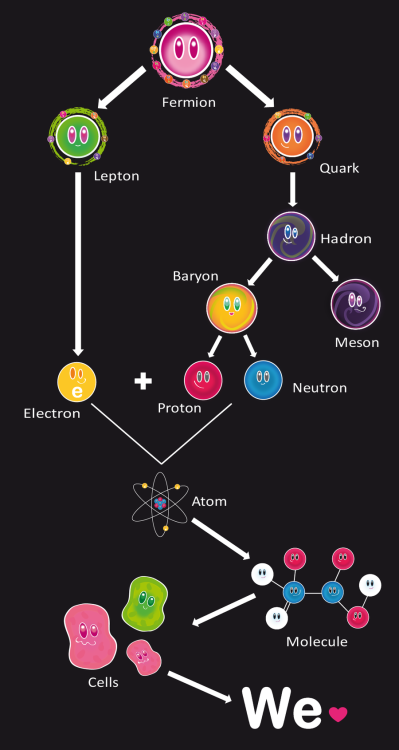

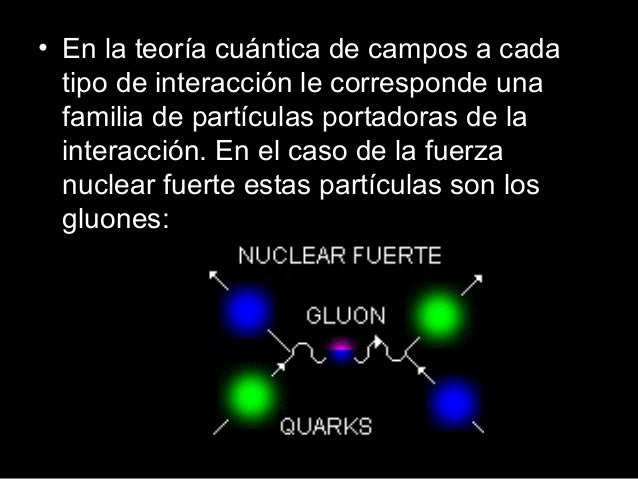

Demos una vuelta por el Modelo Estándar.

Hablar de todo esto nos lleva a recorrer un largo camino

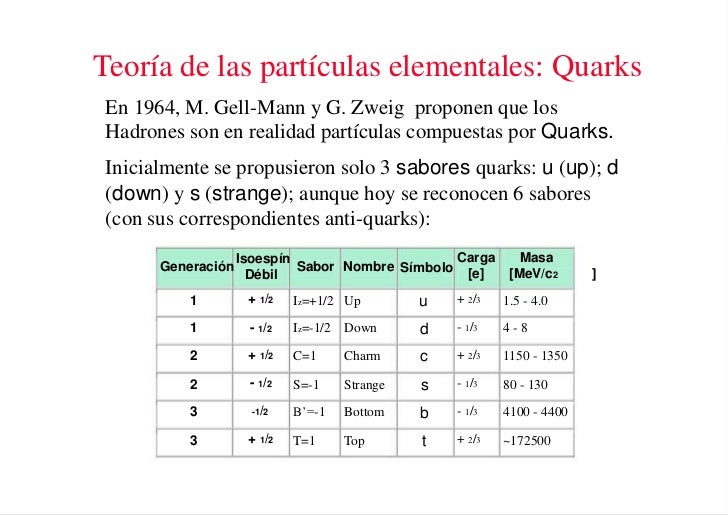

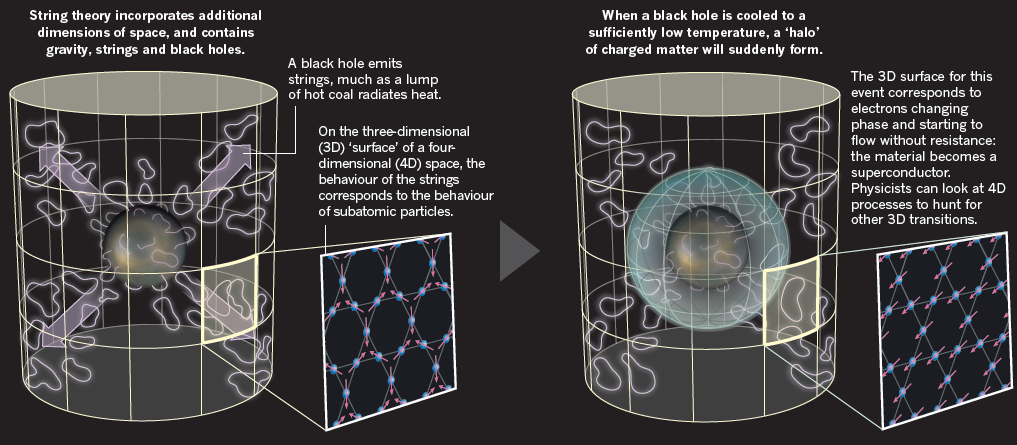

Con el título que arriba podemos leer de “La perfección imperfecta”, me quiero referir al Modelo estándar de la física de partículas y de las interacciones fundamentales y, algunos, han llegado a creer que sólo faltan algunos detalles técnicos y, con ellos, la física teórica está acabada. Tenemos un modelo que engloba todo lo que deseamos saber acerca de nuestro mundo físico. ¿Qué más podemos desear? Los pobres ilusos no caen en la cuenta de que el tal Modelo, al que no podemos negarle su valía como una herramienta muy valiosa para la física, no deja de estar incompleto y, además, ha sido construido con algunos parámetros aleatorios (unos veinte) que no tienen justificación. Uno de ellos era el Bosón de Higgs y, según nos han contado los del LHC, ha sido hallado. Sin embargo, esperamos que nos den muchas explicaciones que no han estado presente en todas las algaradas y fanfarrias que dicho “hallazgo” ha producido, incluidos los premios Principe de Asturias y el Nobel. ¡Veremos en que queda todo esto al final!

Bueno, lo que hasta el momento hemos logrado no está mal del todo pero, no llega, ni con mucho, a la perfección que la Naturaleza refleja y que, nosotros perseguimos sin llegar a poder agarrar sus múltiples entrecijos y parámetros que conforman ese todo en el que, sin ninguna clase de excusas, todo debe encajar y, de momento, no es así. Muchos son los flecos sueltos, muchas las incognitas, múltiples los matices que no sabemos perfilar.

Es cierto que, el Modelo estándar, en algunos momento, nos produce y nos da la sensación de que puede ser perfecto. Sin embargo, esa ilusoria perfección, no es permanente y en algunas casos efímera. En primer lugar, podríamos empezar a quejarnos de las casi veinte constantes que no se pueden calcular. Pero si esta fuese la única queja, habría poco que hacer. Desde luego, se han sugerido numerosas ideas para explicar el origen de estos números y se han propuesto varias teorías para “predecir” sus valores. El problema con todas estas teorías es que los argumentos que dan nunca llegan a ser convincentes.

¿Por qué se iba a preocupar la Naturaleza de una fórmula mágica si en ausencia de tal fórmula no hubiera contradicciones? Lo que realmente necesitamos es algún principio fundamental nuevo, tal como el proncipio de la relatividad, pero nos resistimos a abandonar todos los demás principios que ya conocemos; ¡esos, después de todo, han sido enormemente útiles en el descubrimiento del Modelo estándar! una herramienta que ha posibilitado a todos los físicos del mundo para poder construir sus trabajos en ese fascinante mundo de la mecánica cuántica, donde partículas infinitesimales interactúan con las fuerzas y podemos ver, como se comporta la materia en determinadas circunstancias. El mejor lugar para buscar nuevos principios es precisamente donde se encuentran los puntos débiles de la presente teoría.

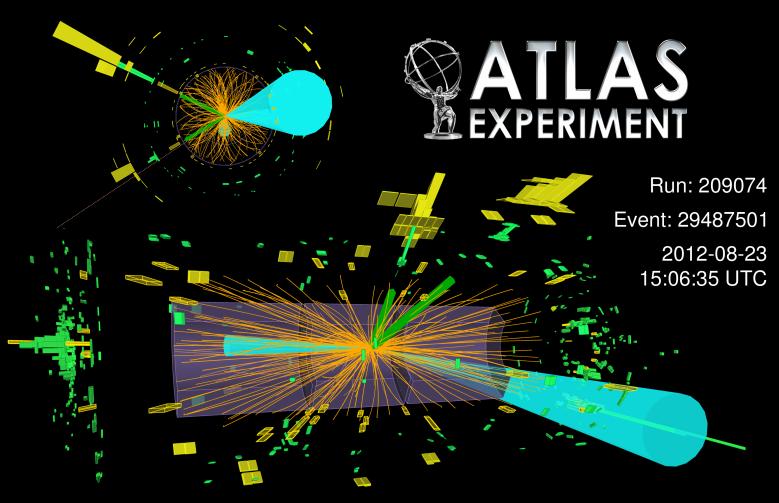

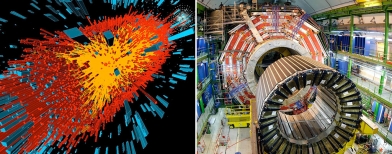

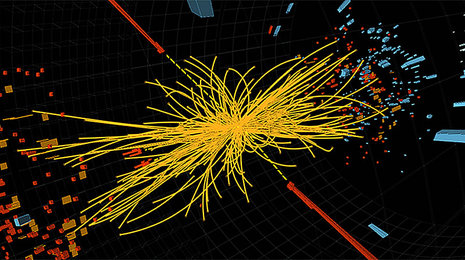

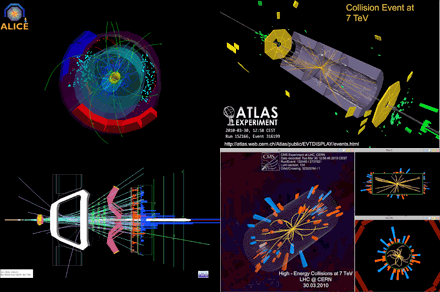

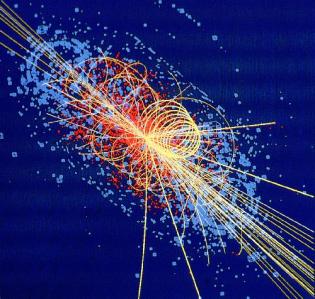

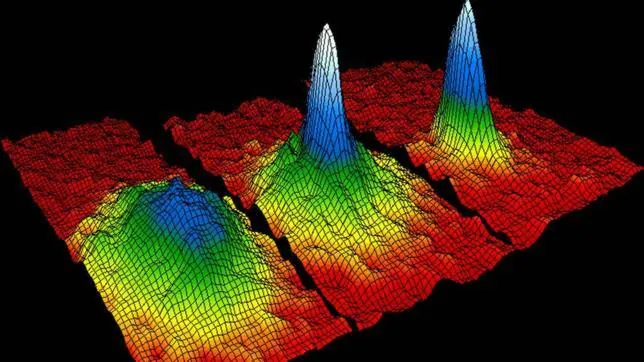

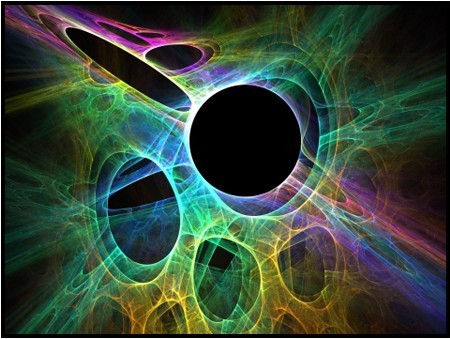

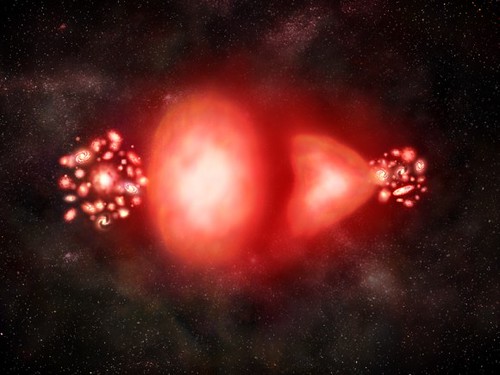

“Colisión del Bosón de Higgs desintegrándose en fermiones”. Primeras evidencias de un nuevo modo de desintegración del bosón de Higgs. Las primeras evidencias de la desintegración del recién descubierto bosón de Higgs en dos partículas denominadas tau, pertenecientes a la familia de partículas que compone la materia que vemos en el Universo. Hasta ahora los experimentos del LHC habían detectado la partícula de Higgs mediante su desintegración en otro tipo de partículas denominadas bosones, portadoras de las fuerzas que actúan en la Naturaleza, mientras las evidencias de desintegraciones en fermiones no eran concluyentes. Esta es la primera evidencia clara de este nuevo modo de desintegración del bosón de Higgs.”

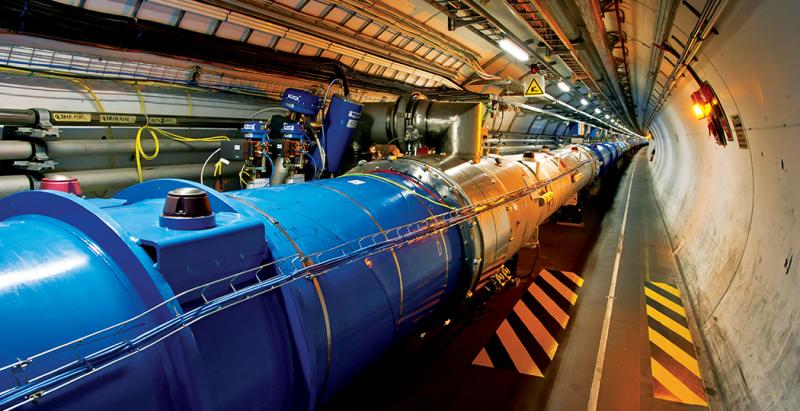

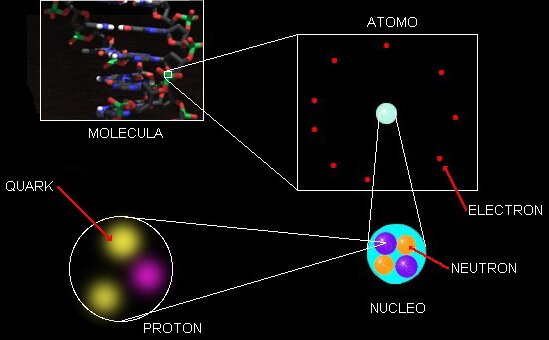

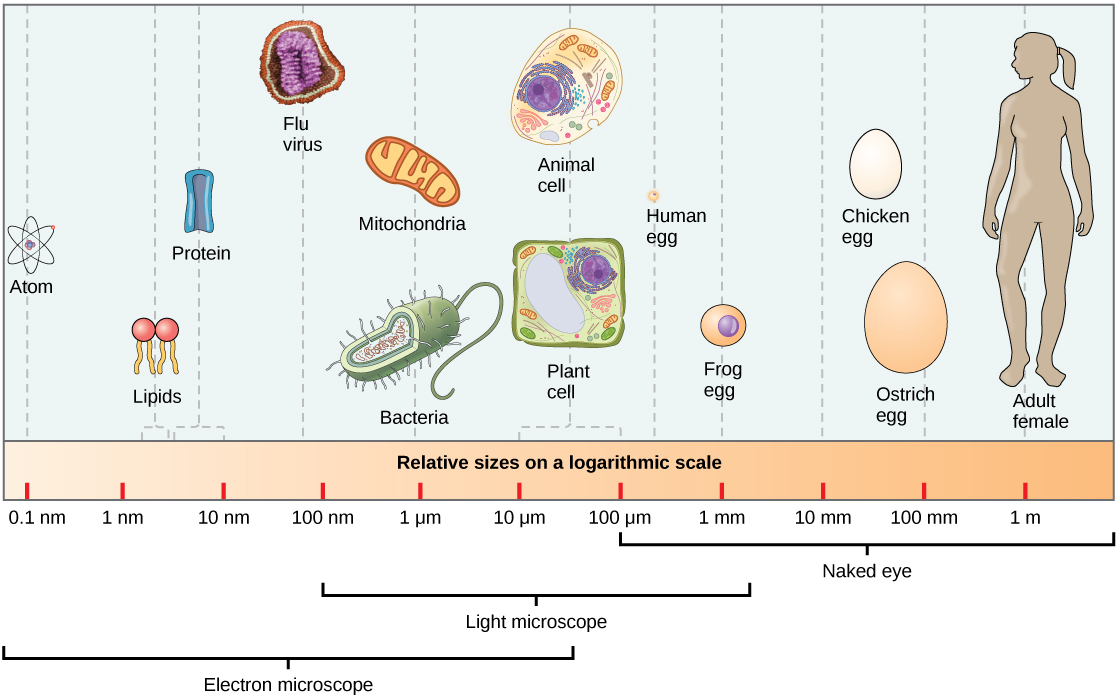

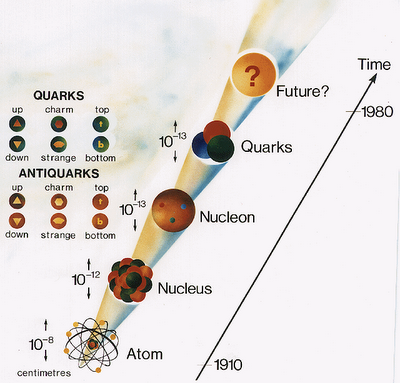

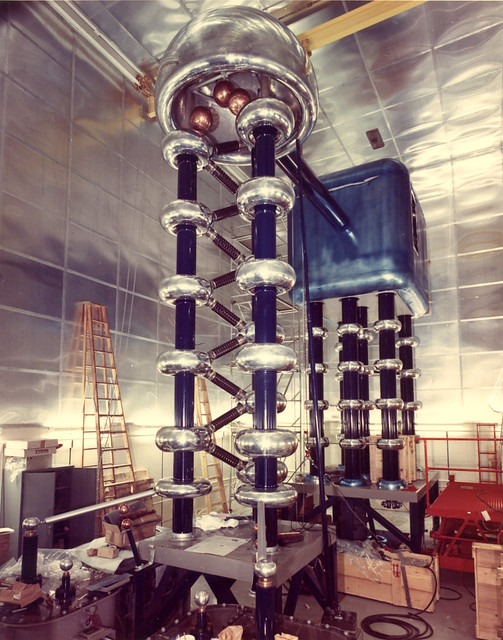

La regla universal en la física de partículas es que cuando las partículas chocan con energías cada vez mayores, los efectos de las colisiones están determinados por estructurtas cada vez menores, más pequeñas en el espacio y en el tiempo. Supongamos por un momento que tenemos a nuestra disposición un Acelerador de Partículas 10.000 veces más potente que el LHC, donde las partículas pueden adquirir esas tantas veces más energías de las alcanzadas actualmente. Las colisiones que tendrían lugar nos dirían algo acerca de los detalles estructurales de esas partículas que ahora no conocemos, que serían mucho más pequeñas que las que ahora podemos contemplar. En este punto se me ocurre la pregunta: ¿Seguiría siendo correcto el Modelo estándar? 0, por el contrario, a medida que nos alejemos en las profundidades de lo muy pequeño, también sus normas podrían variar al mismo tiempo que varían las dimensiones de los productos hallados. Recordad que, el mundo no funciopna de la misma manera en nuestro ámbirto macroscópico que ante ese otro “universo” cuántico de lo infinitesimal.

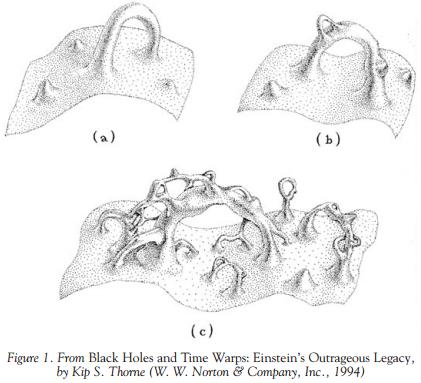

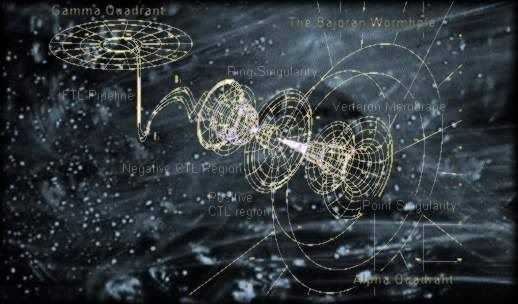

¿Podeis imaginar conseguir colisiones a 70.000 TeV? ¿Que podríamos ver? Y, entonces, seguramente, podríamos oir en los medios la algarada de las protestas de algunos grupos: “Ese monstruo creado por el hombre puede abrir en el espacio tiempo agujeros de gusano que se tragará el mundo y nos llevará hacia otros universos” Comentarios así estarían a la orden del día. Los hay que siempre están dispuestos a protestar por todo y, desde luego, no siempre llevan razón, toda vez que, la mayoría de las veces, ignoran de qué están hablando y juzgan si el conocimiento de causa necesario para ello. De todas las maneras, sí que debemos tener sumo cuidado con el manejo de fuerzas que… ¡no siempre entendemos! Cuando el LHC se vuelva a poner en marcha, se utilizarán energías que llegan hasta los 14 TeV, y, esas son palabras mayores.

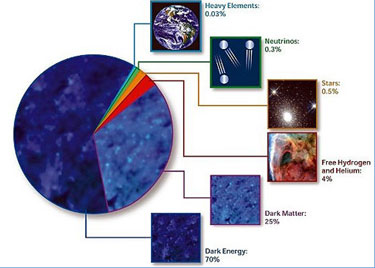

¿Justifica el querer detectar las partículas que conforman la “materia oscura”, o, verificar si al menos, podemos vislumbrar la sombra de las “cuerdas” vibrantes de esa Teoria del Todo, el que se gasten ingentes cantidades de dinero en esos artilugios descomunales? Bueno, a pesar de todos los pesares, la respuesta es que SÍ, el rendimiento y el beneficio que hemos podido recibir de los aceleradores de partículas, justifica de manera amplia todo el esfuerzo realizado, toda vez que, no solo nos ha llevado a conocer muchos secretos que la Naturaleza celosamente guardaba, sino que, de sus actividades hemos tenido beneficios muy directos en ámbitos como la medicina, las comunicaciones y otros que la gente corriente desconocen.

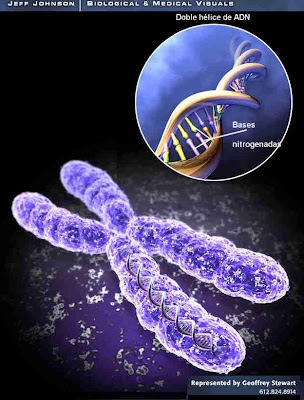

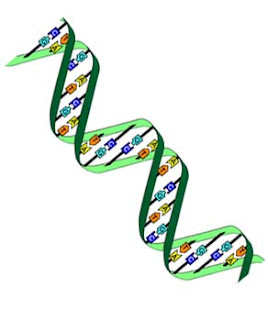

Hoy, el Modelo estándar es una construcción matemática que predice sin ambigüedad cómo debe ser el mundo de las estructuras aún más pequeñas. Pero tenemos algunas razones para sospechar que tales predicciones resultan estar muy alejadas de la realidad, o, incluso, ser completamente falsas. Cuando tenemos la posibilidad de llegar más lejos, con sorpresa podemos descubrir que aquello en lo que habíamos creído durante años, era totalmente diferente. El “mundo” cambia a medida que nos alejamos más y más de lo grande y nos sumergimos en ese otro “mundo” de lo muy pequeño, allí donde habitan los minúsculos objetos que conforman la materia desde los cimientos mismos de la creación.

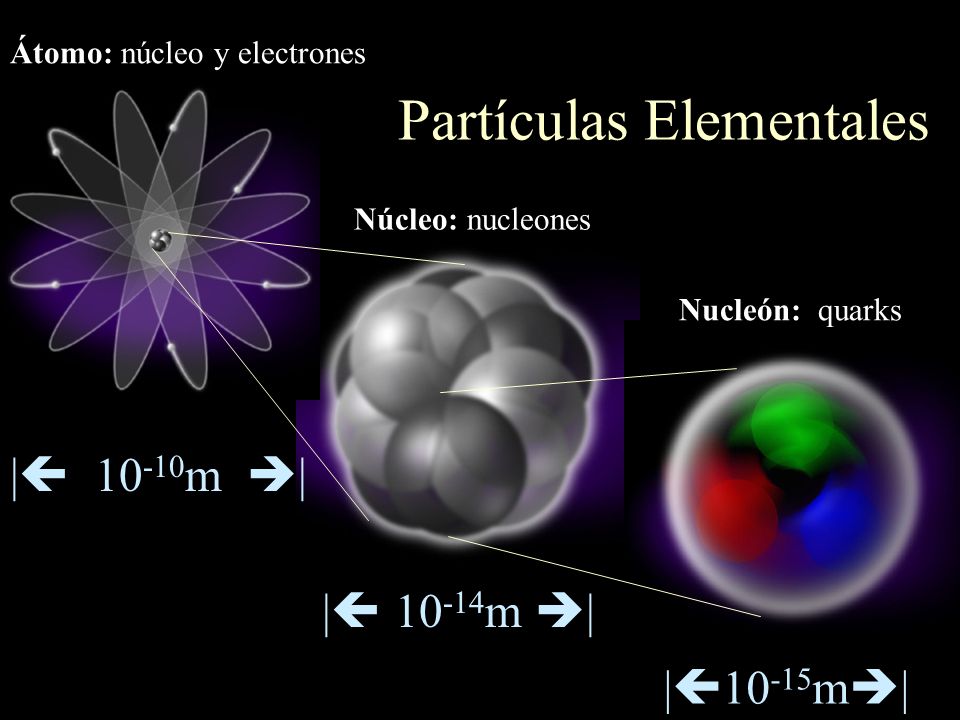

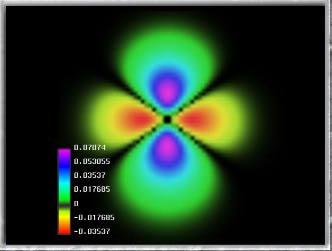

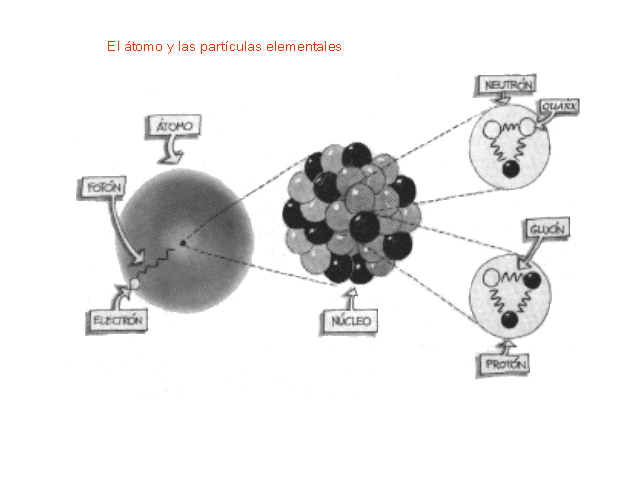

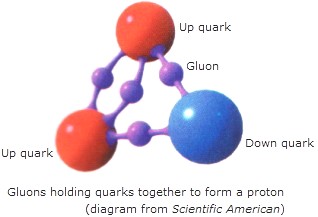

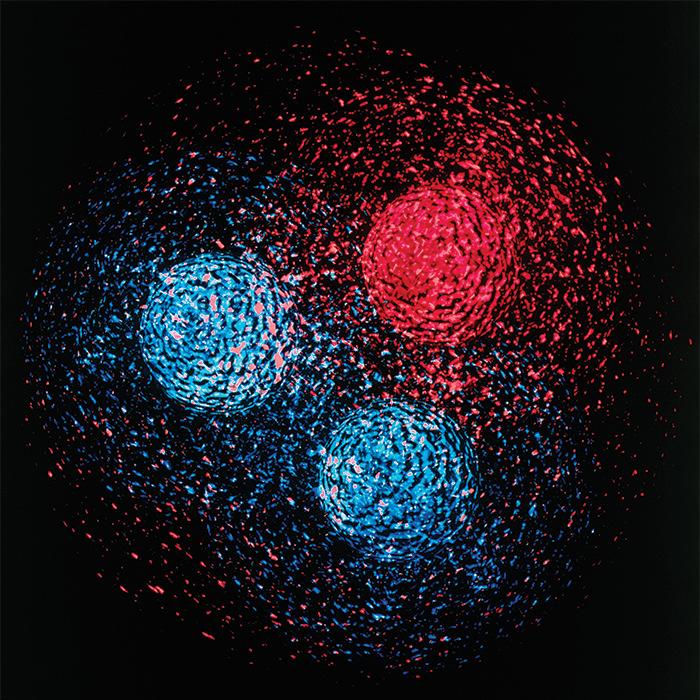

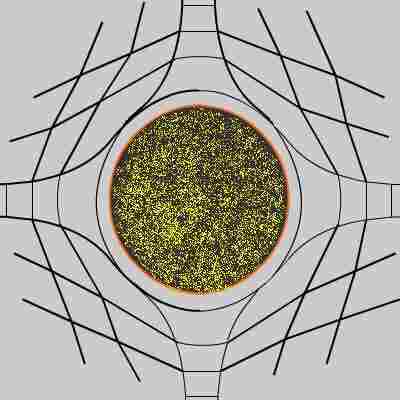

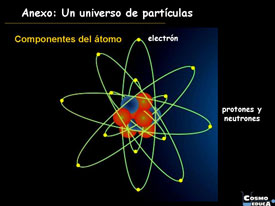

Encendamos nuestro supermicroscopio imaginario y enfoquemosló directamente en el centro de un protón o de cualquier otra partícula. Veremos hordas de partículas fundamentales desnudas pululando. Vistas a través del supermicroscopio, el modelo estándar que contiene veinte constantes naturales, describen las fuerzas que rigen la forma en que se mueven. Sin embargo, ahora esas fuerzas no sólo son bastante fuertes sino que también se cancelan entre ellas de una forma muy especial; están ajustadaspara conspirar de tal manera que las partículas se comportan como partículas ordinarias cuando se vuelven a colocar el microscopio en la escala de ampliación ordinaria. Si en nuestras ecuaciones matemáticas cualquiera de estas constantes fueran reemplazadas por un número ligeramente diferente, la mayoría de las partículas obtendrían inmediatamente masas comparables a las gigantescas energías que son relevantes en el dominio de las muy altas energías. El hecho de que todas las partículas tengan masa que corresponden a energías mucho menores repentinamente llega a ser bastante poco natural.

¿Implica el ajuste fino un diseño con propósito? ¿Hay tantos parámetros que deben tener un ajuste fino y el grado de ajuste fino es tan alto, que no parece posible ninguna otra conclusión?

Antes decía: “El hecho de que todas las partículas tengan masa que corresponden a energías mucho menores repentinamente llega a ser bastante poco natural”. Es lo que se llama el “problema del ajuste fino”. Vistas a través del microscopio, las constantes de la Naturaleza parecen estar cuidadosamente ajustadas sin ninguna otra razón aparente que hacer que las partículas parezcan lo que son. Hay algo muy erróneo aquí. Desde un punto de vista matemático, no hay nada que objetar, pero la credibilidad del Modelo estándar se desploma cuando se mira a escalas de tiempo y longitud extremadamente pequeñas o, lo que es lo mismo, si calculamos lo que pasaría cuando las partículas colisionan con energías extremadamente altas.

¿Y por qué debería ser el modelo válido hasta ahí? Podrían existir muchas clases de partículas súper pesadas que no han nacido porque se necesitan energías aún inalcanzables, ellas podrían modificar completamente el mundo que Gulliver planeaba visitar. Si deseamos evitar la necesidad de un delicado ajuste fino de las constantes de la Naturaleza, creamos un nuevo problema:

Es cierto que nuestra imaginación es grande pero… No pocas veces ¡la realidad la supera!

¿Cómo podemos modificar el modelo estándar de tal manera que el ajuste-fino no sea necesario? Está claro que las modificiaciones son necesarias , lo que implica que muy probablemente hay un límite más allá del cual el modelo deja de ser válido. El Modelo estándar no será más que una aproximación matemática que hemos sido capaces de crear, tal que todos los fenómenos observados hasta el presente están de acuerdo con él, pero cada vez que ponemos en marcha un aparato más poderoso, debemos esperar que sean necesarias nuevas modificaciones para ir ajustando el modelo, a la realidad que descubrimos.

¿Cómo hemos podido pensar de otra manera? ¿Cómo hemos tenido la “arrogancia” de pensar que podemos tener la teoría “definitiva”? Mirando las cosas de esta manera, nuestro problema ahora puede muy bien ser el opuesto al que plantea la pregunta de dónde acaba el modelo estándar: ¿cómo puede ser que el modelo estándar funcione tan extraordinariamente bien? y ¿por qué aún no hemos sido capaces de percibir nada parecido a otra generación de partículas y fuerzas que no encajen en el modelo estándar? La respuesta puede estar en el hecho cierto de que no disponemos de la energía necesaria para poder llegar más lejos de lo que hasta el momento hemos podido viajar con ayuda de los aceleradores de partículas.

/s3.amazonaws.com/arc-wordpress-client-uploads/infobae-wp/wp-content/uploads/2017/04/20092708/particula-cern-1024x575.jpg)

Ella se encargó de hacer la presentación de los resultados del experimento ATLAS, durante el seminario del Centro Europeo de Física de Partículas (CERN) para presentar los resultados de los dos experimentos paralelos que buscan la prueba de la existencia de la “partícula de Higgs, base del modelo estándar de física.

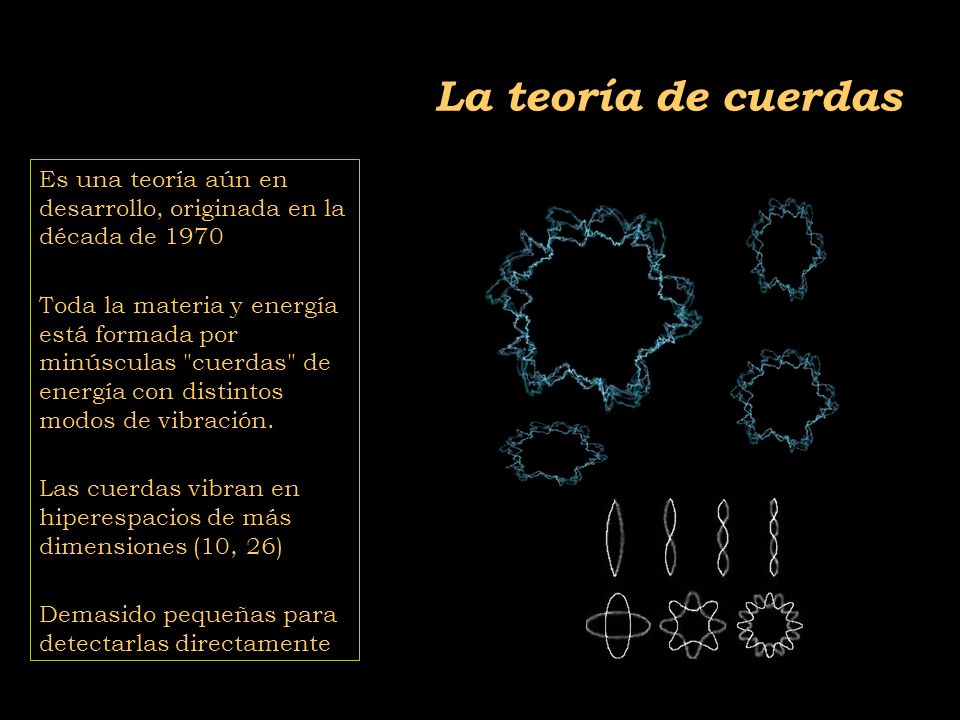

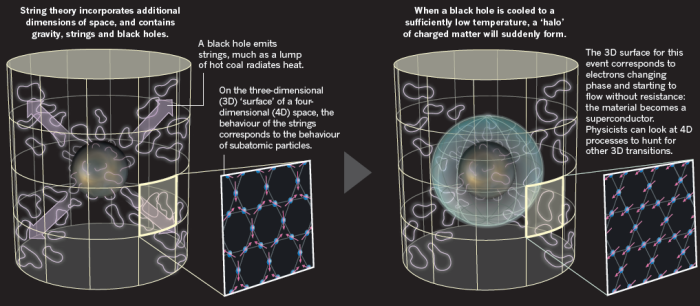

La pregunta “¿Qué hay más allá del Modelo estándar”? ha estado facinando a los físicos durante años. Y, desde luego, todos sueñan con llegar a saber, qué es lo que realmente es lo que conforma el “mundo” de la materia, qué partículas, cuerdas o briznas vibrantes. En realidad, lo cierto es que, la Física que conocemos no tiene que ser, necesariamente, la verdadera física que conforma el mundo y, sí, la física que conforma “nuestro mundo”, es decir, el mundo al que hemos podido tener acceso hasta el momento y que no necesariamente tiene que coincidir con el mundo real que no hemos podido alcanzar.

O, como decía aquél: ¡Que mundo más hermoso, parece de verdad!

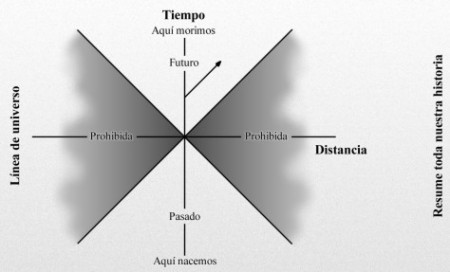

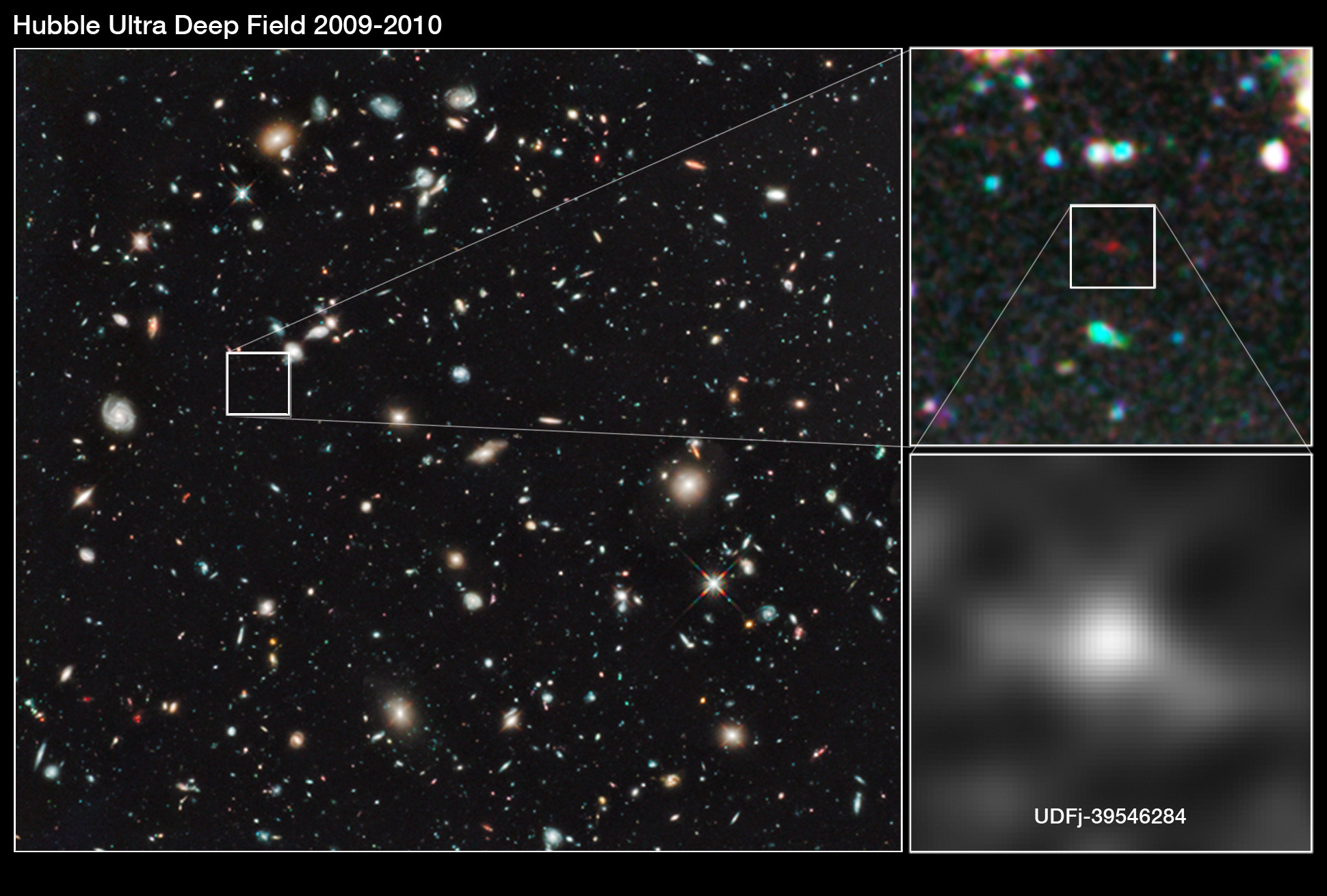

Siempre hay más de lo que el ojo ve

No todo lo que vemos es, necesariamente, un reflejo de la realidad de la Naturaleza que puede tener escondidos más allá de nuestras percepciones, otros escenarios y otros objetos, a los que, por ahora, no hemos podido acceder, toda vez que, físicamente tenemos carencias, intelectualmente también, y, nuestros conocimientos avanzar despacio para conseguir, nuevas máquinas y tecnologías nuevas que nos posibiliten “ver” lo que ahora nos está “prohibido” y, para ello, como ocurre siempre, necesitamos energías de las que no disponemos.

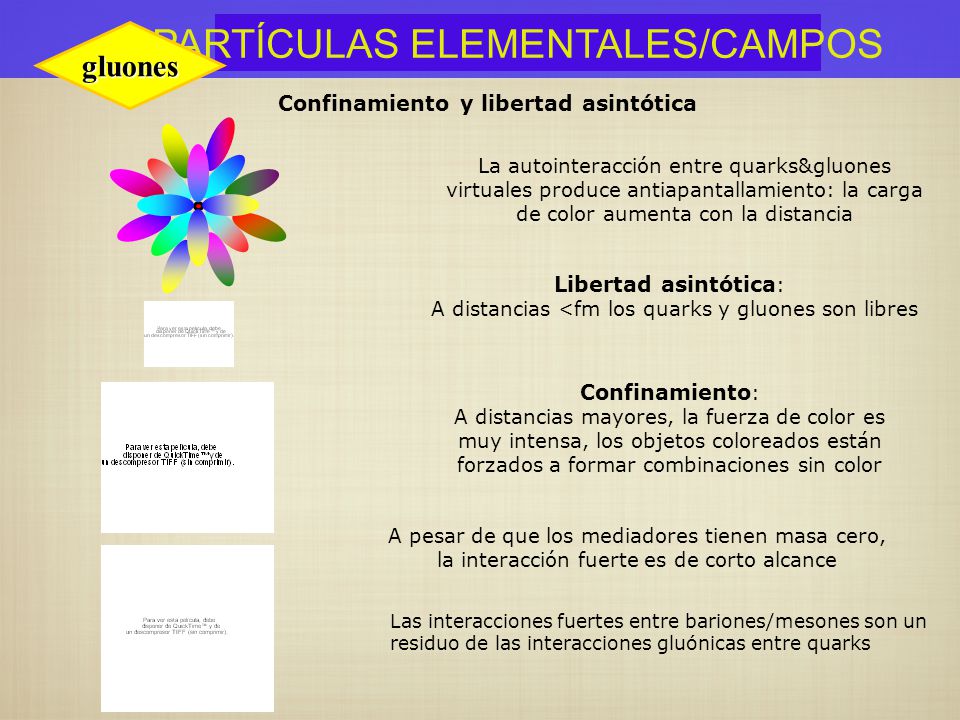

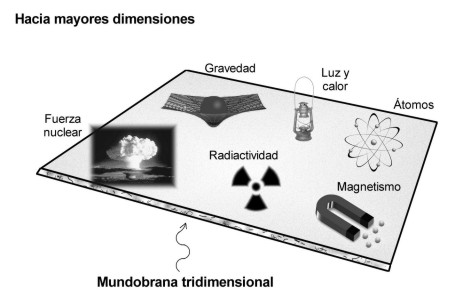

Hay dos direcciones a lo largo de las cuales se podría extender el Modelo estándar, tal lo conocemos actualmente, que básicamente se caraterizan así:

- Nuevas partículas raras y nuevas fuerzas extremadamente débiles, y

- nuevas partículas pesadas y nuevas estructuras a muy altas energías.

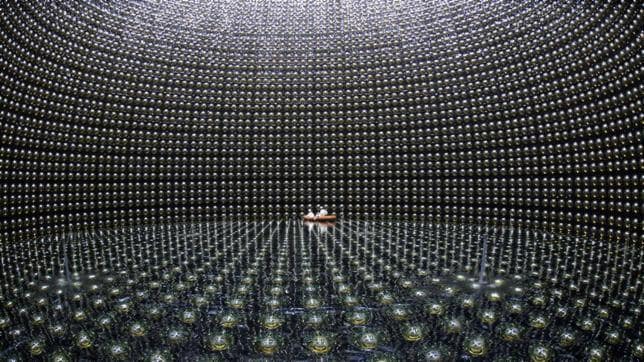

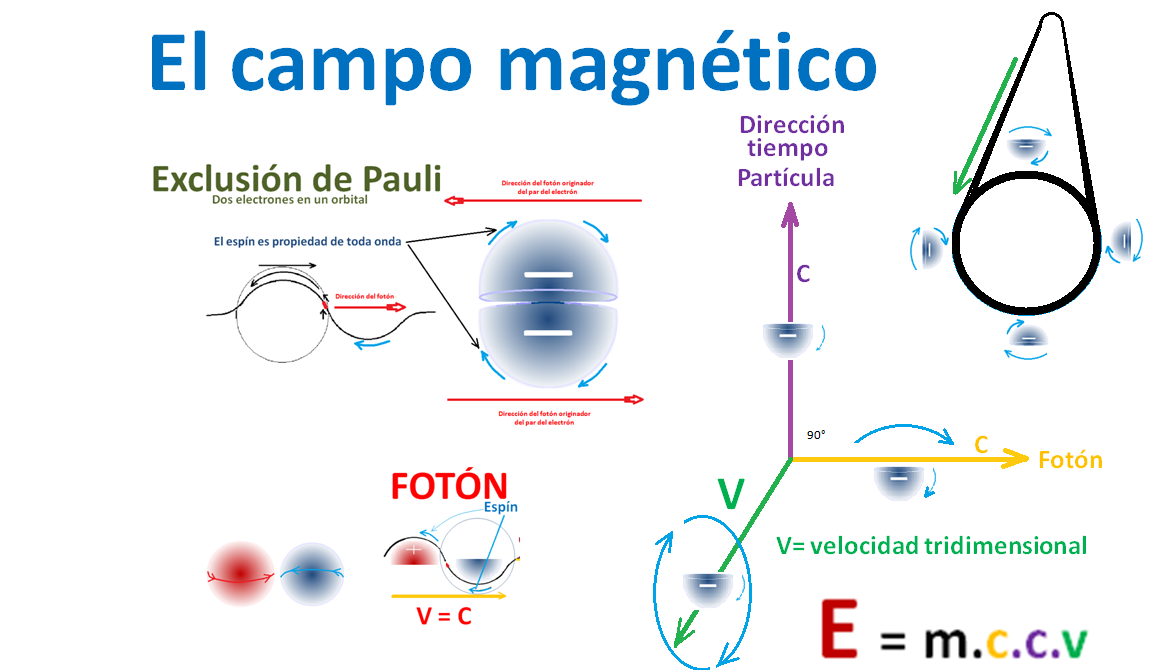

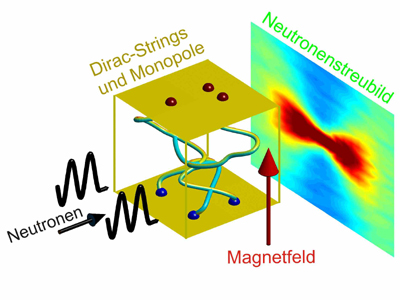

Podrían existir partículas muy difíciles de producir y de detectar y que, por esa razón, hayan pasado desapaercibidas hasta. La primera partícula adicional en la que podríamos pensar es un neutrinorotando a derecha. Recordaremos que si se toma el eje de rotación paralelo a la dirección del movimiento los neutrinos sólo rotan a izquierdas, pero… ¡esa sería otra historia!

Los neutrinos siempre me han fascinado. Siempre se han manifestado como si tuvieran masa estrictamente nula. Parece como si se movieran exactamente con la velocidad de la luz. Pero hay un límite para la precisión de nuestras medidas. Si los neutrinos fueran muy ligeros, por ejemplo, una cienmillonésima de la masa del electrón, seríamos incapaces de detectar en el laboratorio la diferencia éstos y los neutrinos de masa estrictamente nula. Pero, para ello, el neutrino tendría que tener una componente de derechas.

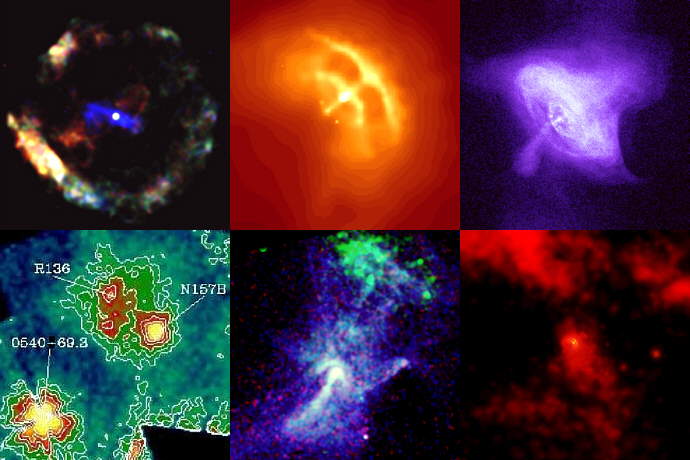

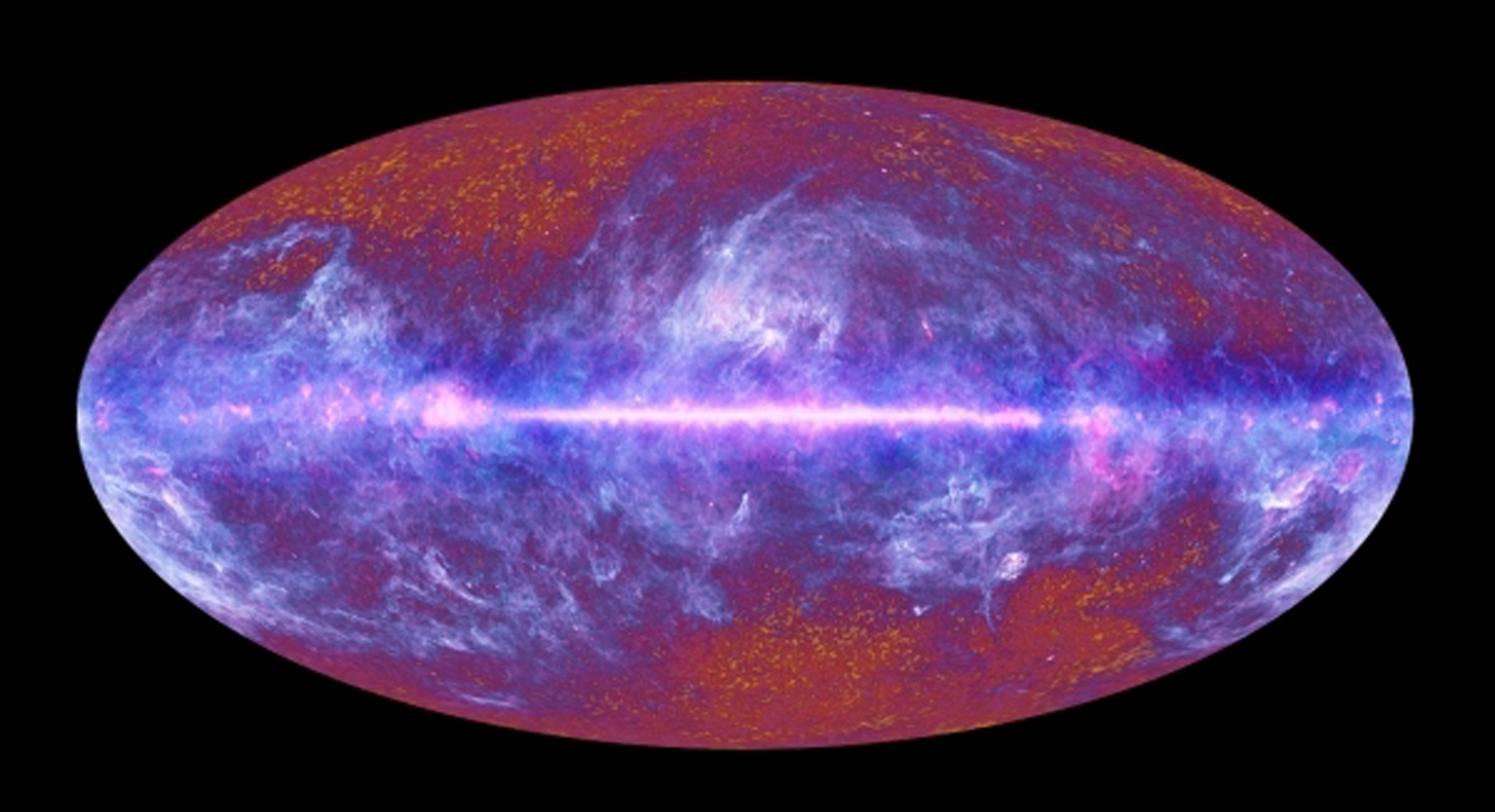

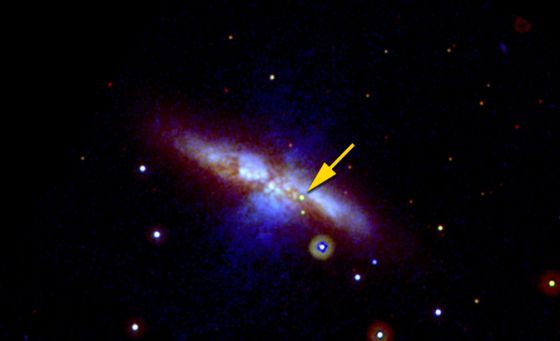

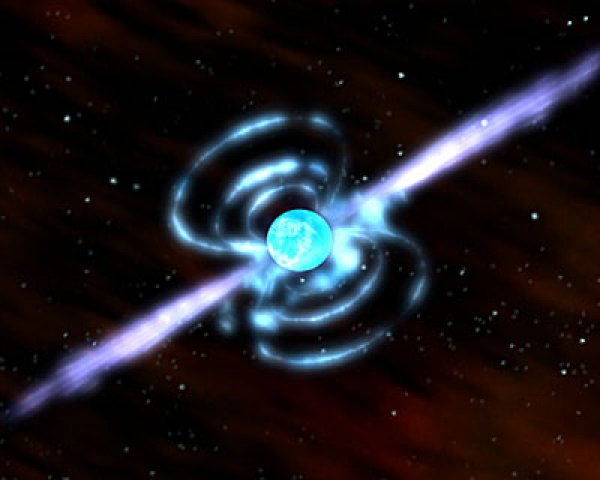

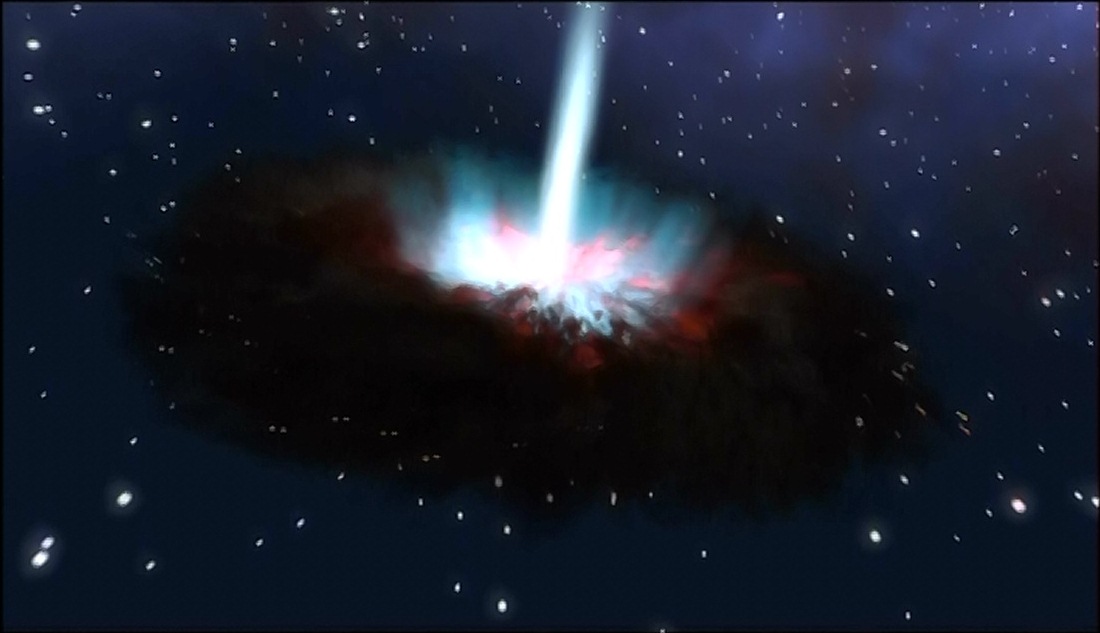

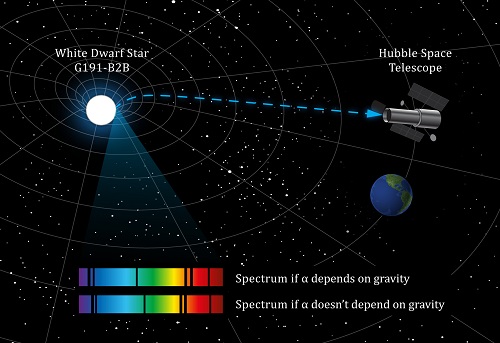

En este punto, los astrónomos se unen a la discusión. No es la primera vez, ni será la última, que la astronomía nos proporciona información esencial en relación a las partículas elementales. Por ejemplo, debido a las interacciones de corriente neutra (las interacciones débiles originadas por un intercambio Zº), los neutrinos son un facto crucial en la explosión supernova de una estrella. sabemos que debido a las interacciones por corriente neutra, pueden colisionar con las capas exteriores de la estrella y volarlas con una fuerza tremenda.

En realidad, los neutrinos nos tienen mucho que decir, todavía y, no lo sabemos todo acerca de ellos, sino que, al contrario, son muchos los y fenómenos que están y subyacen en ellos de los que no tenemos ni la menor idea que existan o se puedan producir. Nuestra ignorancia es grande, y, sin embargo, no nos arredra hablar y hablar de cuestiones que, la mayoría de las veces…ni comprendemos.

Aquí lo dejar´ñe por hoy, el tema es largo y de una fascinación que te puede llevar a lugares en los que no habías pensado al comenzar a escribir, lugares maravillosos donde reinan objetos exóticos y de fascinante porte que, por su pequeñez, pueden vivir en “mundos” muy diferentes al nuestro en los que, ocurren cosas que, nos llevan el asombro y también, a ese mundo mágico de lo fascinante y maravilloso.

Parece que el Modelo estándar no admite la cuarta fuerza y tendremos que buscar más profundamente, en otras teorías que nos hablen y describan además de las partículas conocidas de otras nuevas que están por nacer y que no excluya la Gravedad. Ese es el Modelo que necesitamos para conocer mejor la Naturaleza.

emilio silvera

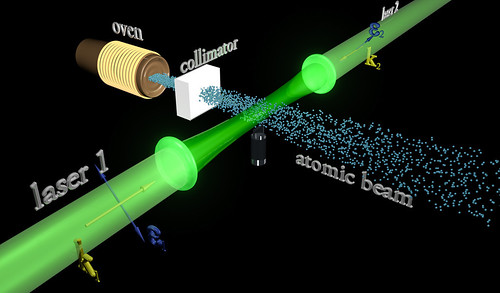

![[IMG]](http://static.hsw.com.br/gif/synchrotron-1.jpg)

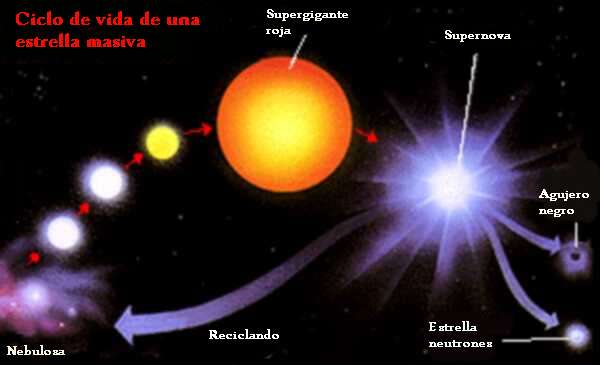

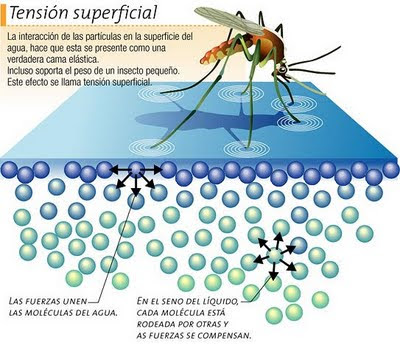

La mayor parte de los objetos que pueden verse en el cielo nocturno son estrellas, unos pocos centenares son visibles a simple vista. Una estrella es una bola caliente principalmente compuesta por hidrógeno gaseoso. El Sol es un ejemplo de una estrella típica y común. La gravedad impide que el gas se evapore en el espacio y la presión, debida a la alta temperatura de la estrella, y la densidad impiden que la bola encoja. En el corazón de la estrella, la temperatura y la densidad son lo suficientemente altas para sustentar a las reacciones de fusión nuclear, y la energía, producida por estas reacciones, hace su camino a la superficie y la irradia al espacio en forma de calor y luz. Cuando se agota el combustible de las reacciones de fusión, la estructura de la estrella cambia. El proceso de producir elementos, cada vez más pesados, a partir de los más livianos y de ajustar la estructura interna para balancear gravedad y presión, es llamado evolución estelar.

La mayor parte de los objetos que pueden verse en el cielo nocturno son estrellas, unos pocos centenares son visibles a simple vista. Una estrella es una bola caliente principalmente compuesta por hidrógeno gaseoso. El Sol es un ejemplo de una estrella típica y común. La gravedad impide que el gas se evapore en el espacio y la presión, debida a la alta temperatura de la estrella, y la densidad impiden que la bola encoja. En el corazón de la estrella, la temperatura y la densidad son lo suficientemente altas para sustentar a las reacciones de fusión nuclear, y la energía, producida por estas reacciones, hace su camino a la superficie y la irradia al espacio en forma de calor y luz. Cuando se agota el combustible de las reacciones de fusión, la estructura de la estrella cambia. El proceso de producir elementos, cada vez más pesados, a partir de los más livianos y de ajustar la estructura interna para balancear gravedad y presión, es llamado evolución estelar.

, requiriendo energía térmica cuántica comparable aproximadamente a la masa del mini

, requiriendo energía térmica cuántica comparable aproximadamente a la masa del mini

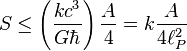

(Longitud de Planck que al cuadrado sería de 10-66 cm2)

(Longitud de Planck que al cuadrado sería de 10-66 cm2)

(M/d) × (m/d)

(M/d) × (m/d)

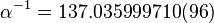

, fue el cociente de la velocidad del

, fue el cociente de la velocidad del  ) y la constante de estructura fina

) y la constante de estructura fina

, es la constante física que frecuentemente se define como el cuanto elemental de acción.

, es la constante física que frecuentemente se define como el cuanto elemental de acción.

, es la constante de Boltzmann.

, es la constante de Boltzmann.  , es la vecolcidad de la luz.

, es la vecolcidad de la luz.  , es la constante gravitacional universal.

, es la constante gravitacional universal. , es la

, es la  , es la

, es la