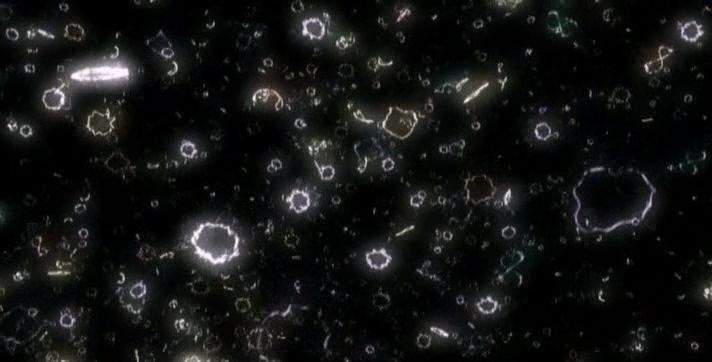

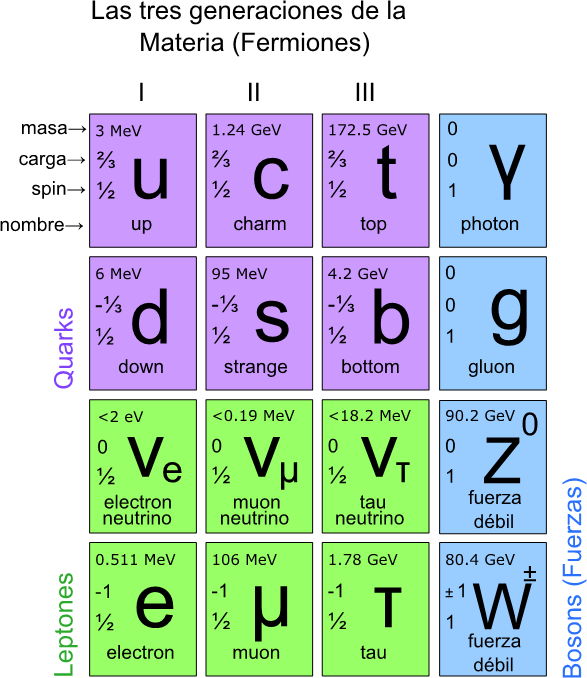

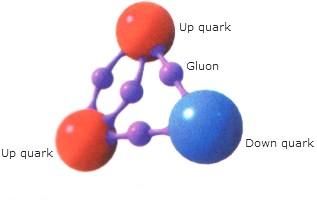

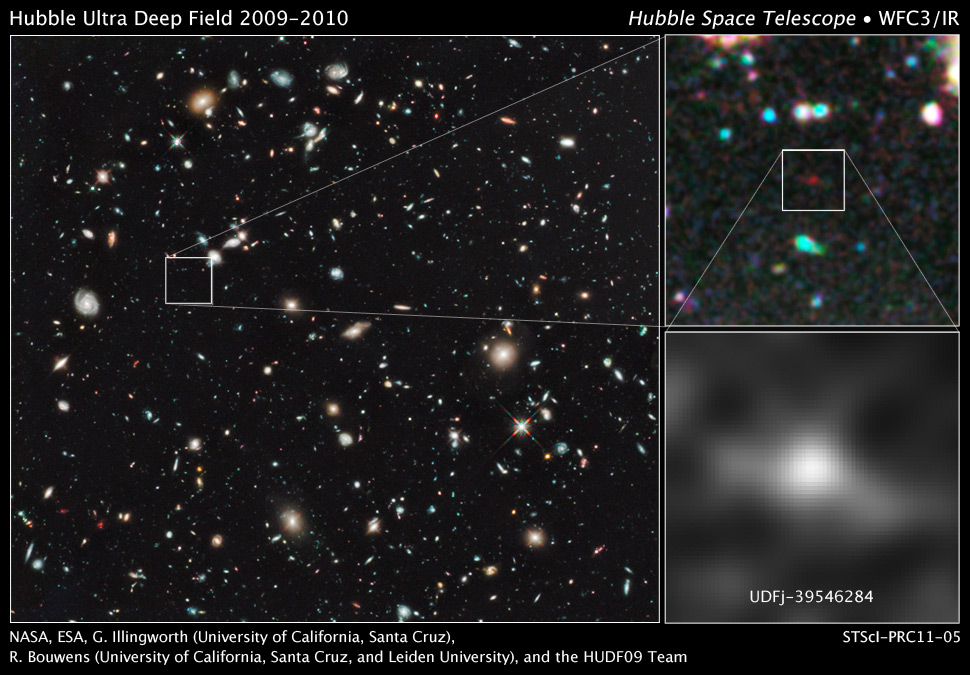

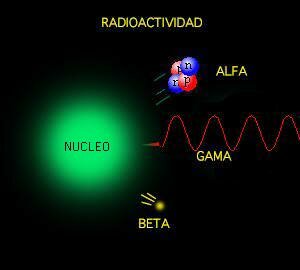

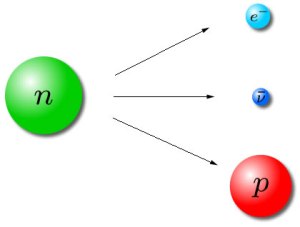

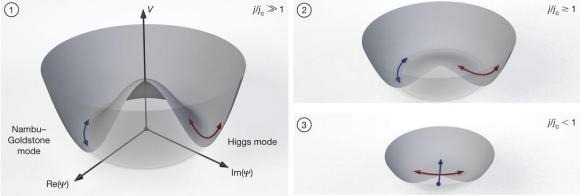

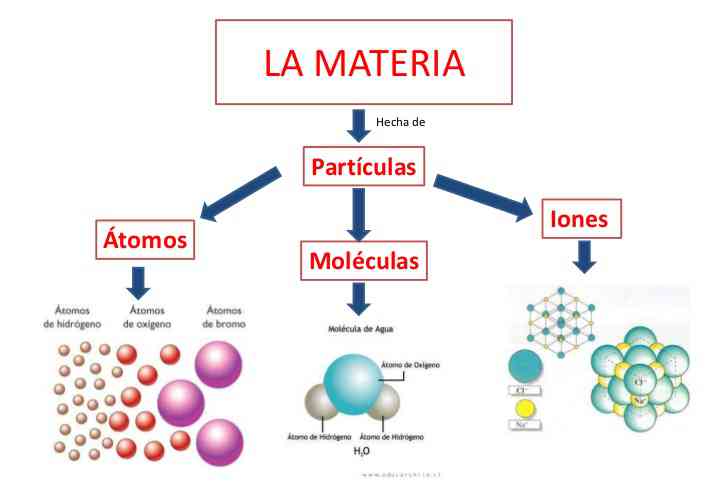

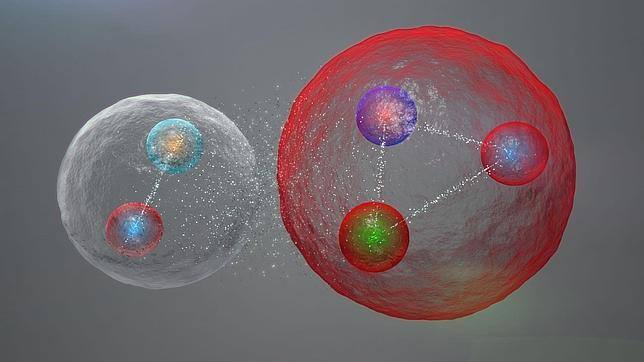

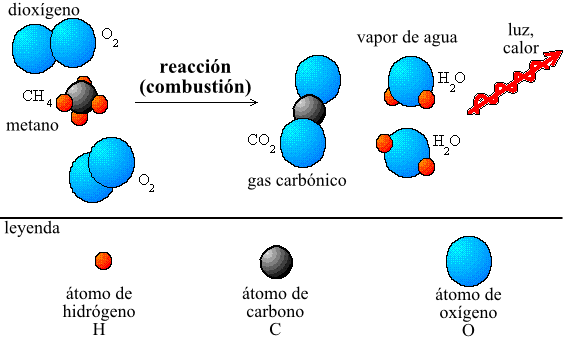

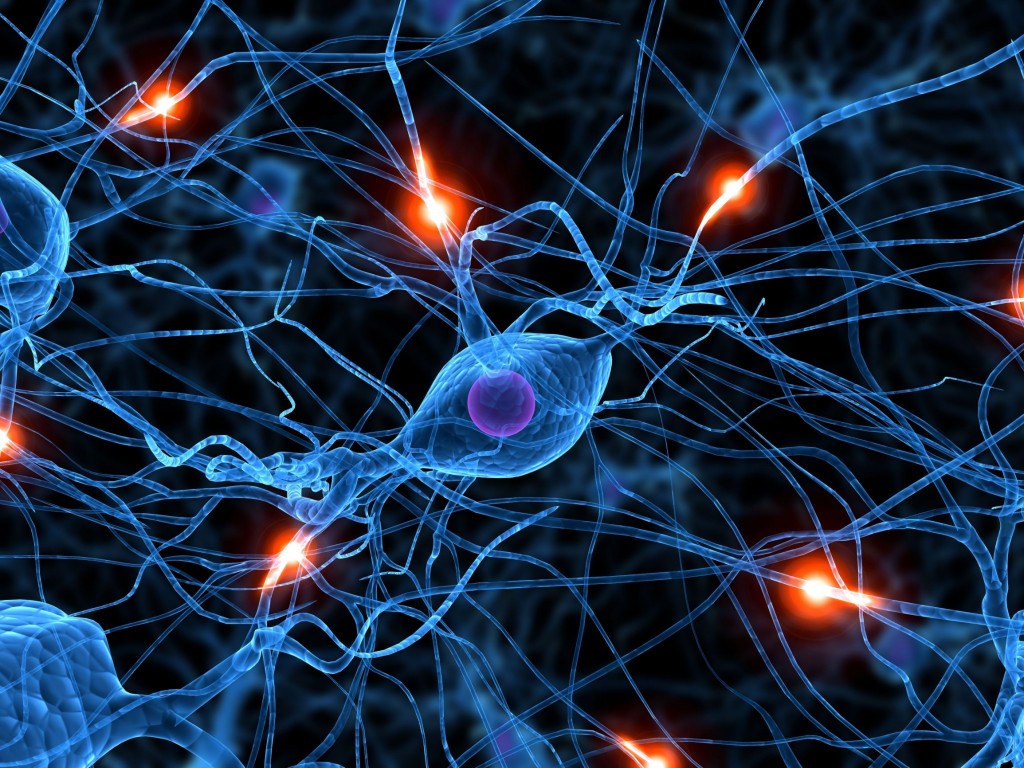

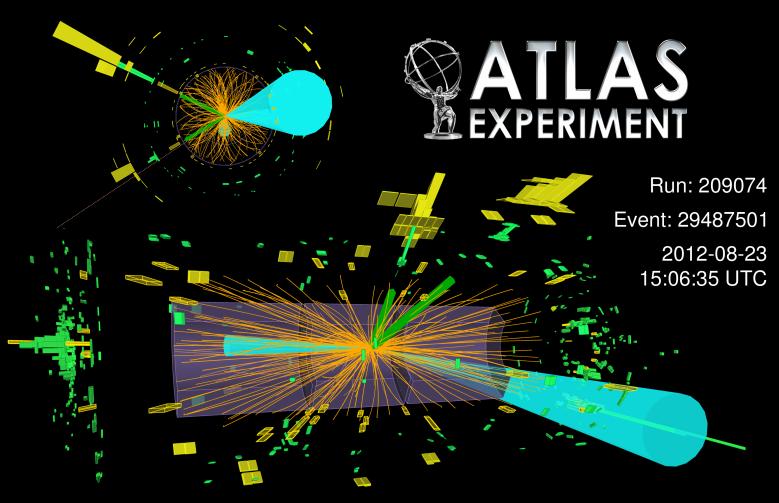

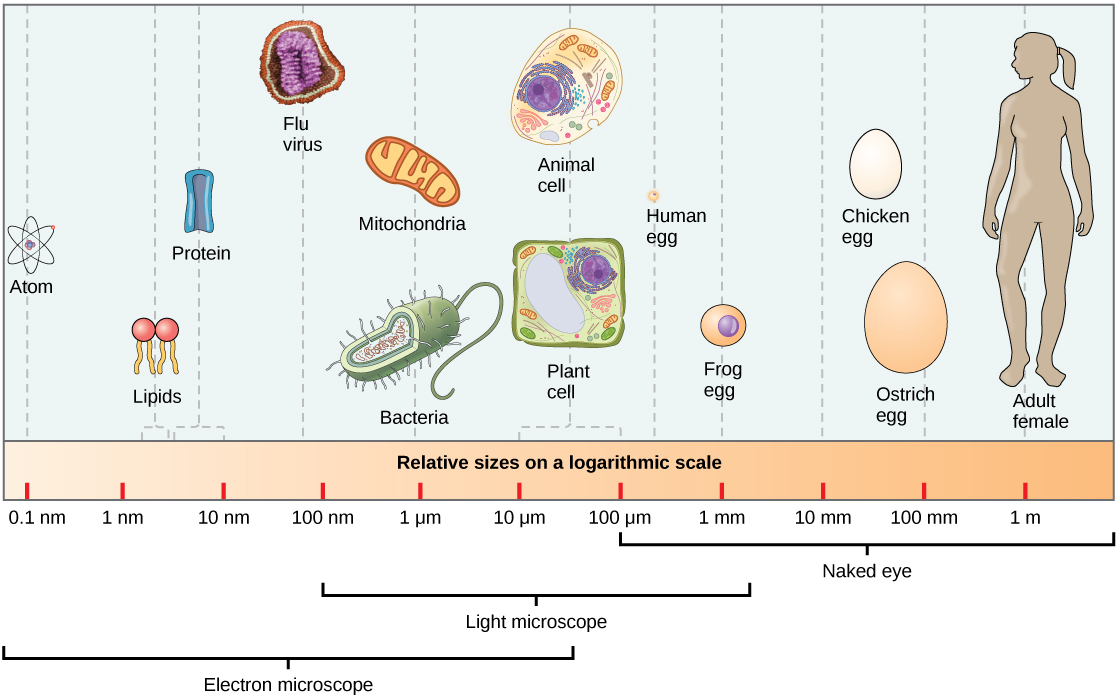

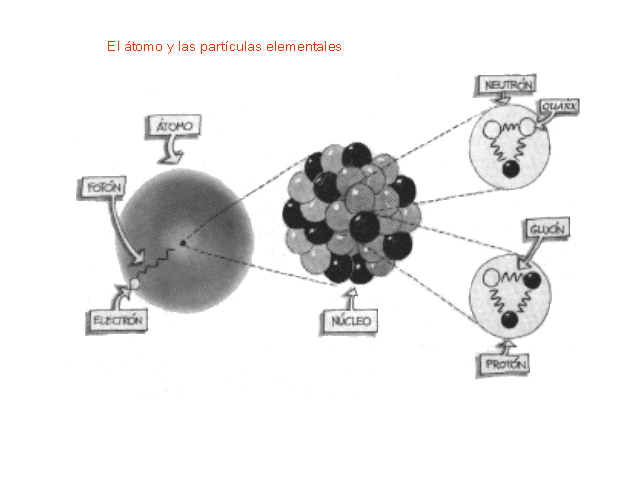

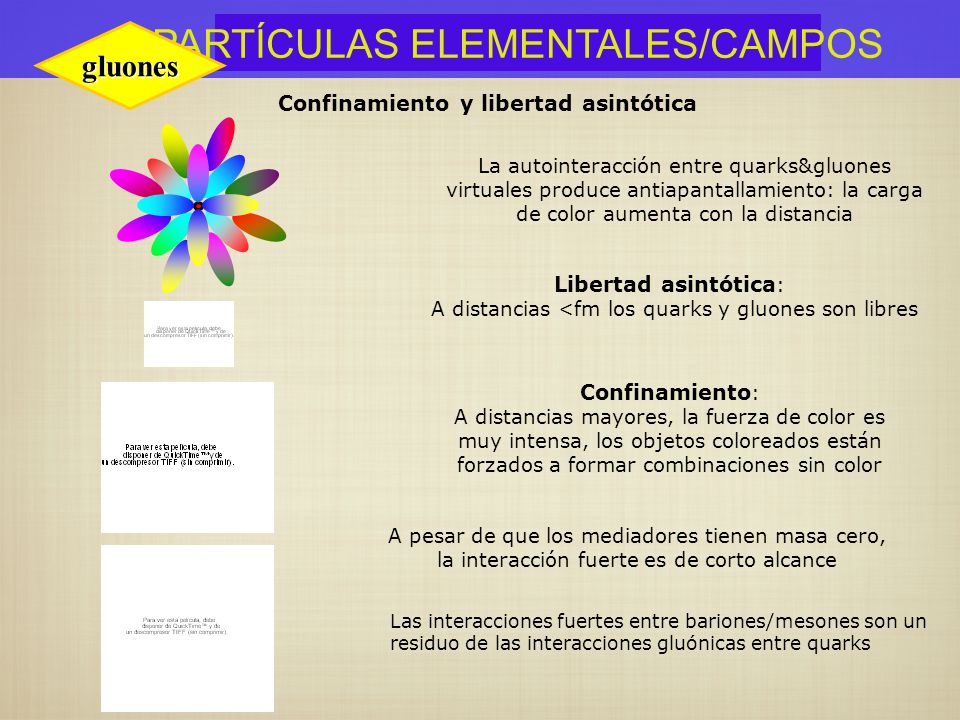

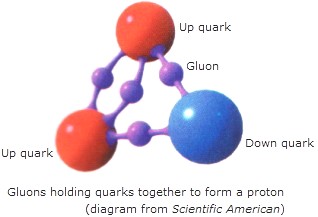

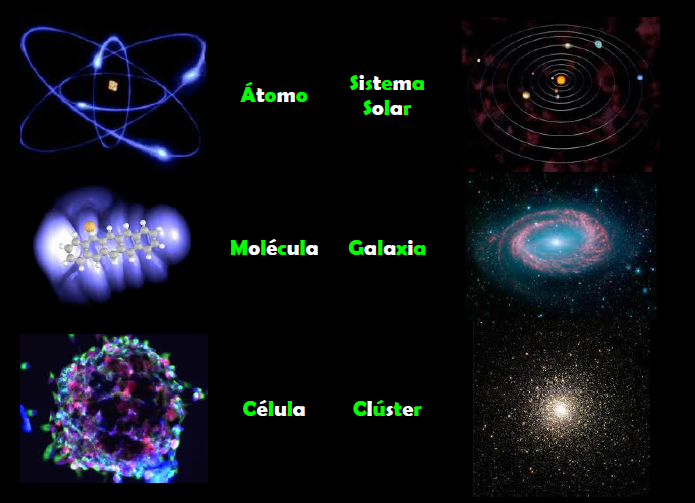

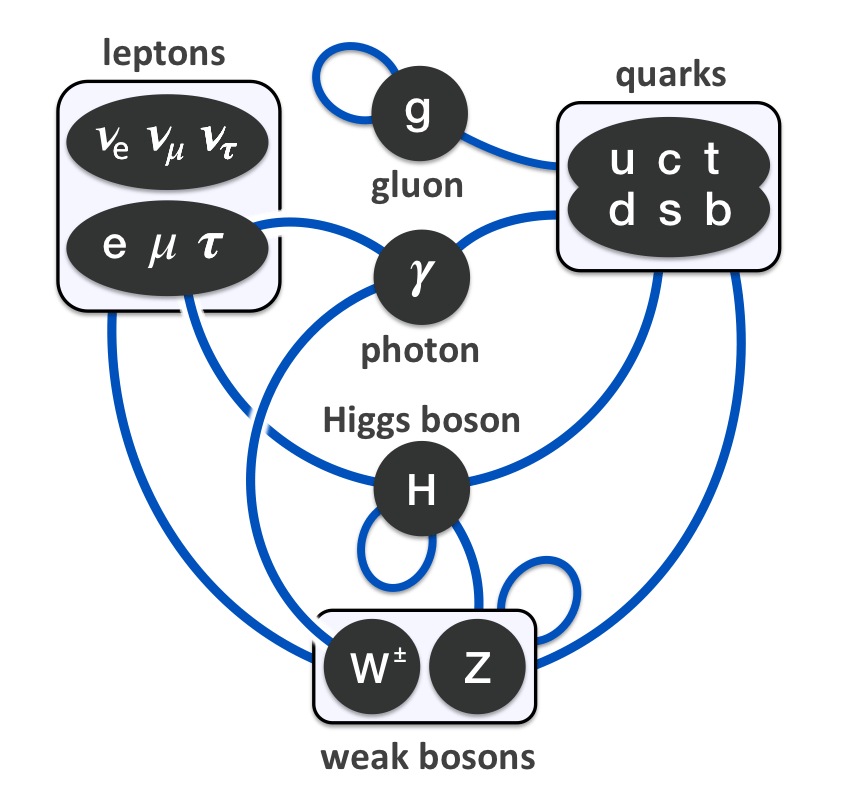

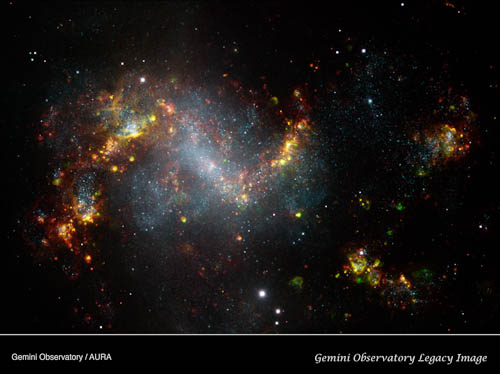

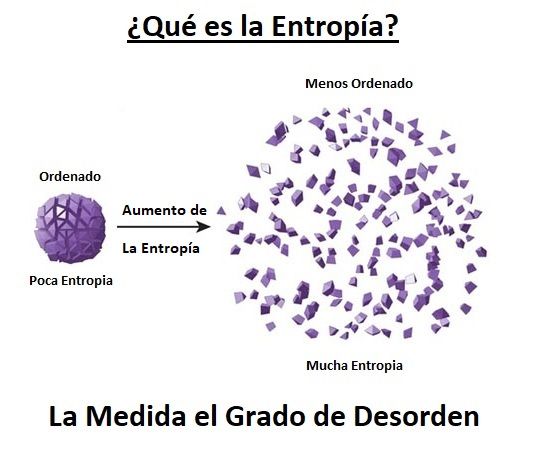

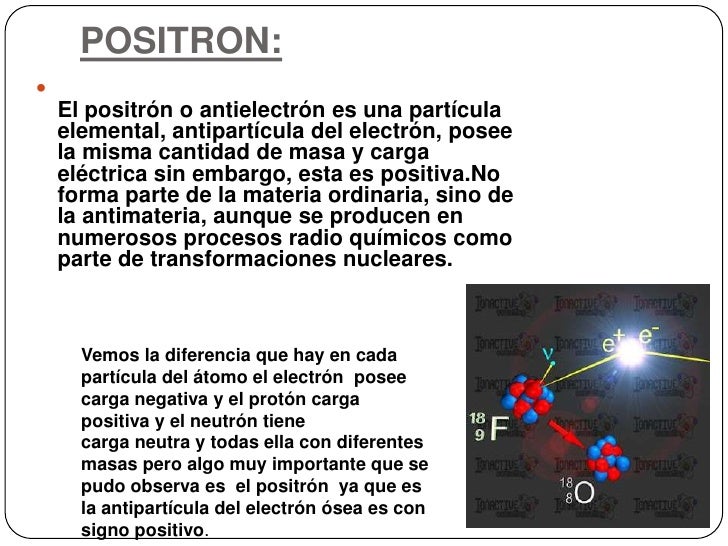

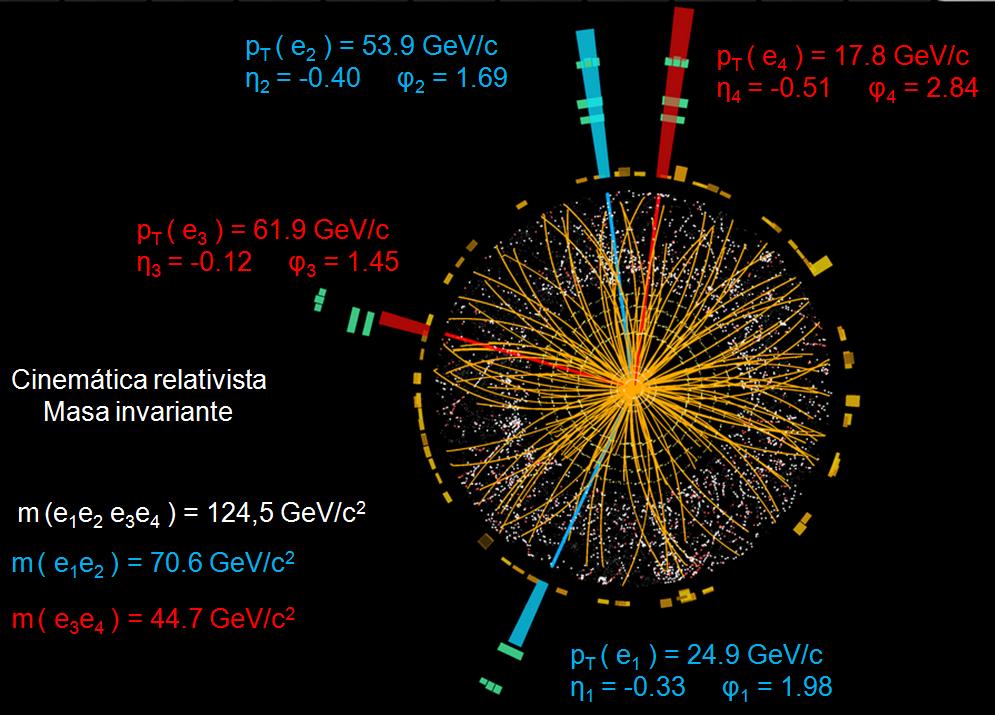

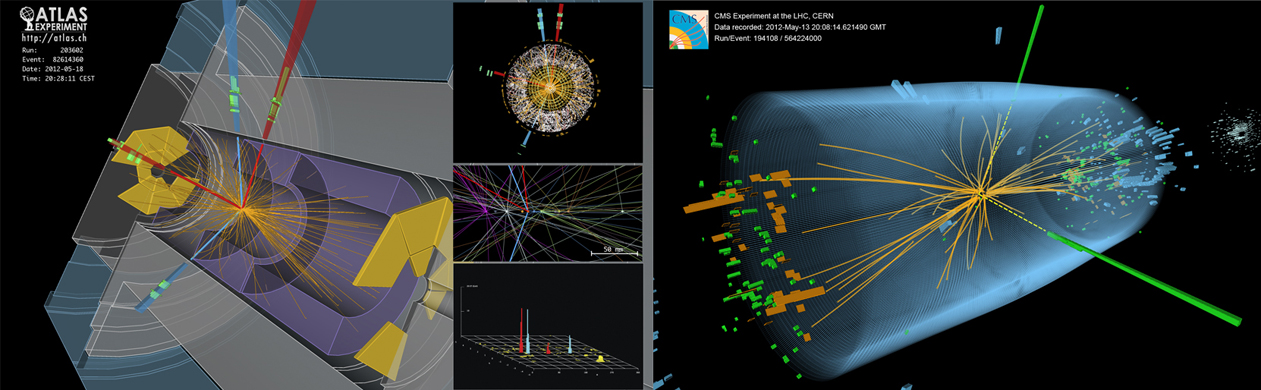

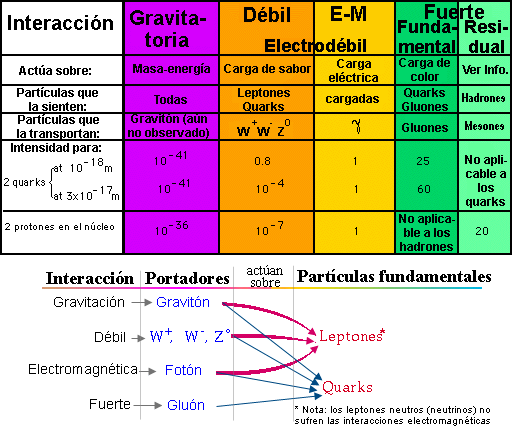

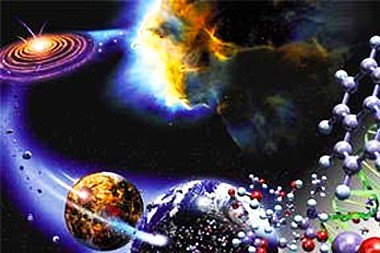

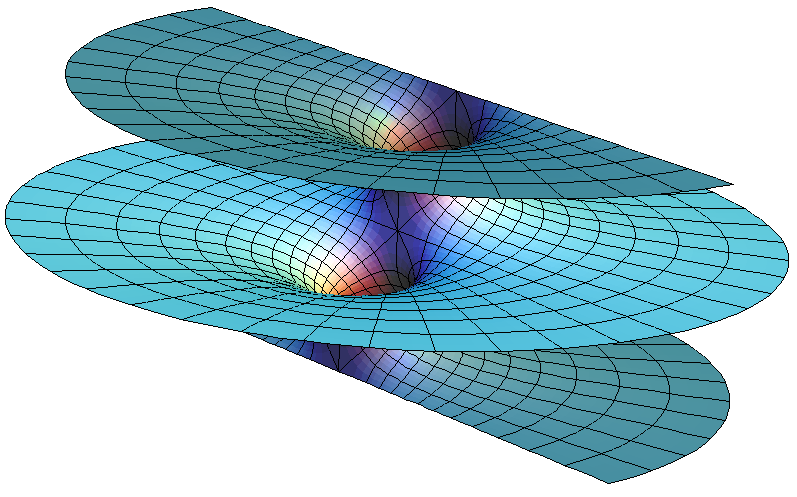

Todo comienza siendo una cosa y con el tiempo, se transforma en otra diferente: Evolución por la energía. En el universo en que vivimos, nada desaparece; con el tiempo se cumplen los ciclos de las cosas y se convierten en otra distinta, es un proceso irreversible. Estudiar en profundidad el simple proceso que siguen los Quarks -siempre con los Gluones pegados al culo- para poder formar el núcleo atómico, y, más tarde, que se forme el átomo, es una maravilla de la Naturaleza a la que no damos la importancia que verdaderamente tiene. Sin átomos… ¡No estaríamos! Todo lo que arriba nos muestrasn esas bellas imágenes son átomos que se juntaron para conformarlas.

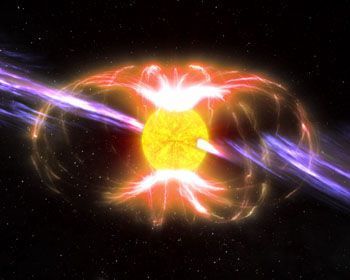

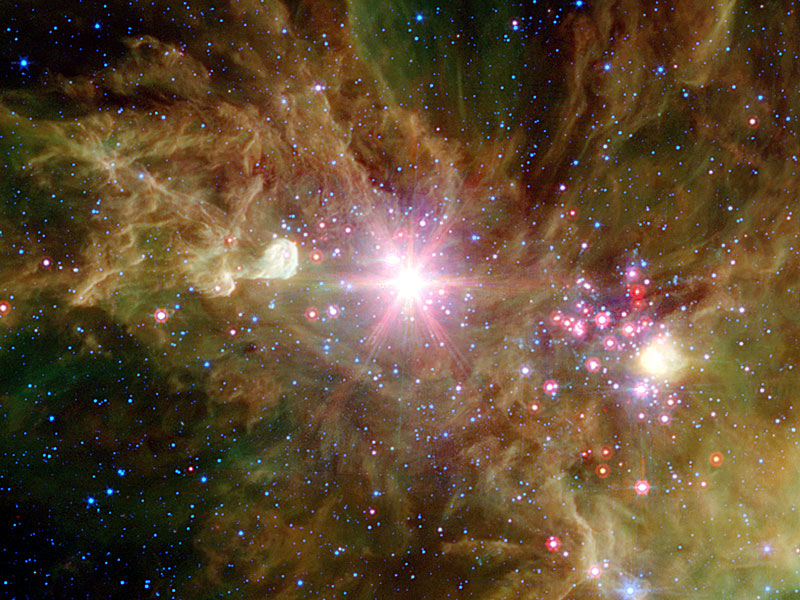

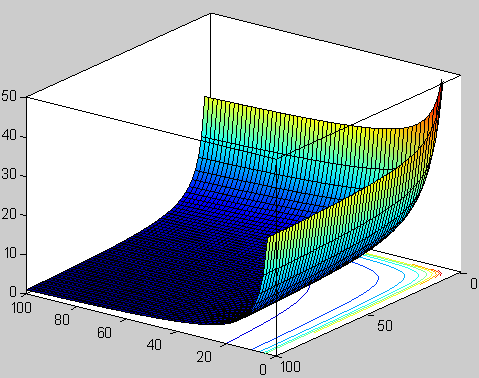

El gas y el polvo se transforma en una brillante estrella que vive diez mil millones de años y termina en Nebulosa planeta con una enana blanca en el centro. Entonces la estrella que tenía un diámetro de 1.500 km, se reduce hasta unas pocas decenas, 20 0 30 Km y, su densidad, es inmensa, emitiendo radiación ultravioleta durante mucjho tiempo hasta que se enfría y se convierte en un cadáver estelar.

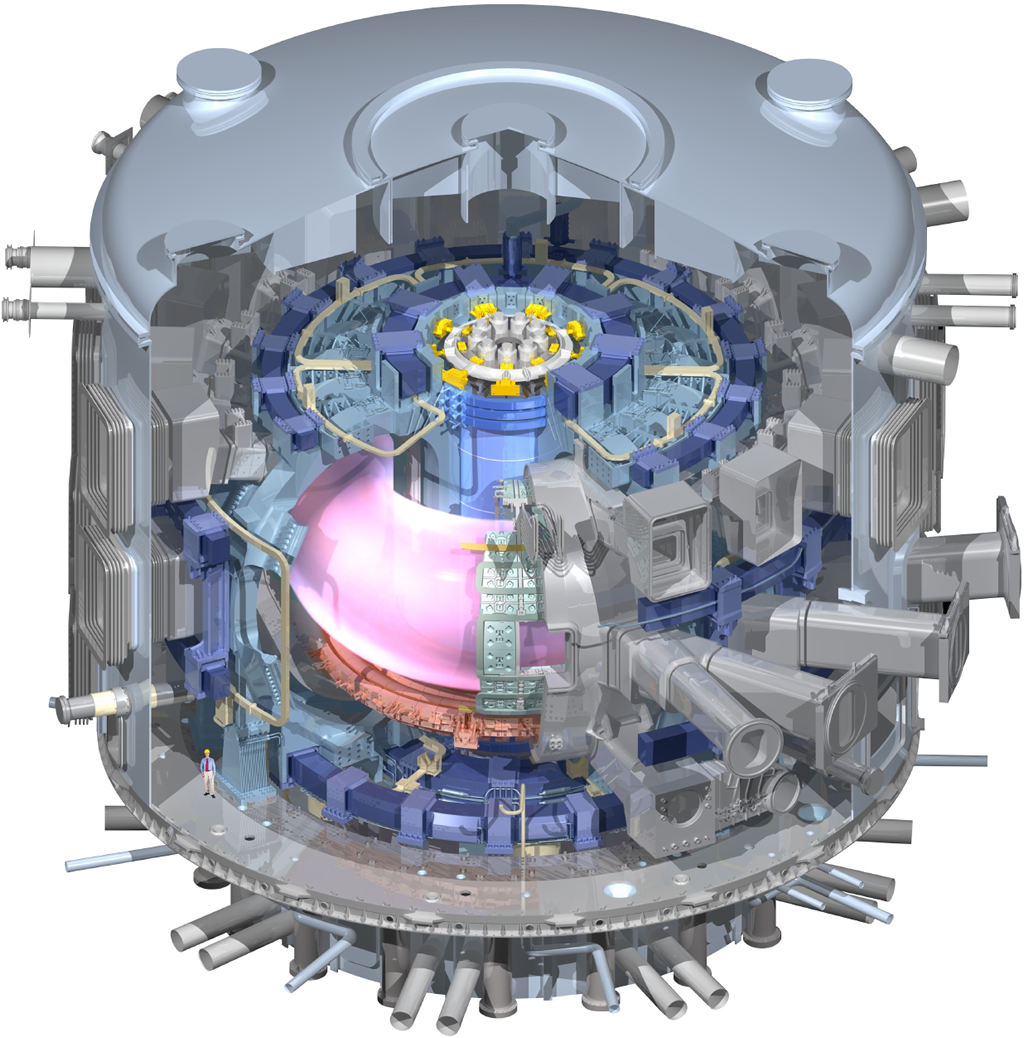

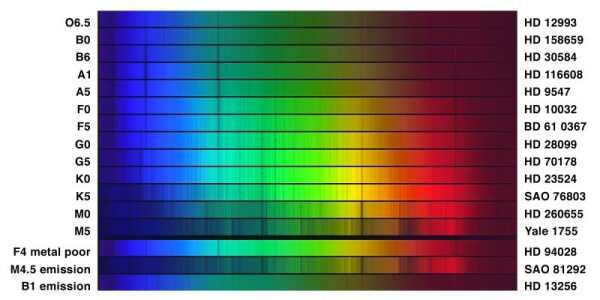

En lo concerniente a cambios y transformaciones, el que más me ha llamado siempre la atención es el de las estrellas que se forman a partir de gas y polvo cósmico. Nubes enormes de gas y polvo se van juntando. Sus moléculas cada vez más apretadas se rozan, se ionizan y se calientan hasta que en el núcleo central de esa bola de gas caliente, la temperatura alcanza millones de grados. La enorme temperatura posible la fusión de los protones y, en ese instante, nace la estrella que brillará miles de millones de años y dará luz y calor. Su ciclo de vida estará supeditado a su masa. Si la estrella es supermasiva, varias masas solares, su vida será más corta, ya que consumirá el combustible nuclear de fusión (hidrógeno, helio, litio, oxígeno, etc) con más voracidad que una estrella mediana como nuestro Sol, de vida más duradera.

Cuando agotan el combustible nuclear de fusión, se convierten en otros objetos diferentes. Mientras tanto, durante miles de años fusionan materiales sencillos en otros más complejos y, alcanzan la estabilidad debido a las dos fuerzas contrapuestas: La Radiación que tiene a expandir la masa estelar, y, la Gravedad que trata de comprimirla.

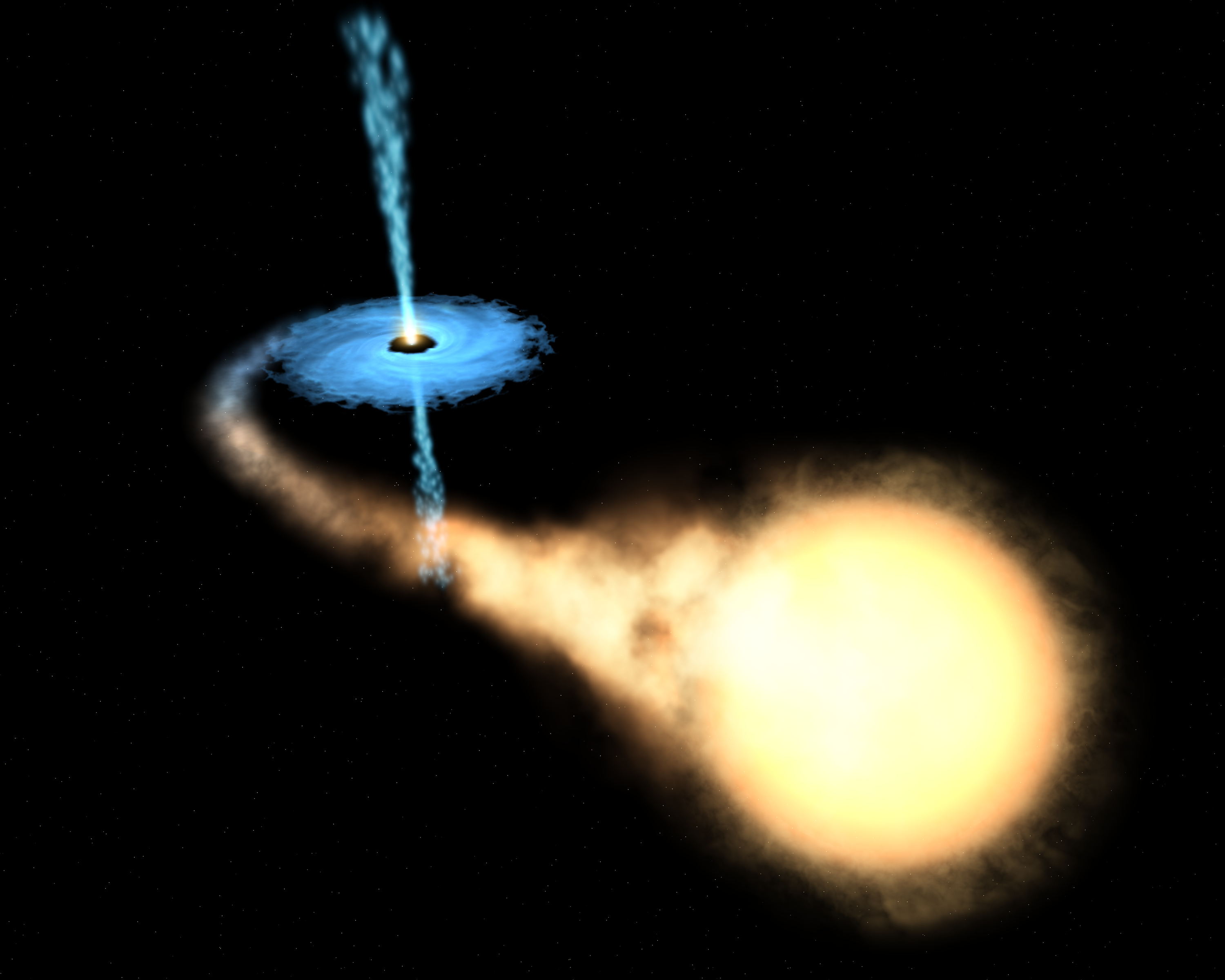

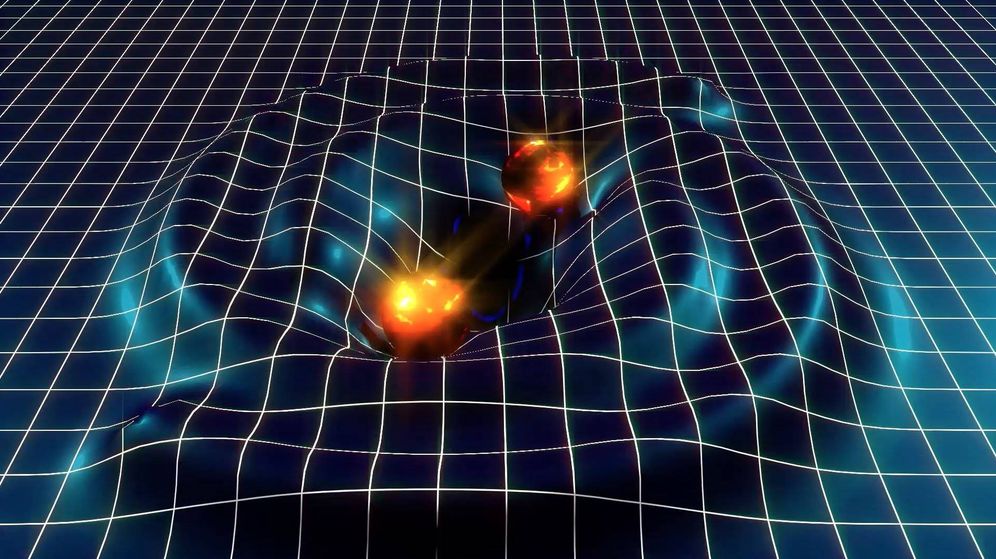

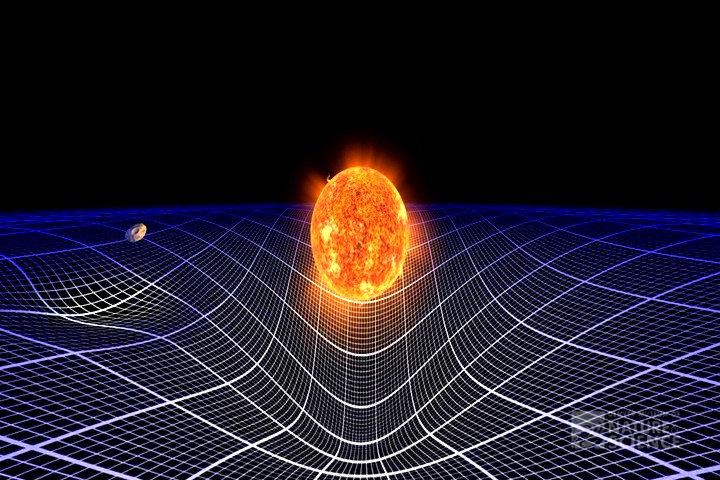

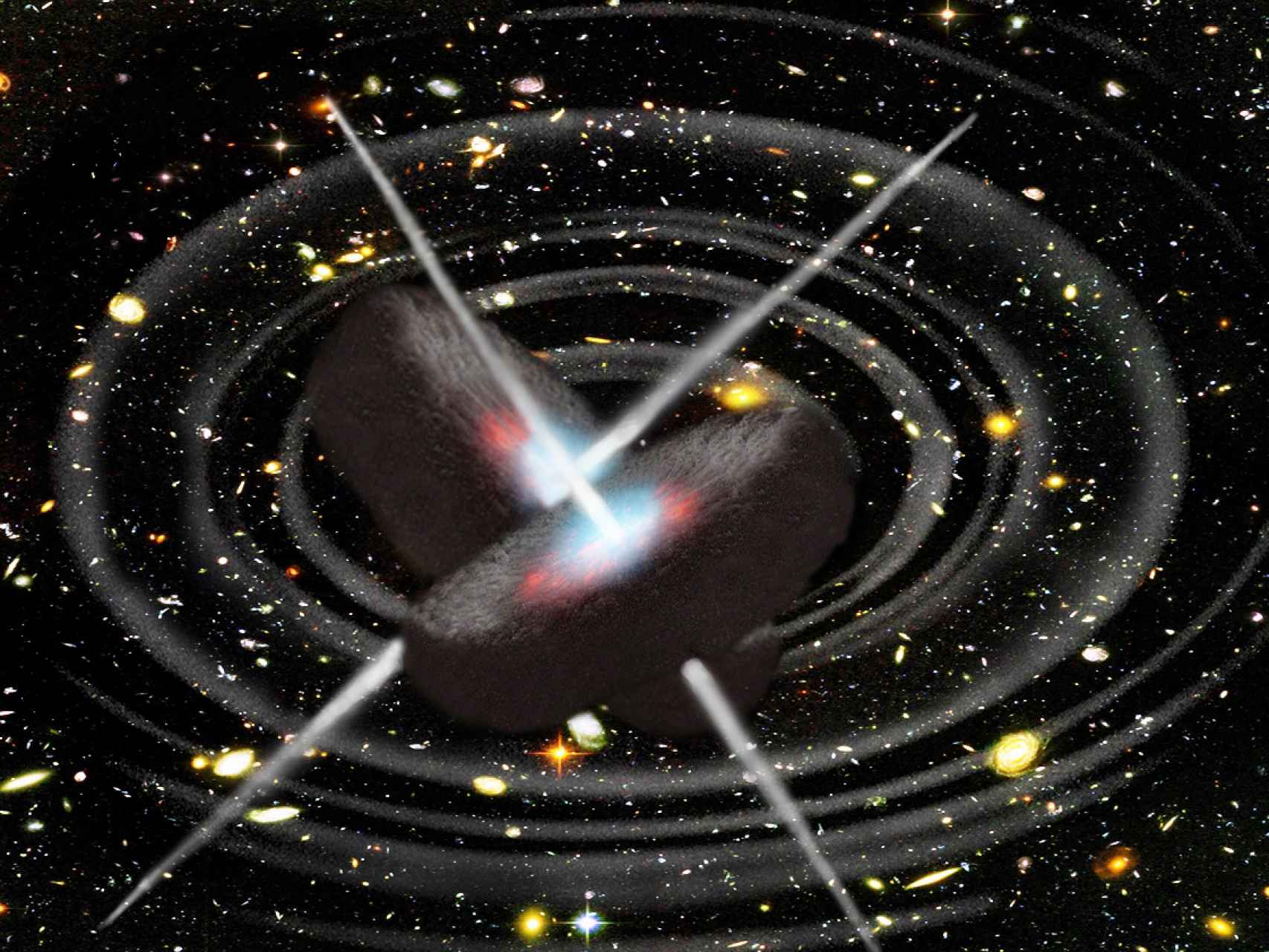

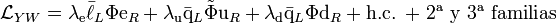

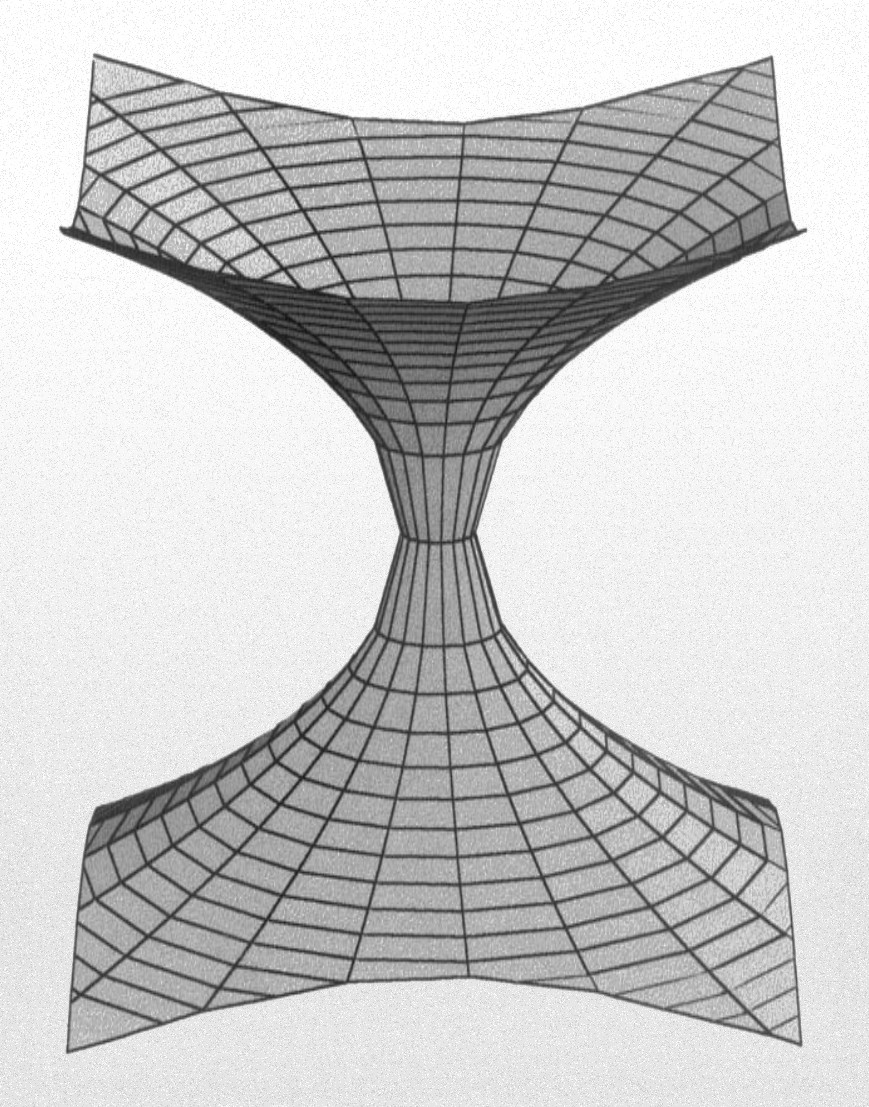

Una estrella, como todo en el universo, está sostenida por el equilibrio de dos fuerzas contrapuestas; en caso, la fuerza que tiende a expandir la estrella (la energía termonuclear de la fusión) y la fuerza que tiende a contraerla (la fuerza gravitatoria de su propia masa). Cuando finalmente el proceso de fusión se detiene por agotamiento del combustible de fusión, la estrella pierde la fuerza de expansión y queda a merced de la fuerza de gravedad; se hunde bajo el peso de su propia masa, se contrae más y más, y en el caso de estrellas súper masivas, se convierten en una singularidad, una masa que se ha comprimido a tal extremo que acaba poseyendo una fuerza de gravedad de una magnitud difícil de imaginar el común de los mortales.

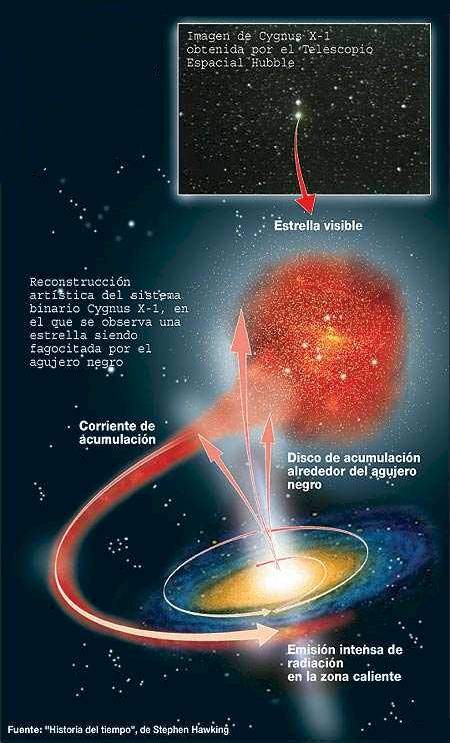

La singularidad con su inmensa fuerza gravitatoria atrae a la estrella vecina

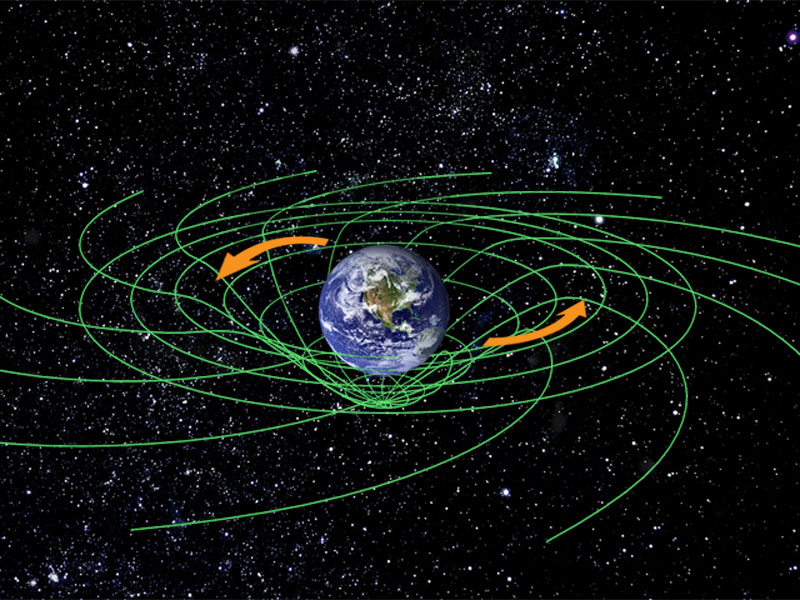

La Tierra, un objeto minúsculo en comparación con esos objetos súper masivos estelares, genera una fuerza de gravedad que, para escapar de ella, una nave o cohete espacial tiene que salir disparado la superficie terrestre a una velocidad de 11’18 km/s; el sol exige 617’3 km/s. Es lo que se conoce como velocidad de escape, que es la velocidad mínima requerida escapar de un campo gravitacional que, lógicamente, aumenta en función de la masa del objeto que la produce. El objeto que escapa puede ser una cosa cualquiera, desde una molécula de gas a una nave espacial. La velocidad de escape de un cuerpo está dada por , donde G es la constante gravitacional, M es la masa del cuerpo y R es la distancia del objeto que escapa del centro del cuerpo. Un objeto que se mueva con una velocidad menor que la de escape entra en una órbita elíptica; si se mueve a una velocidad exactamente igual a la de escape, sigue una órbita , y si el objeto supera la velocidad de escape, se mueve en una trayectoria hiperbólica y rompe la atadura en que la mantenía sujeto al planeta, la estrella o el objeto que emite la fuerza gravitatoria.

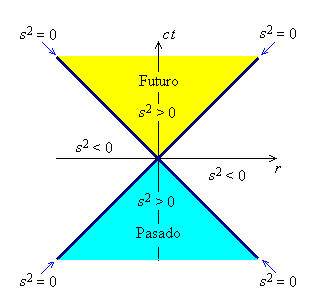

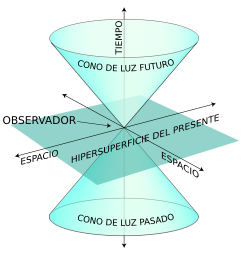

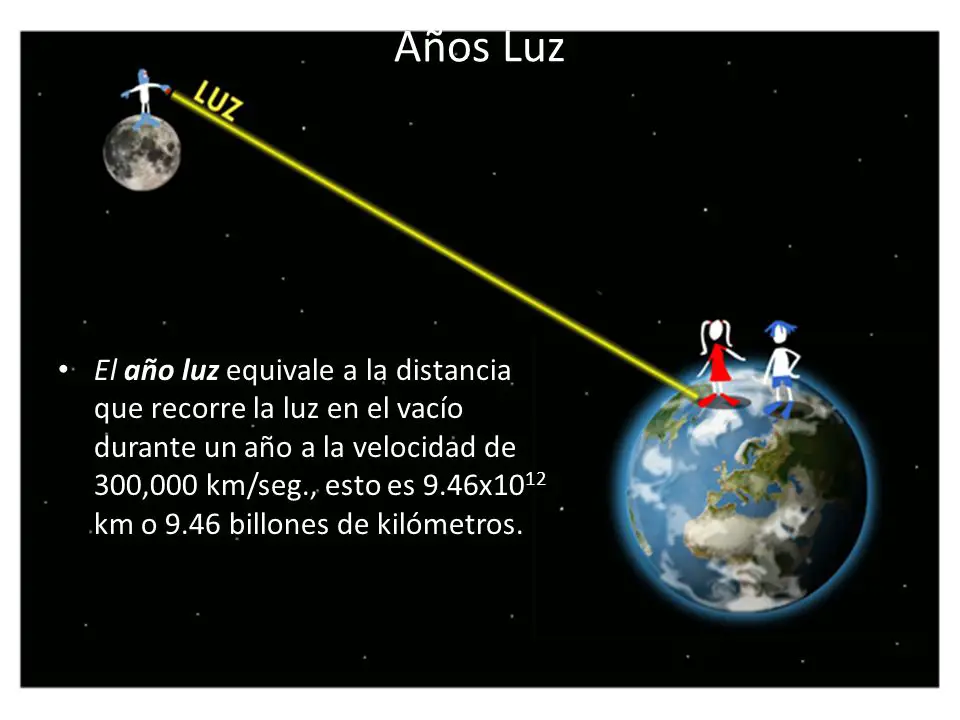

La mayor velocidad que es posible alcanzar en nuestro universo es la de la luz, c, velocidad que la luz alcanza en el vacío y que es de 299.793’458 km/s.

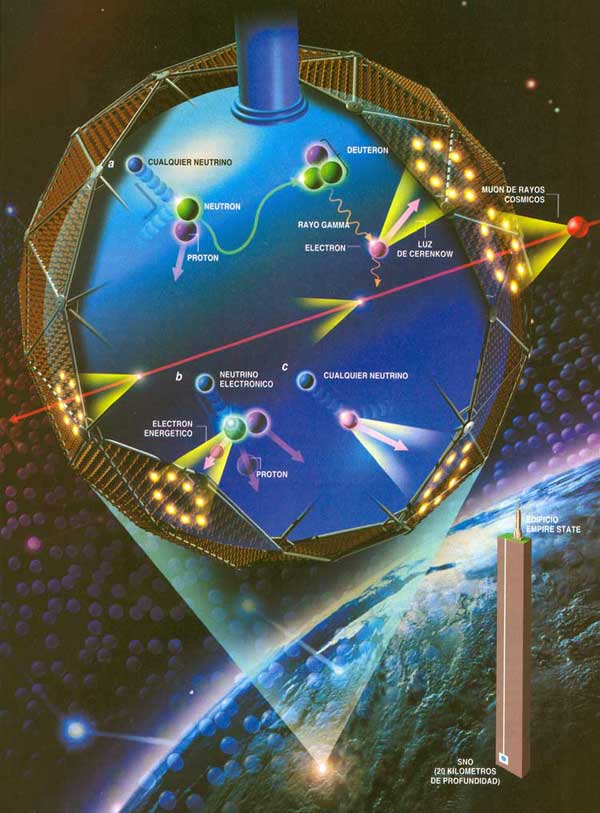

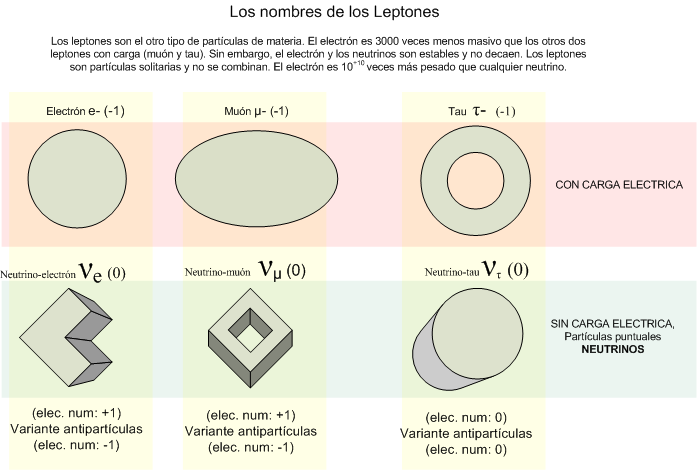

Sí, se pudo confirmar que los neutrinos respetan la supremacía del fotón, y la luz, sigue siendo la más rápida del Universo. Y sin embargo, no escapar de la atracción de un A.N. Los neutrinos, según todos los indicios, tiene una ínfima masa que les hace diferentes de los fotones que, en reposo, no tienen masa.

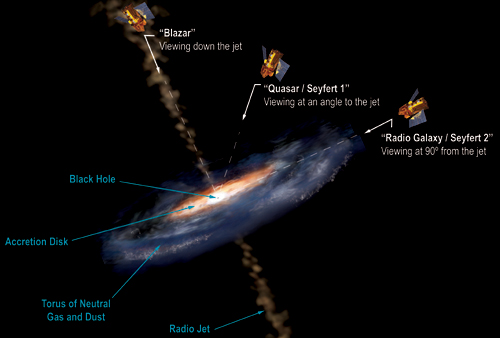

Pues bien, es tal la fuerza de gravedad de un agujero negro que ni la luz puede escapar de allí; la singularidad la absorbe, la luz desaparece en su interior, de ahí su , agujero negro, la estrella supermasiva se contrae, llega a un punto que desaparece de nuestra vista. De acuerdo con la relatividadgeneral, cabe la posibilidad de que una masa se comprima y reduzca sin límites su tamaño y se auto confine en un espacio infinitamente pequeño que encierre una densidad y una energía infinitos. Allí, el espacio y el tiempo dejan de existir.

Las singularidades ocurren en el Big Bang, en los agujeros negros y en el Big Crunch (que se podría considerar una reunión de todos los agujeros negros generados por el paso del tiempo en el universo y que nos llevará a un fin que será el comienzo).

Las singularidades de los agujeros negros están rodeados por una circunferencia invisible a su alrededor que marca el límite de su influencia. El objeto que traspasa ese límite es atraído, irremisiblemente, la singularidad que lo engulle, sea una estrella, una nube de gas o cualquier otro objeto cósmico que ose traspasar la línea que se conoce como horizonte de sucesos del agujero negro.

La existencia de los agujeros negros fue deducida por Schwarzschild, en el año 1.916, a partir de las ecuaciones de Einstein de la relatividad general. Este astrónomo alemán predijo su existencia, pero el de agujero negro se debe a Wehleer.

Señalamos la singularidad del Big Bang pero… ¿fue así?

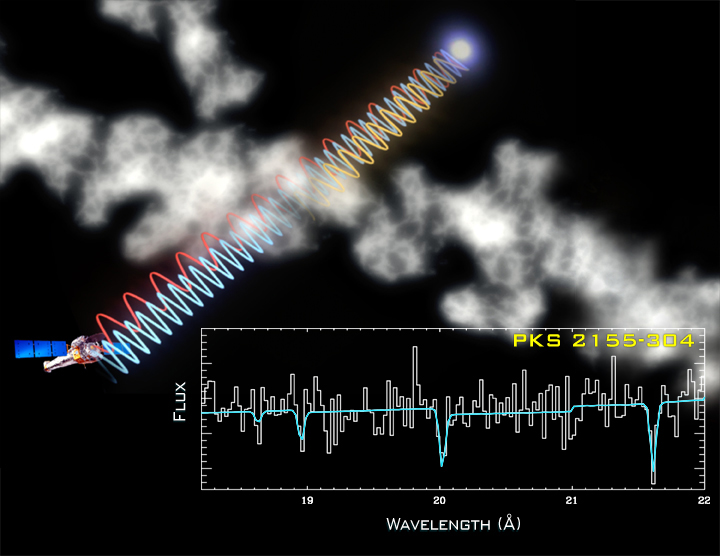

Así, el conocimiento de la singularidad está dado por las matemáticas de Einstein y más tarde por la observación de las señales que la presencia del agujero generan. Es una fuente emisora de rayos X que se producen al engullir materia que traspasa el horizonte de sucesos y es atrapada la singularidad, donde desaparece siempre sumándose a la masa del agujero cada vez mayor.

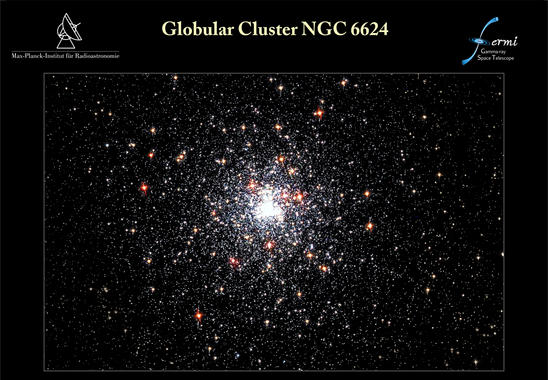

En el centro de nuestra galaxia, la Vía Láctea, ha sido detectado un enorme agujero negro, ya muy famoso, llamado Cygnus X-1. Después de todo, la velocidad de la luz, la máxima del universo, no vencer la fuerza de gravedad del agujero negro que la tiene confinada para siempre. En nuestra galaxia, con cien mil años luz de diámetro y unos doscientos mil millones de estrellas, ¿cuántos agujeros negros habrá?

Para mí, la cosa está clara: el tiempo es imparable, el reloj cósmico sigue y sigue andando sin que nada lo pare, miles o cientos de miles, millones y millones de estrellas súper masivas explotarán en brillantes supernovas para convertirse en temibles agujeros negros. Llegará un momento que el de agujeros negrosen las galaxias será de tal magnitud que comenzarán a fusionarse unos con otros que todo el universo se convierta en un inmenso agujero negro, una enorme singularidad, lo único que allí estará presente: la gravedad.

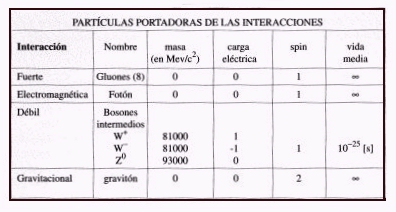

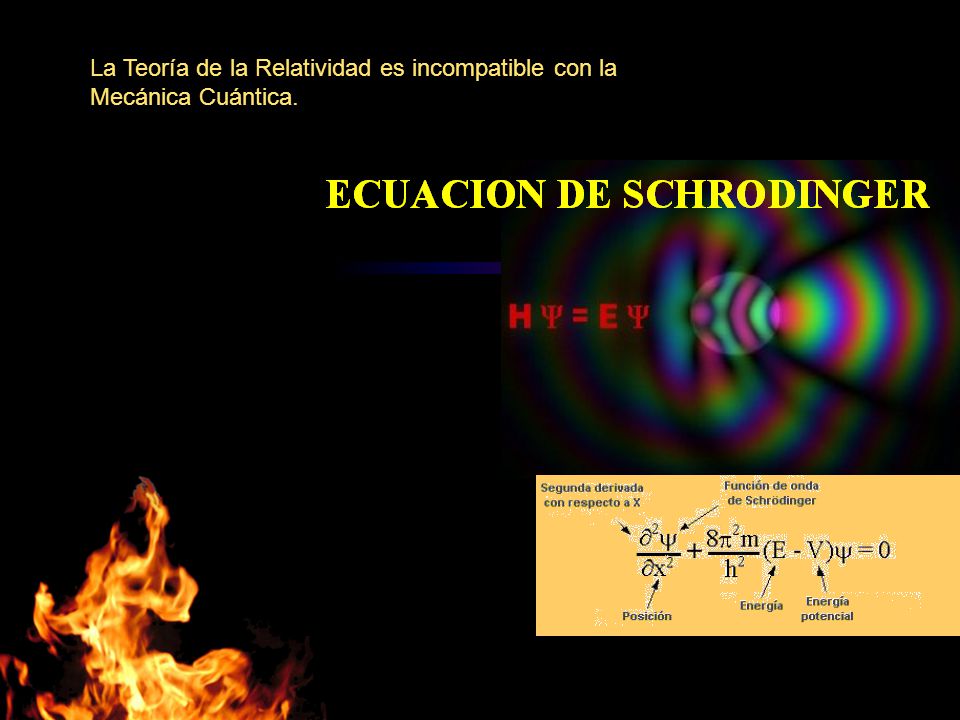

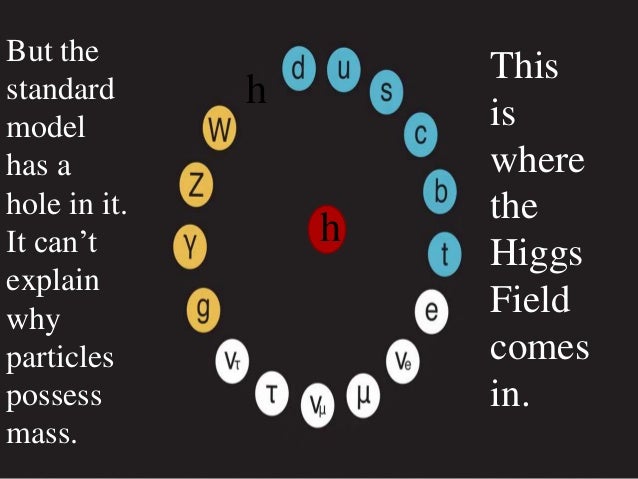

Esa fuerza de la naturaleza que está sola, no se puede juntar con las otras fuerzas que, como se ha dicho, tienen sus dominios en la mecánica cuántica, mientras que la gravitación residen en la inmensidad del cosmos; las unas ejercen su dominio en los confines microscópicos del átomo, mientras que la otra sólo aparece de manera significativa en presencia de grandes masas estelares. Allí, a su alrededor, se aposenta curvando el espacio y distorsionando el tiempo.

Esa reunión final de agujeros negros será la causa de que la Densidad Crítica sea superior a la ideal. La gravedad generada por el inmenso agujero negro que se irá formando en cada galaxia tendrá la consecuencia de parar la expansión actual del universo. Todas las galaxias que ahora están separándose las unas de las otras se irán frenando parar y, despacio al principio pero más rápido después, comenzarán a recorrer el camino hacia atrás. Finalmente, toda la materia será encontrada en un punto común donde chocará violentamente formando una enorme bola de fuego, el Big Crunch.

de que eso llegue, tendremos que resolver el primer problema: la muerte del Sol.

Aquí se refleja el ciclo que seguirá el Sol hasta convertirse en enana blanca

Los científicos se han preguntado a veces qué sucederá eventualmente a los átomos de nuestros cuerpos mucho tiempo después de que hayamos muerto. La posibilidad más probable es que nuestras moléculas vuelvan al Sol. En páginas anteriores he explicado el destino del Sol: se agotará su combustible de hidrógeno y fusionará helio; se hinchará en gigante roja y su órbita es probable que sobrepase la Tierra y la calcine; las moléculas que hoy constituyen nuestros cuerpos serán consumidas por la atmósfera solar.

Carl Sagan pinta el cuadro siguiente:

“Dentro de miles de millones de años a partir de , habrá un último día perfecto en la Tierra… Las capas de hielo Ártica y Antártica se fundirán, inundando las costas del mundo. Las altas temperaturas oceánicas liberarán más vapor de agua al aire, incrementando la nubosidad y escondiendo a la Tierra de la luz solar retrasando el final. Pero la evolución solar es inexorable. Finalmente los océanos hervirán, la atmósfera se evaporará en el espacio y nuestro planeta será destruido por una catástrofe de proporciones que ni podemos imaginar.”

En una escala de tiempo de varios miles de millones de años, debemos enfrentarnos al hecho de que la Vía Láctea, en la que vivimos, morirá. Más exactamente, vivimos en el brazo espiral Orión de la Vía Láctea. miramos al cielo nocturno y nos sentimos reducidos, empequeñecidos por la inmensidad de las luces celestes que puntúan en el cielo, estamos mirando realmente una minúscula porción de las estrellas localizadas en el brazo de Orión. El resto de los 200 mil millones de estrellas de la Vía Láctea están tan lejanas que apenas pueden ser vistas como una cinta lechosa que cruza el cielo nocturno.

Aproximadamente a dos millones de años luz de la Vía Láctea está nuestra galaxia vecina más cercana, la gran galaxia Andrómeda, dos o tres veces mayor que nuestra galaxia. Las dos galaxias se están aproximando a unos 500 km/s, y chocarán en un periodo de entre 3 y 4 mil millones de años. Como ha dicho el astrónomo Lars Hernquist de la California en Santa Cruz, esta colisión será “parecida a un asalto. Nuestra galaxia será literalmente consumida y destruida“. Aunque, lo cierto es que aunque en el choque algo se detruya, lo cierto es que todo quedará en forma de una galaxia mucho mayor.

Así las cosas, no parece que la Humanidad del futuro lo tenga nada fácil. Primero tendrá que escapar, dentro de unos 4.000 millones de años del gigante rojo en que se convertirá el Sol que calcinará al planeta Tierra. Segundo, en unos 10.000 millones de años, la escapada tendrá que ser aún más lejana; la destrucción será de la propia galaxia que se fusionará con otra mayor sembrando el caos cósmico del que difícilmente se podría escapar quedándonos aquí. Por último, el final anunciado, aunque más largo tiempo, es el del propio universo que, por congelación o fuego, tiene los eones contados.

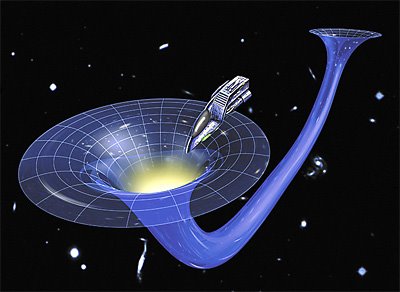

Por todas estas catástrofes anunciadas por la ciencia, científicos como Kip S. Thorne y Stephen Hawking sugieren a otros universos paralelos a través de agujeros de gusano en el hiperespacio. Sería la única puerta de salida para que la Humanidad no se destruyera.

Si lo alcanzaremos o no, es imposible de contestar, no tenemos los necesarios para ello. Incluso se podría decir que aparte de estas catástrofes futuras que sabemos a ciencia cierta que ocurrirán, seguramente existan otras que están ahí latentes en la incertidumbre de si finalmente ocurren o no, sólo pendiente de decidir lo uno o lo otro por parámetros ocultos que no sabemos ni que puedan existir.

En esta situación de impotencia, de incapacidad física e intelectual, nos tenemos que dar y admitir que, verdaderamente, comparados con el universo y las fuerzas que lo rigen, somos insignificantes, menos que una mota de polvo flotando en el haz de luz que entra, imparable, por la ventana entre-abierta de la habitación.

Sin embargo, tampoco es así. Que se sepa, no existe ningún otro grupo inteligente que esté capacitado tratar de todas estas cuestiones. Que la especie humana sea consciente de dónde vino y hacia dónde va, en verdad tiene bastante mérito, y más, si consideramos que nuestro origen está a partir de materia inerte evolucionada y compleja que, un día, hace probablemente miles de millones de años, se fraguó en estrellas muy lejanas.

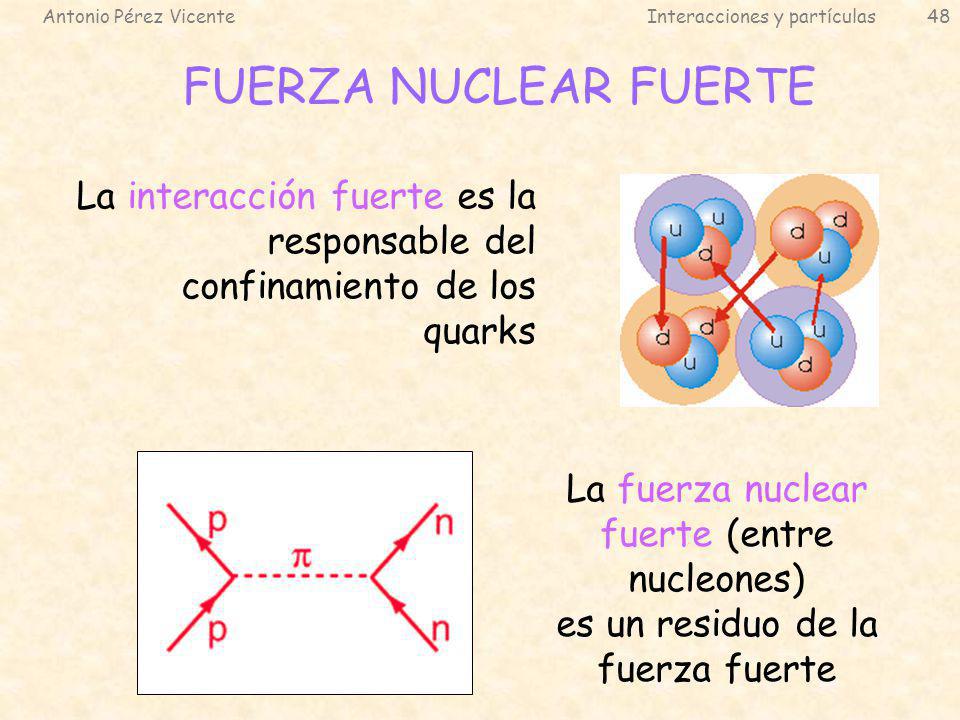

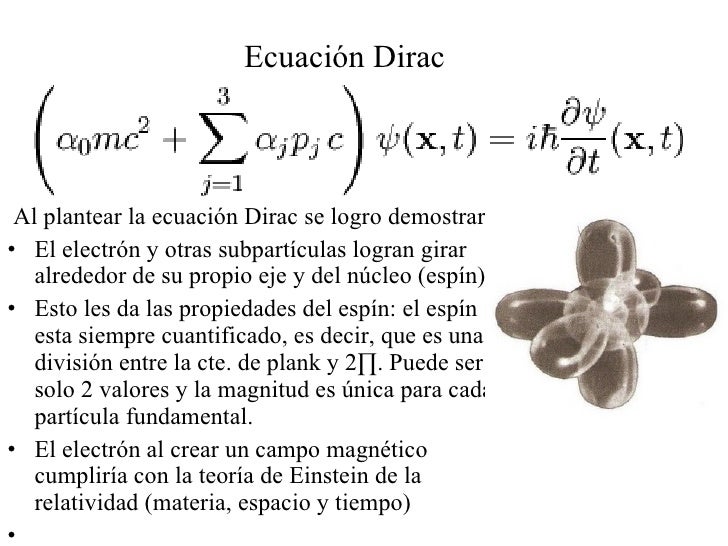

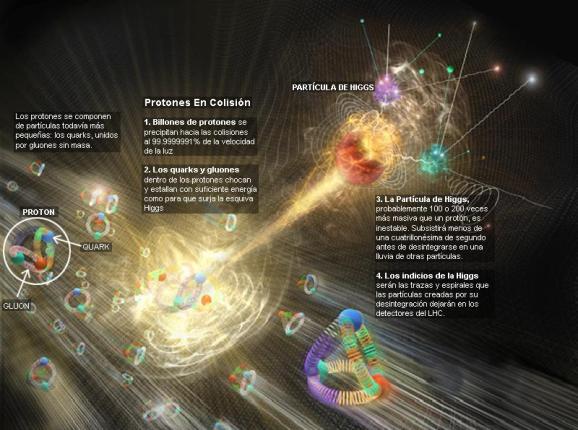

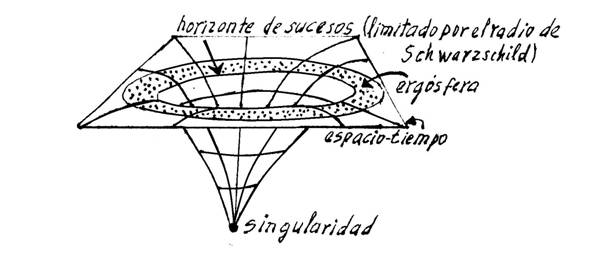

A finales de los 60, un joven físico italiano, Gabriele Veneziano, buscaba un grupo de ecuaciones que explicara la fuerza nuclear fuerte. Este pegamento tan fuerte que mantenía unidos los protones y neutrones del núcleo de cada átomo. Parece ser que por casualidad se encontró con un libro antiguo de matemáticas y en su interior encontró una ecuación de más de 200 años de antigüedad creada por un matemático suizo llamado Leonhard Euler. Veneziano descubrió con asombro que las ecuaciones de Euler, consideradas desde siempre una simple curiosidad matemática, parecían describir la fuerza nuclear fuerte. Después de un año de , se podría decir, que elaboraron la Teoría de Cuerdas de manera fortuita. Tras circular entre compañeros, la ecuación de Euler acabó escrita frente a Leonard Susskind, quien se retiro a su ático para investigar. Creía que aquella antigua fórmula describía matemáticamente la fuerza nuclear fuerte, pero descubrió algo nuevo. Lo primero que descubrió fue que describía una especie de partícula con una estructura interna que vibraba y que mostraba un comportamiento que no se limitaba al de una partícula puntual. Dedujo que se trataba de una cuerda, un hilo elástico, como una goma cortada por la mitad. Esta cuerda se estiraba y contraía además de ondear y coincidía exactamente con la fórmula. Susskind redactó un artículo donde explicaba el descubrimiento de las cuerdas, pero nunca llegó a publicarse.

Muchos buscaron la 5ª dimensión… ¡sin fortuna! Aquí sólo hay tres y el espacio.

Claro que, ya he comentado otras veces que la teoría de cuerdas tiene un origen real en las ecuaciones de Einstein en las que se inspiro Kaluza para añadir la quinta dimensión y perfeccionó Klein (teoría Kaluza-Klein). La teoría de cuerdas surgió a partir de su descubrimiento accidental por Veneziano y , y a partir de ahí, la versión de más éxito es la creada por los físicos de Princeton David Gross, Emil Martinec, Jeffrey Harvey y Ryan Rohm; ellos son conocidos en ese mundillo de la física teórica como “el cuarteto de cuerdas”. Ellos han propuesto la cuerda heterótica (híbrida) y están seguros de que la teoría de cuerdas resuelve el problema de “construir la propia materia a partir de la pura geometría: eso es lo que en cierto sentido hace la teoría de cuerdas, especialmente en su versión de cuerda heterótica, que es inherentemente una teoría de la gravedad en la que las partículas de materia, tanto las otras fuerzas de la naturaleza, emergen del mismo modo que la gravedad emerge de la geometría“.

La Gravedad cuántica está en algunas mentes , ¿Estará en la Naturaleza?

La característica más notable de la teoría de cuerdas ( ya he señalado), es que la teoría de la gravedad de Einstein está contenida automáticamente en ella. De hecho, el gravitón (el cuanto de gravedad) emerge como la vibración más pequeña de la cuerda cerrada, es más, si simplemente abandonamos la teoría de la gravedad de Einstein como una vibración de la cuerda, entonces la teoría se vuelve inconsistente e inútil. , de hecho, es la razón por la que Witten se sintió inicialmente atraído hacia la teoría de cuerdas.

Witten está plenamente convencido de que “todas las ideas realmente grandes en la física, están incluidas en la teoría de cuerdas“.

No entro aquí a describir el modelo de la teoría de cuerdas que está referido a la “cuerda heterótica”, ya que su complejidad y profundidad de detalles podría confundir al lector no iniciado. Sin embargo, parece justo que deje constancia de que consiste en una cuerda cerrada que tiene dos tipos de vibraciones, en el sentido de las agujas del reloj y en el sentido contrario, que son tratadas de diferente.

Las vibraciones en el sentido de las agujas de reloj viven en un espacio de diez dimensiones. Las vibraciones de sentido contrario viven en un espacio de veintiséis dimensiones, de las que dieciséis han sido compactificadas (recordemos que en la teoría pentadimensional Kaluza-Klein, la quinta dimensión se compactificaba curvándose en un circulo). La cuerda heterótica debe su al hecho de que las vibraciones en el sentido de las agujas de reloj y en el sentido contrario viven en dos dimensiones diferentes pero se combinan para producir una sola teoría de supercuerdas. Esta es la razón de que se denomine según la palabra griega heterosis, que significa “vigor híbrido”.

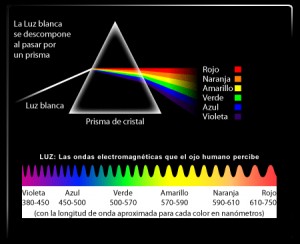

En conclusión, las simetrías que vemos a nuestro alrededor, el arcoíris a las flores y a los cristales, pueden considerarse en última instancia como manifestaciones de fragmentos de la teoría deca-dimensional original. Riemann y Einstein habían confiado en llegar a una comprensión geométrica de por qué las fuerzas pueden determinar el movimiento y la naturaleza de la materia.

La teoría de cuerdas, a partir del descubrimiento Veneziano-Suzuki, estaba evolucionando atrás buscando las huellas de Faraday, Riemann, Maxwell y Einstein poder construir una teoría de campos de cuerdas. De hecho, toda la física de partículas estaba basada en teoría de campos. La única teoría no basada en teoría de campos era la teoría de cuerdas.

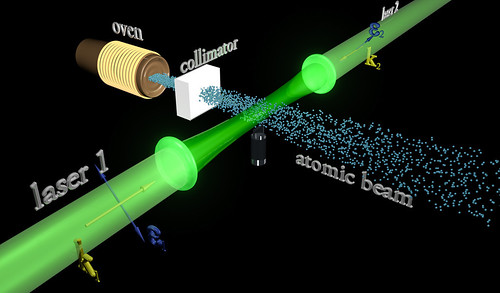

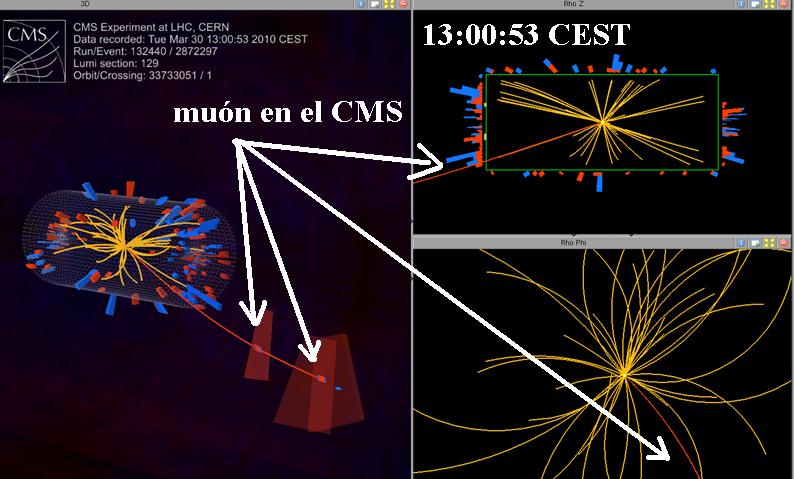

De la teoría de cuerdas combinada con la supersimetría dio lugar a la teoría de supercuerdas. La cuerda es un objeto unidimensional que en nueva teoría se utiliza remplazando la idea de la partícula puntual de la teoría cuántica de campos. La cuerda se utiliza en la teoría de partículas elementales y en cosmología y se representa por una línea o lazo (una cuerda cerrada). Los estados de una partícula pueden ser producidos por ondas estacionarias a lo largo de esta cuerda.

En teoría se trata de unificar a todas las fuerzas fundamentales incorporando simetría y en la que los objetos básicos son objetos unidimensionales que tienen una escala de 10-35 metros y, como distancias muy cortas están asociadas a energías muy altas, este caso la escala de energía requerida es del orden de 1019 GeV, que está muy por encima de la que hoy en día pueda alcanzar cualquier acelerador de partículas.

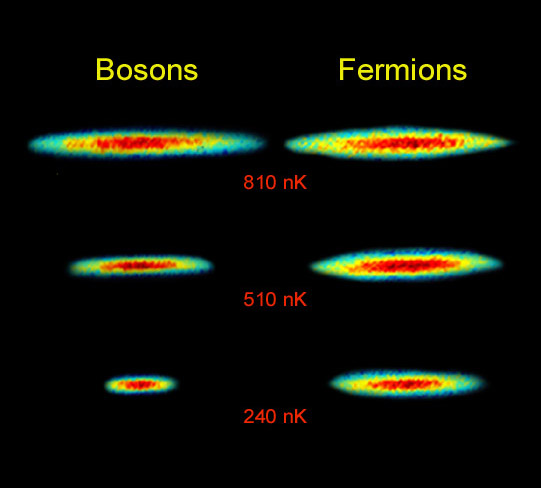

Antes expliqué, las cuerdas asociadas con los bosones sólo son consistentes como teorías cuánticas en un espacio-tiempo de 26 dimensiones; aquella asociadas con los fermiones sólo lo son en un espacio tiempo de 10 dimensiones. Ya se ha explicado que las dimensiones extras, además de las normales que podemos constatar, tres de espacio y una de tiempo, como la teoría de Kaluza-Klein, están enrolladas en una distancia de Planck. De , inalcanzables.

Una de las características más atractivas de la teoría de supercuerdas es que dan lugar a partículas de espín 2, que son identificadas con los gravitones (las partículas que transportan la gravedad y que aún no se han podido localizar). Por tanto, una teoría de supercuerdas automáticamente contiene una teoría cuántica de la interacción gravitacional. Se piensa que las supercuerdas, al contrario que ocurre con otras teorías ( ellas el Modelo Estándar), están libres de infinitos que no pueden ser eliminados por renormalización, que plagan todos los intentos de construir una teoría cuántica de campos que incorpore la gravedad. Hay algunas evidencias de que la teoría de supercuerdas está libre de infinitos, pero se está a la búsqueda de la prueba definitiva.

Aunque no hay evidencia directa de las supercuerdas, algunas características de las supercuerdas son compatibles con los hechos experimentales observados en las partículas elementales, como la posibilidad de que las partículas no respeten paridad, lo que en efecto ocurre en las interacciones débiles.

Extrañas configuraciones a las que, algunos físicos le quieren sacar lo que seguramente no se encuentra en ellas

Estoy convencido de que la teoría de supercuerdas será finalmente corroborada por los hechos y, ello, se necesitará algún tiempo; no se puede aún comprobar ciertos parámetros teóricos que esas complejas matemáticas a las que llaman topología nos dicen que son así.

Habrá que tener siempre a mano las ecuaciones de Einstein, las funciones modulares de Ramanujan y el Supertensor métrico de ese genio matemático que, al igual que Ramanujan, fue un visionario llamado Riemann.

Las historias de estos dos personajes, en cierto modo, son muy parecidas. Tanto Riemann como Ramanujan murieron antes de cumplir los 40 años y, también en ambos casos, en difíciles. Estos personajes desarrollaron una actividad matemática sólo comparable al trabajo de toda la vida de muchos buenos matemáticos.

¿Cómo es posible que, para proteger la simetría conforme original por su destrucción por la teoría cuántica, deben ser milagrosamente satisfechas cierto número de identidades matemáticas, que precisamente son las identidades de la función modular de Ramanujan?

En este trabajo he expresado que las leyes de la naturaleza se simplifican cuando se expresan en dimensiones más altas. Sin embargo, a la luz de la teoría cuántica, debo corregir algo esta afirmación, y para decirlo correctamente debería decir: las leyes de la naturaleza se simplifican cuando se expresan coherentemente en dimensiones más altas. Al añadir la palabra coherentemente hemos señalado un punto crucial, la ligadura nos obliga a utilizar las funciones modulares de Ramanujan, que fijan en diez de dimensiones del espacio-tiempo. Esto a su vez, puede facilitarnos la clave decisiva para explicar el origen del universo.

emilio silvera

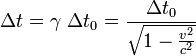

, donde c es la velocidad de la luz. La hipótesis original atribuía contracción a una contracción real que acompaña al movimiento absoluto del cuerpo. La contracción es en cualquier caso despreciable a no ser que v sea del mismo orden o cercana a c.

, donde c es la velocidad de la luz. La hipótesis original atribuía contracción a una contracción real que acompaña al movimiento absoluto del cuerpo. La contracción es en cualquier caso despreciable a no ser que v sea del mismo orden o cercana a c.

es el intervalo temporal entre dos eventos co-locales para un observador en algún sistema de referencia inercial. (por ejemplo el número de tic tacs que ha hecho su reloj)

es el intervalo temporal entre dos eventos co-locales para un observador en algún sistema de referencia inercial. (por ejemplo el número de tic tacs que ha hecho su reloj) es el intervalo temporal entre los dos mismos eventos, tal y como lo mediría otro observador moviéndose inercialmente con velocidad v, respecto al primer observador

es el intervalo temporal entre los dos mismos eventos, tal y como lo mediría otro observador moviéndose inercialmente con velocidad v, respecto al primer observador es la velocidad relativa entre los dos observadores

es la velocidad relativa entre los dos observadores la velocidad de la luz y

la velocidad de la luz y es el también conocido como factor de Lorentz

es el también conocido como factor de Lorentz

![[nebulosa20111%255B3%255D.jpg]](http://lh6.ggpht.com/-Mv21HgaLYuk/TulmVhAmvEI/AAAAAAAASxc/7v5PnR4cAus/s1600/nebulosa20111%25255B3%25255D.jpg)

es la escala de longitud por debajo de la cual el espacio tal como lo conocemos deja de existir y se convierte en espuma cuántica. El

es la escala de longitud por debajo de la cual el espacio tal como lo conocemos deja de existir y se convierte en espuma cuántica. El

Higgs” />

Higgs” />

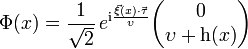

y el escalar h(x) son campos pequeños correspondientes a los cuatro grados de libertad reales del campo . Los tres campos

y el escalar h(x) son campos pequeños correspondientes a los cuatro grados de libertad reales del campo . Los tres campos

La estructura macroscópica del espacio-tiempo parece plana, pero éste debe ser extremadamente turbulento en el nivel de la escala de Planck. Escala en la que parece que entramos en otro mundo… ¡El de la mecánica cuántica! que se aleja de ese mundo cotidinao que conocemos en el que lo macroscópico predomina por todas partes y lo infinitesimal no se deja ver con el ojo desnudo.

La estructura macroscópica del espacio-tiempo parece plana, pero éste debe ser extremadamente turbulento en el nivel de la escala de Planck. Escala en la que parece que entramos en otro mundo… ¡El de la mecánica cuántica! que se aleja de ese mundo cotidinao que conocemos en el que lo macroscópico predomina por todas partes y lo infinitesimal no se deja ver con el ojo desnudo.

![T_{ik} = \frac{c^4}{8\pi G} \left [R_{ik} - \left(\frac{g_{ik} R}{2}\right) + \Lambda g_{ik} \right ]](http://upload.wikimedia.org/math/a/5/f/a5f19c5a15bc3d049fab1564279952a6.png)