![El universo primitivo, en una espectacular imagen en 3D El universo primitivo, en una espectacular imagen en 3D]()

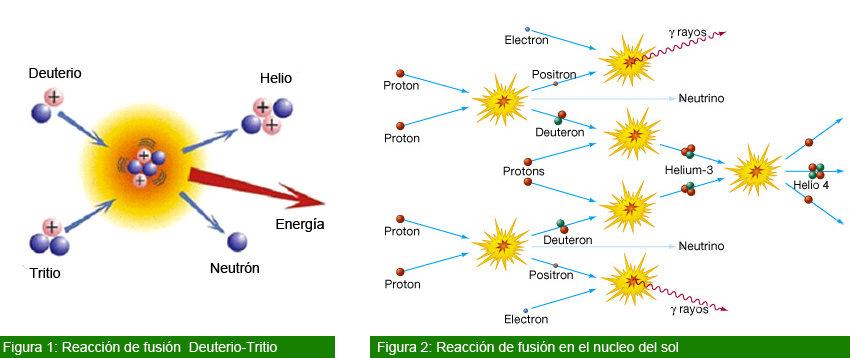

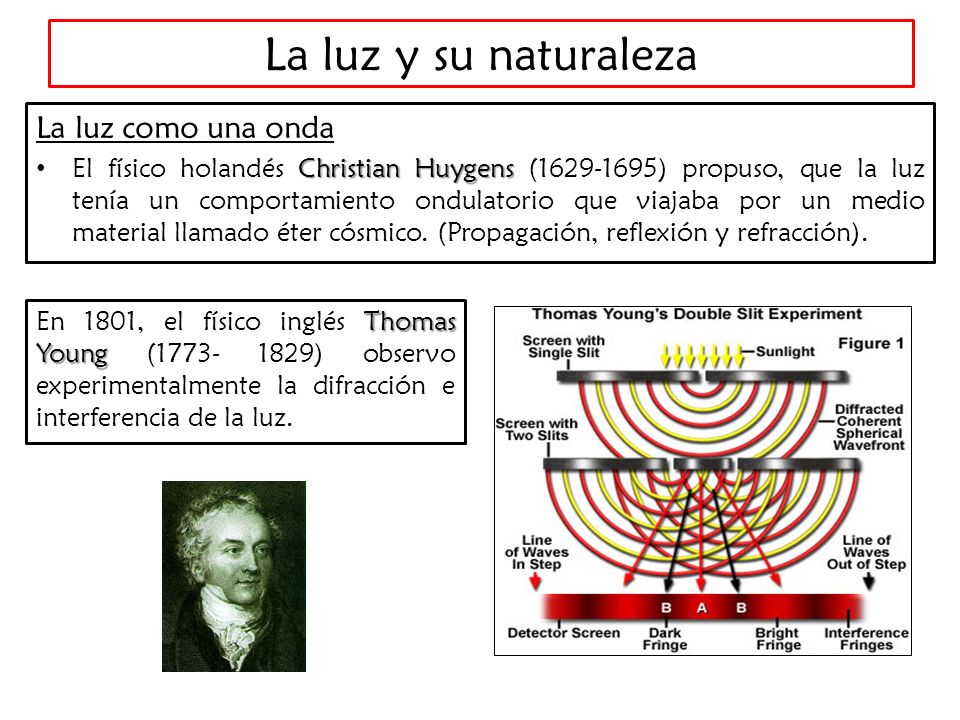

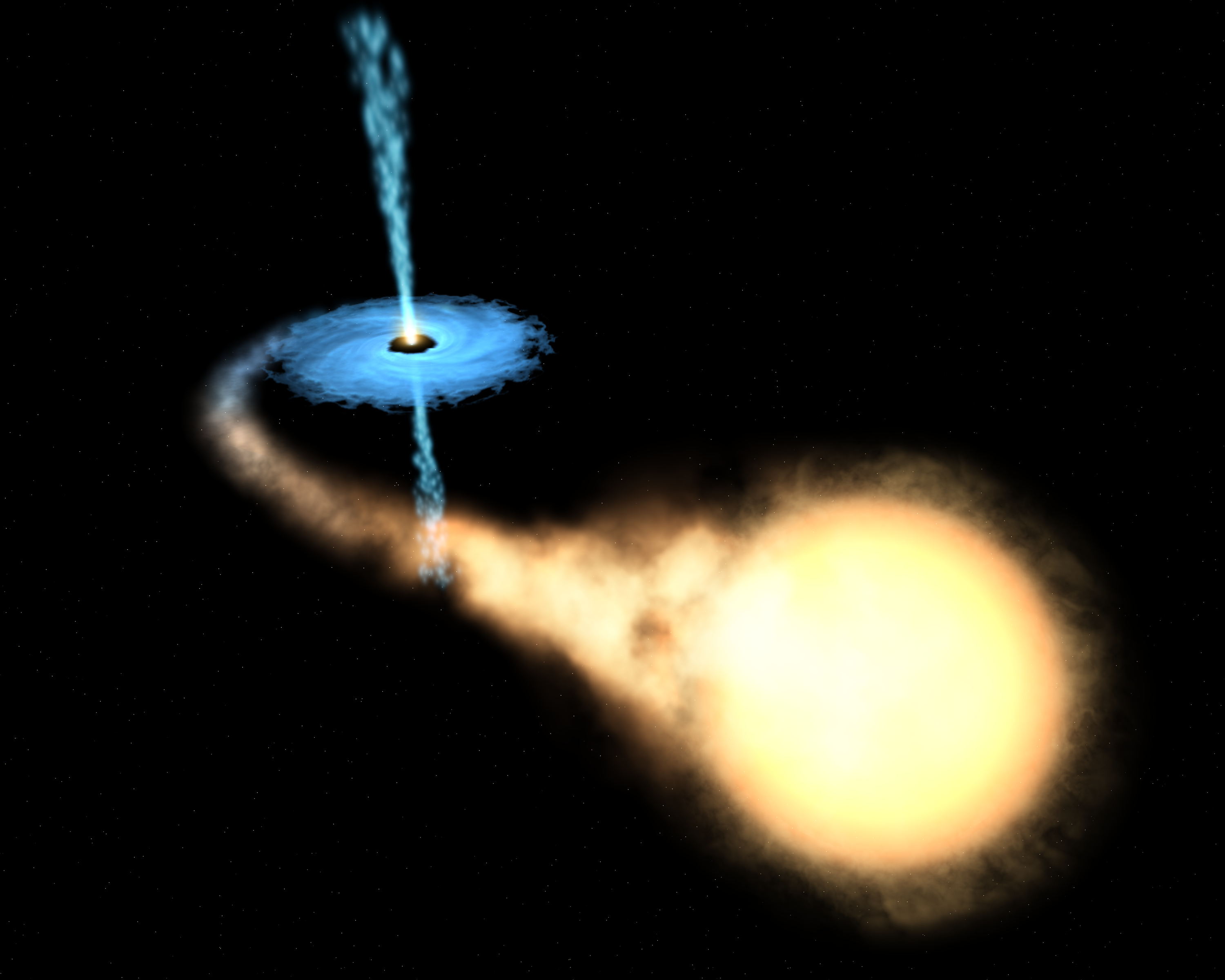

Cuando en nuestro Universo quedaron libres los fotones… ¡Se hizo la Luz!

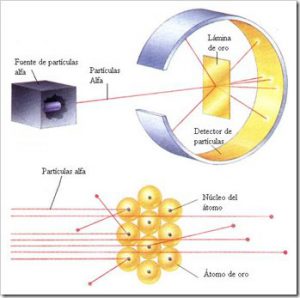

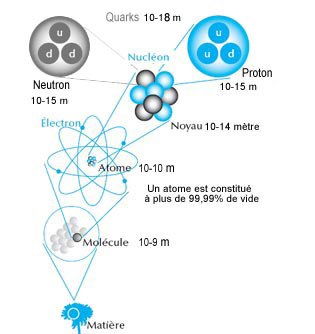

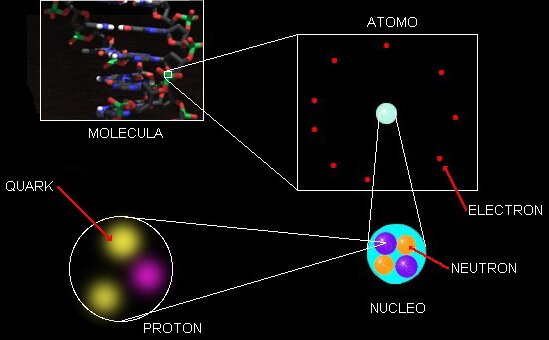

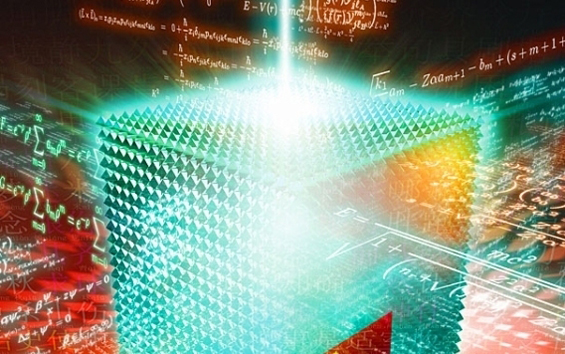

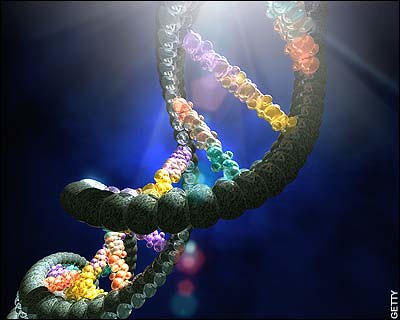

En alguna parte he podido leer que para comprender la realidad en sus niveles más elementales, basta con conocer el comportamiento de dos infinitesimales objetos: el electrón y el fotón. Todo el argumento de la QED [electrodinámica cuántica] gira en torno a un proceso fundamental: la emisión de un único fotón por un único electrón.

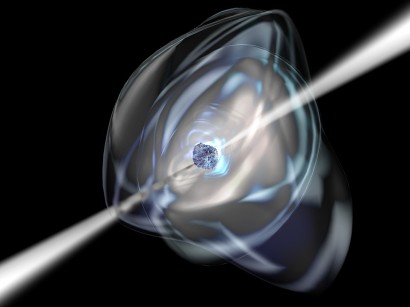

Cuando el movimiento de un electrón es alterado súbitamente, puede responder desprendiendo un fotón. La emisión de un fotón es el suceso básico de la mecánica cuántica:

![Resultado de imagen de Un equipo de cientÃficos lograron filmar por primera vez un electrón en movimiento gracias a una tecnologÃa reciente que genera pulsos cortos e intensos de luz láser.-imagen Gips]()

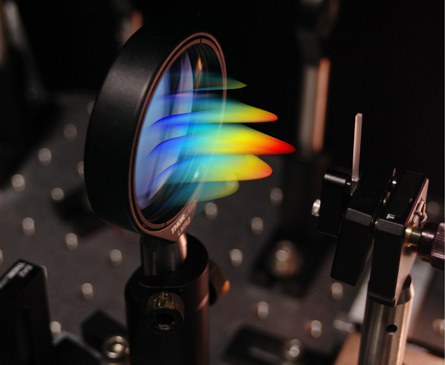

Un equipo de científicos lograron filmar por primera vez un electrón en movimiento gracias a una tecnología reciente que genera pulsos cortos e intensos de luz láser.

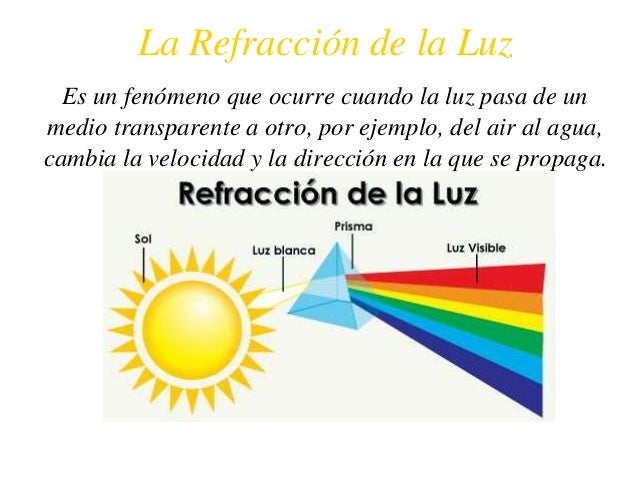

Toda la luz visible que vemos, así como las ondas de radio, la radiación infrarroja y los rayos X, está compuesta de fotones que han sido emitidos por electrones, ya sea en el Sol, el filamento de una bombilla, una antena de radio o un aparato de rayos.

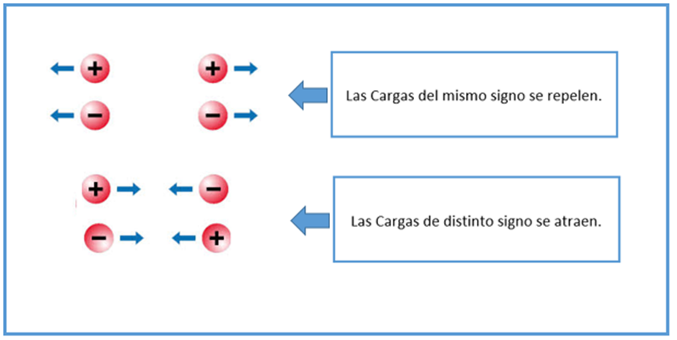

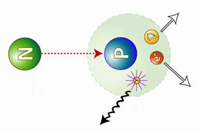

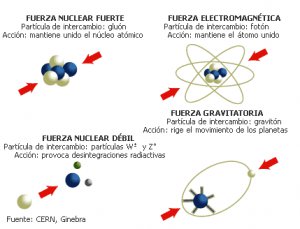

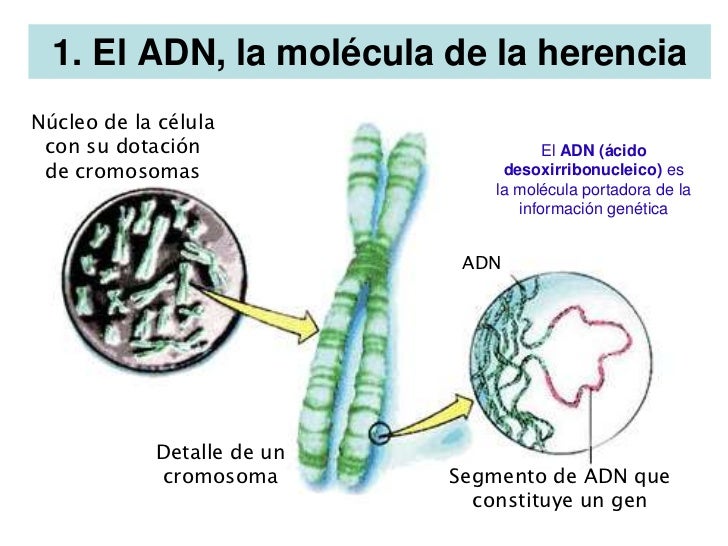

Los electrones no son las únicas partículas que pueden emitir fotones. Cualquier partícula eléctricamente cargada puede hacerlo, incluido el protón. Esto significa que los fotones pueden saltar entre dos protoneso incluso entre un protón y un electrón. Este hecho es de enorme importancia para toda la ciencia y la vida en general. El intercambio continuo de fotones entre el núcleo y los electrones atómicos proporciona la fuerza que mantiene unido al átomo. Sin estos fotones saltarines, el átomo se desharía y toda la materia dejaría de existir.

![Foto]() |

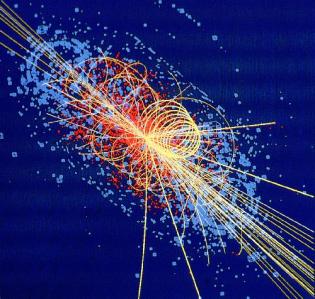

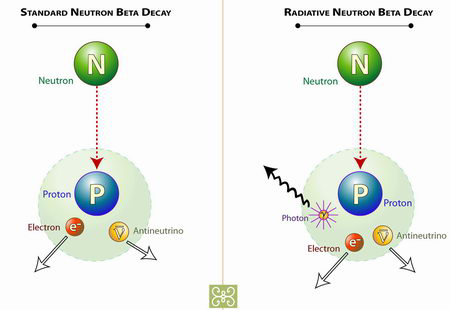

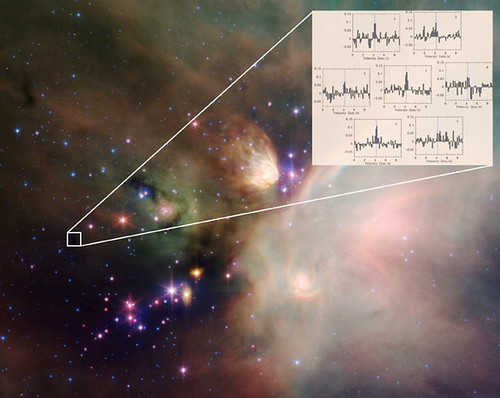

Se ha conseguido observar por primera vez la desintegración radiativa del neutrón.

Dentro de los núcleos de los átomos hay neutrones y protones. En condiciones normales y mientras que están ahí los neutrones son estables. Sin embargo los neutrones libres son inestables, tienen una vida media de unos 10 minutos, y se desintegran produciendo un protón un electrón y un antineutrino. Pero los físicos nucleares teóricos predijeron que una de cada mil veces los neutronesdecaerían en todas esas partículas y además en un fotón.

![Foto]()

Típicamente el neutrón decae en un protón, un antineutrino y un electrón. Muy raramente lo hace radiativamente emitiendo además un fotón. Diagrama: Zina Deretsky, National Science Foundation.

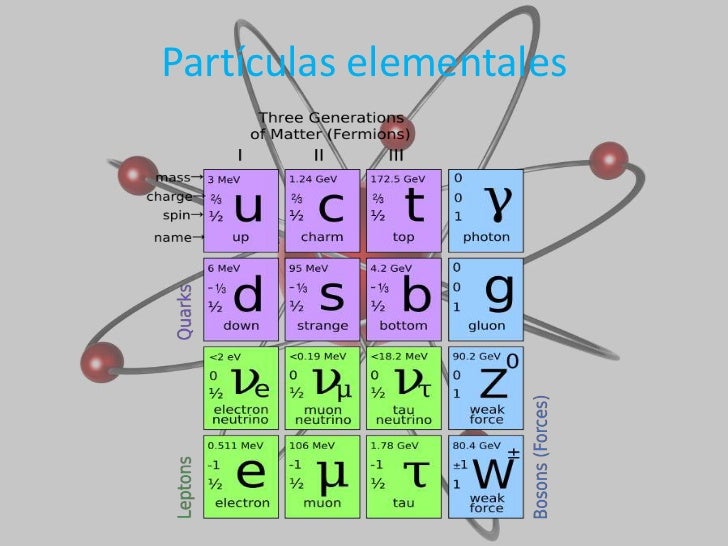

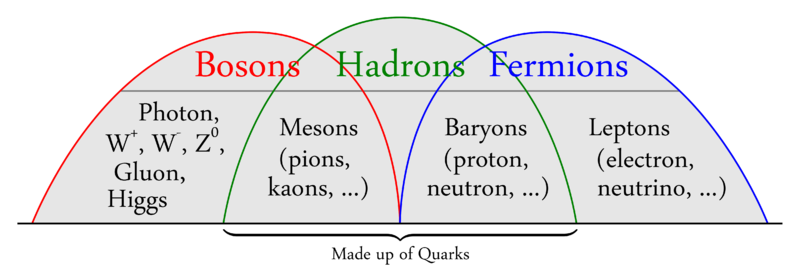

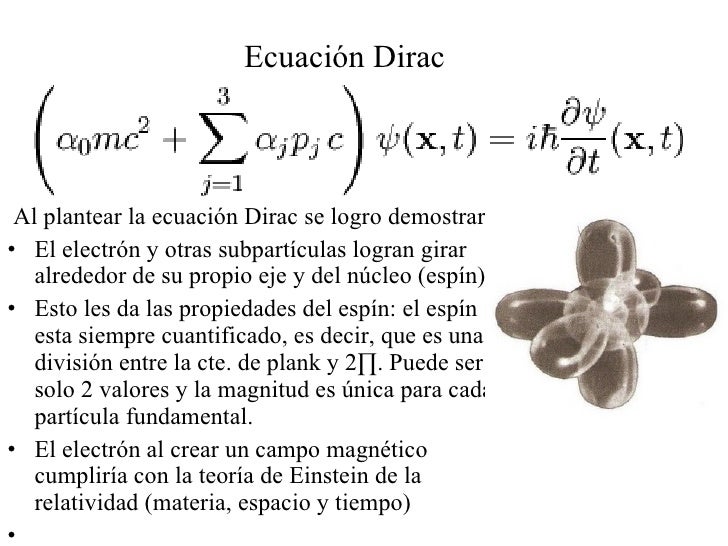

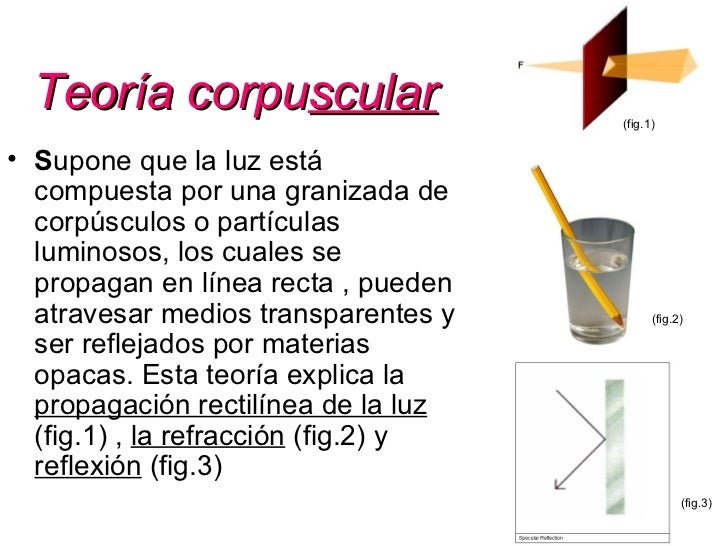

Mientras que un electrón pertenece al grupo de partículas llamadas fermiones, los fotones pertenecen a la familia de los bosones. Intentemos comprender esta película que es la intermediaria de todas las formas de radiación electromagnética.

…protagonizada por bosones…

Los fermiones hacen posible la materia “al estilo tradicional”, mientras que los bosones son elementos muy raros desde la forma de pensar a que estamos acostumbrados el común de los mortales. Para no complicarnos, la tabla periódica de elementos existe porque los fermiones no pueden “ser iguales”: no pueden solaparse uno sobre otro y se repelen si los obligamos. Es lo que damos por hecho cuando hablamos de materia, que cada pedazo de ésta ocupa su lugar y tiene sus propias cualidades.

![]()

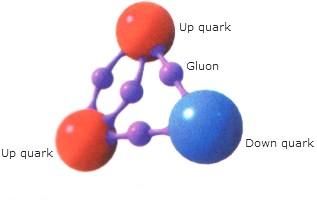

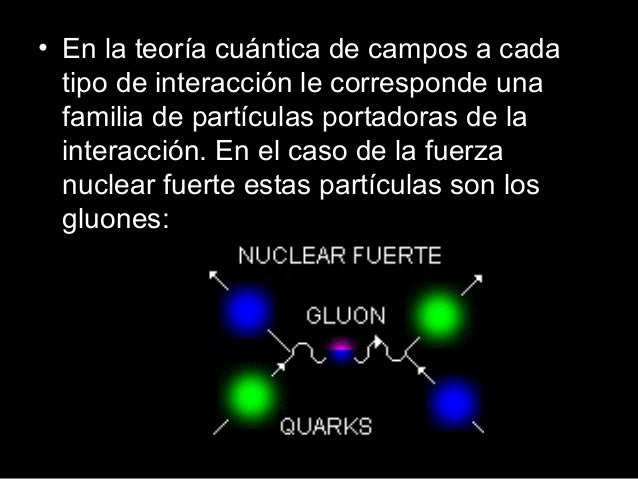

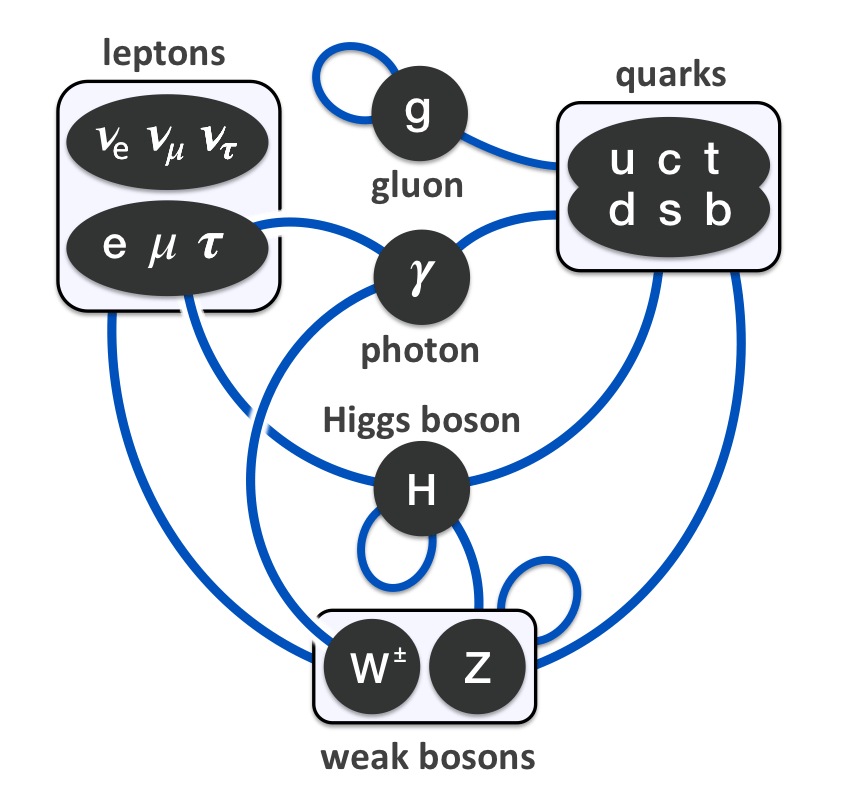

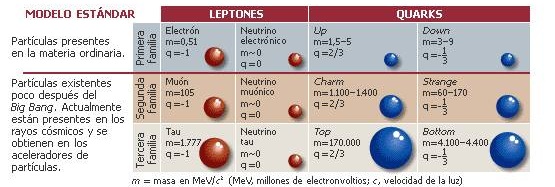

Toda la materia que conocemos, la que forma las estrellas y los mundos y las galaxias, esa que llamamos luminosa o bariónica, la que emite radiación, está hecha de Leptones y Quarks, partículas que son Fermiones, y, esas otras partículas intermediarias de las cuatro fuerzas fundamentales, son las que pertenecen a la familia de los Bosones, tales como el Fotón, las W+, W- y Zº, los Gluones y el Gravitón.

![]()

Los bosones carecen de este sentido de la individualidad que tienen los Fermiones, digamos que poseen “alma grupal” y, en su estado más puro, todos forman una misma “superpartícula”.

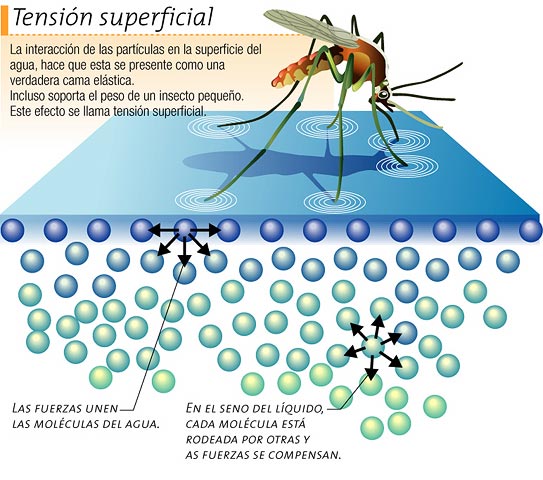

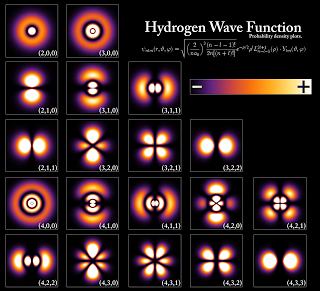

Para entenderlo mejor, conviene recordar que las partículas no son bolitas como nos siguen enseñando en la escuela, sino que más allá de esta imagen existen como ondas o, al menos, sus funciones se equiparan al comportamiento de una onda.

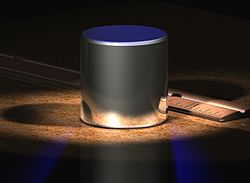

En la década de 1920, Albert Einstein y el hindú Satyendra Nath Bose pronosticaron un quinto estado de la materia: el condensado de Bose-Einstein (BEC), el cual fue conseguido en laboratorio en 1995, algo que le valió el premio Nobel de 2001 a los científicos que lo lograron.

![]()

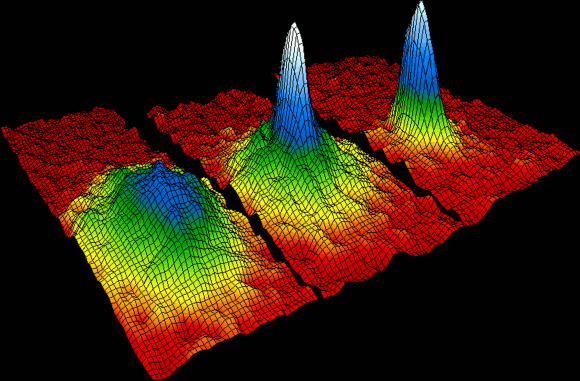

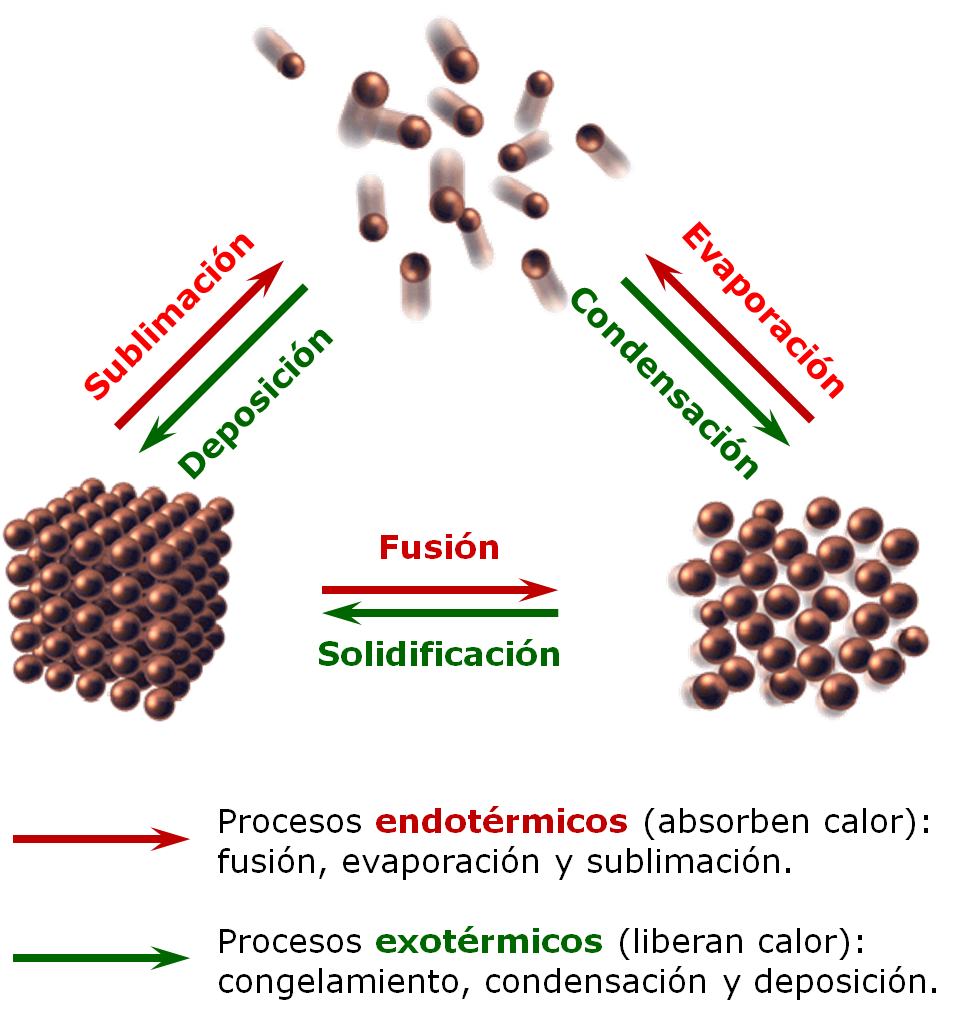

Un condensado de Bose-Einstein es un estado de la materia que se da en ciertos materiales a muy baja temperatura. En este estado de la materia, todos los átomos que lo constituyen se encuentran en el nivel de mínima energía, denominado estado fundamental. Descubierto en 1924 para los fotones por el indio Bose y por Einstein, no fue obtenido en laboratorio hasta 1995 por Cornell y Wieman al enfriar átomos a pocos nanokelvin por encima del cero absoluto. El condensado de Bose-Einstein fue la “molécula del año” según la revista Science en 1995 ya que se trata de un sistema cuántico macroscópico similar a una molécula pero con millones de átomos. Un átomo en un gas se mueve a una velocidad de unos unos 1000 km/h (unos 300 m/s) pero un condensado de Bose-Einstein se mueve a sólo 1 cm/s. Un condensado de Bose-Einstein es respecto a la materia ordinaria, como la luz de un láser es respecto a la de una bombilla. Gracias a ello se puede fabricar un láser de átomos, que en lugar de producir un haz de luz como un láseróptico, produce un haz (coherente) de átomos. En 1997 Ketterle fabricó el primer láser de átomos que producía un haz de átomos de sodio.

Cuando ciertas formas de materia [bosones] se enfrían hasta casi el cero absoluto, sus átomos se ponen en el estado de energía más baja, de modo que todos sus átomos vibran al unísono y se hacen coherentes. Las funciones de onda de todos los átomos se solapan, de manera que, en cierto sentido, un BEC [condensado de Bose-Einstein] es como un “superátomo” gigante en donde todos los átomos individuales vibran al unísono.

Al enfriar los átomos, su velocidad disminuye hasta que las longitudes de onda de cada uno de ellos se vuelven casi planas, superponiéndose unas a otras para formar una única onda que los describe a todos.

![]()

Así que un BEC se forma cuando los átomos en un gas sufren la transición de comportarse como “bolas de billar” al estilo de la física clásica, a comportarse como una onda gigante de materia al estilo de mecánica cuántica:

Si creamos dos BECs y los colocamos juntos, no se mezclan como gases ordinarios ni rebotan como lo harían dos sólidos. Donde los dos BECs se superponen, ellos “interfieren” como las ondas: delgadas capas paralelas de materia son separadas por capas delgadas de espacio vacío. El patrón se forma porque las dos ondas se suman donde sus crestas coinciden, y se cancelan donde una cresta se encuentra con un valle — a lo cual llamamos interferencia “constructiva” y “destructiva” respectivamente. El efecto es similar al de dos ondas que se superponen cuando dos piedras son lanzadas a un lago.

![]()

…ambientada en el vacío…

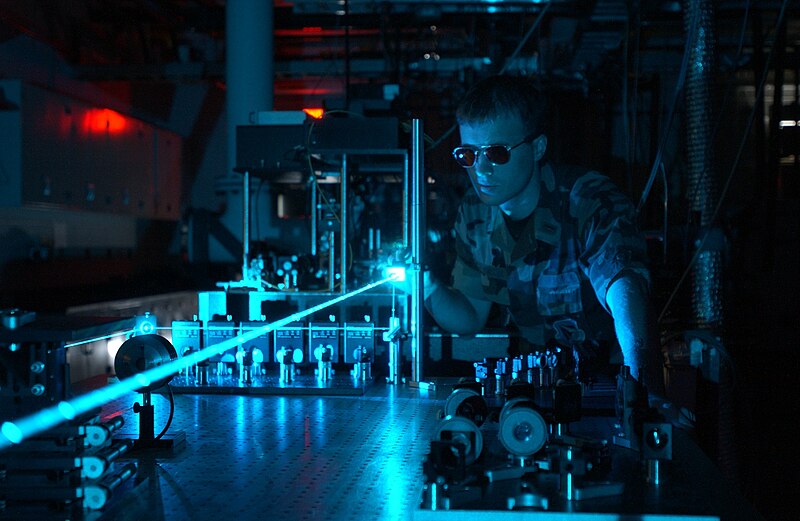

Y ahora, retrocedamos un poco más en este asunto del misterio que nos ocupa. Gracias a la tecnología láser, la física ha podido comprobar el extremo poder de la luz. Los láseres pueden hacer que las partículas virtuales se vuelvan reales. Pero, primero, aclaremos conceptos…

Las “Partículas virtuales”son partículas fundamentales que están constantemente surgiendo aparentemente de la nada y permanecen en el espacio-tiempo la friolera de una milésima de trillonésima de segundo –una cantidad que se forma poniendo una veintena de ceros a la derecha de la coma—. A pesar de denominarse “virtuales”, sus efectos son muy reales: la constante agitación de este burbujeo cuántico de partículas hace que el vacío tenga energía. Y esto es algo que afecta a la realidad, pues en ésta las fuerzas de atracción y repulsión dependen de la masa, y la masa no es sino energía expresada en unidades diferentes: E=mc².

![Resultado de imagen de PartÃculas virtuales que surgen de la NADA. Claro que, en la NADA no hayâ¦Â¡Nada! -Imagen Gips]()

Partículas virtuales que surgen de la NADA. Claro que, en la NADA no debe haber…¡Nada! Pero hay

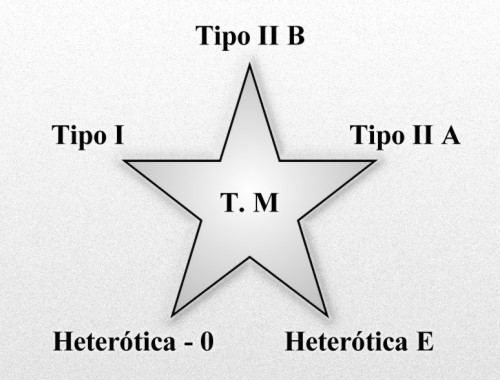

En el uso corriente la palabra vacío significa espacio vacío, espacio del que se ha extraído todo el aire, vapor de agua u otro material. Eso es también lo que significa para un físico experimental que trabaja con tubos de vacío y bombas de vacío. Pero para un físico teórico, el término vacío tiene muchas más connotaciones. Significa una especie de fondo en el que tiene lugar el resto de la física. El vacío representa un potencial para todas las cosas que pueden suceder en ese fondo. Significa una lista de todas las partículas elementales tanto como de las constantes de la Naturaleza que se pondrían de manifiesto mediante experimentos en dicho vacío. En resumen, significa un ambiente en el que las leyes de la física toman una forma particular. Un vacío diferente significa leyes de la física diferentes; cada punto en el paisaje representa un conjunto de leyes que son, con toda probabilidad, muy diferentes de las nuestras pero que son, en cualquier caso, posibilidades consistentes. El modelo estándar es meramente un punto en el paisaje de posibilidades.

![]()

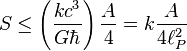

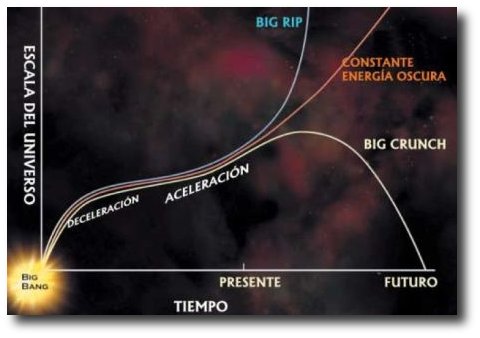

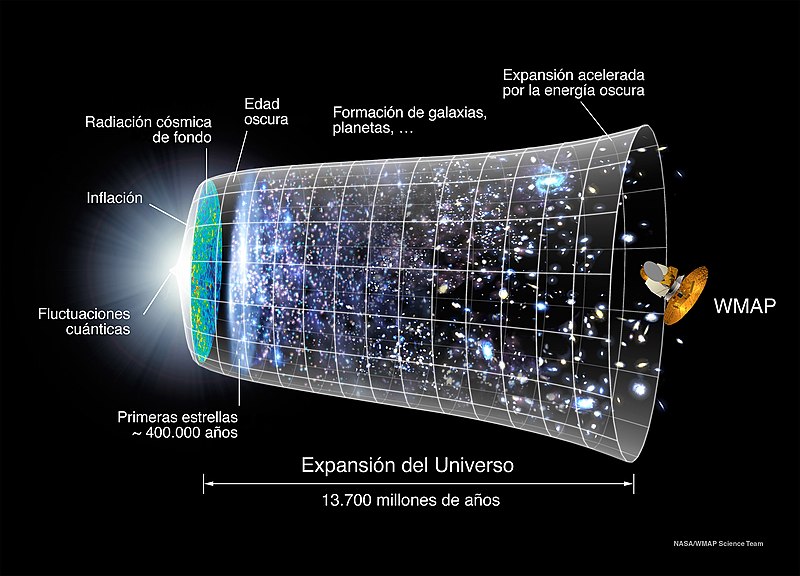

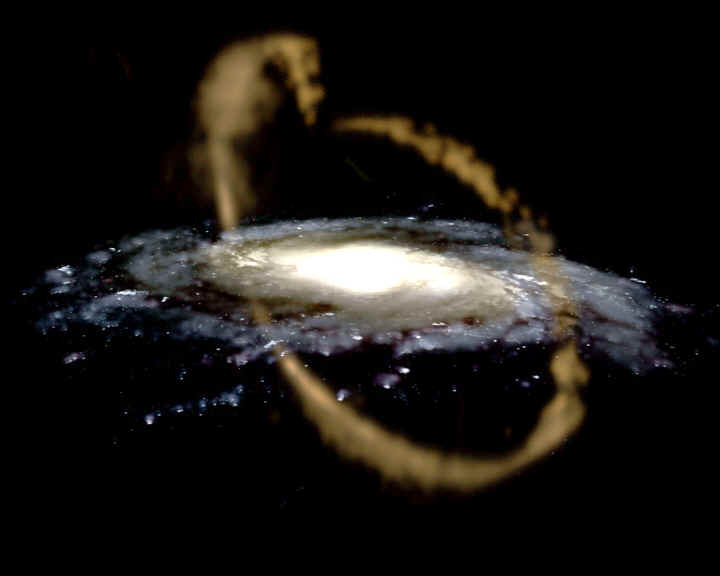

La energía del vacío es, por tanto, la suma total de las energías de todas las partículas posibles. Es la llamada “energía oscura” que hace que el universo se expanda, haciendo frente a la atracción de la gravedad, y que proporciona alrededor del 80% de la materia-energía al universo –un 26% es “materia oscura”, y sólo un 4% es la materia conocida hasta el momento—.

Pero, ¿cómo una partícula virtual se convierte en real? Es decir, ¿cómo queda “atrapada” en el espacio-tiempo de forma más estable?

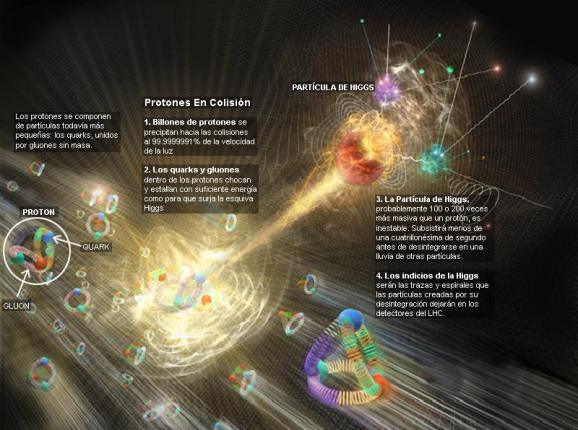

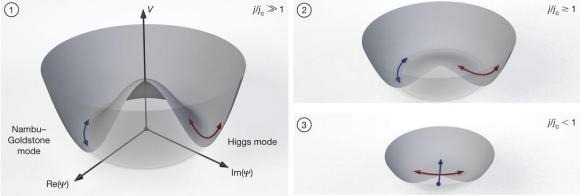

¡Los fotones de Yang-Mills adquieren su masa y el principio gauge se sigue cumpliendo! Al principio esta visión no mereció la atención que merecía. Por una parte, la gente pensó que el modelo era feo. El principio gauge estaba ahí, pero ya no era el tema central. El “Campo de Higgs” había sido puesto ahí “a propósito” y la “partícula de Higgs”, en sí misma, no era una “partícula gauge”

La Teoría de la Sipersimetría establece que, por cada partícula de materia, nace una gemela de antimateria. La antimateria es igual que la materia, pero con carga opuesta. Por ejemplo, el electrón tiene carga negativa, y su partícula de antimateria, el positrón, positiva. Materia y antimateria se aniquilan mutuamente pero, por algún motivo aún no aclarado, la simetría se rompió en algún momento, surgiendo más materia que antimateria, de ahí que nuestro universo, materia, pueda existir.

Pero hay algo más en todo esto. Y para ello, la luz es la clave.

![]()

Controlar los estados cuánticos macroscópicos de osciladores micromecánicos no es fácil; hacerlo con luz (fotones) requiere el acoplamiento coherente entre …

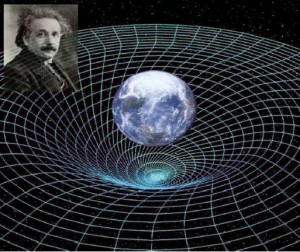

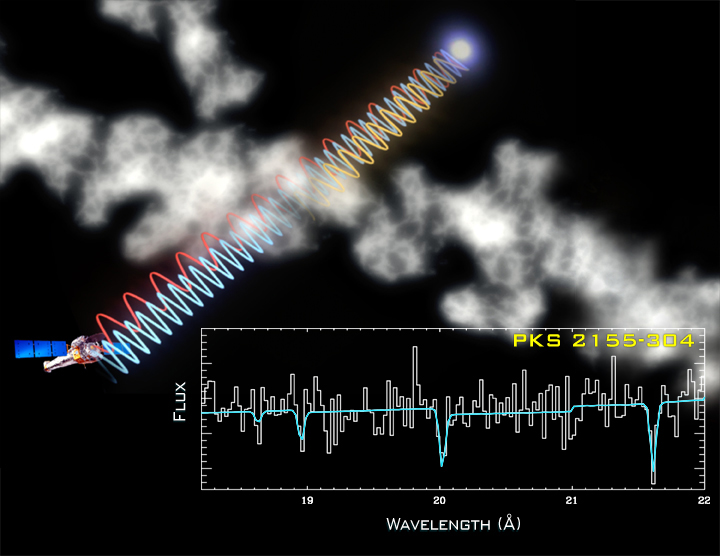

Una de los modelos teóricos elaborados para superar la visión de la gravedad de Einstein indica que los fotones de los rayos gamma de alta energía viajarían algo más despacio que los de baja energía, lo que viola el axioma del sabio alemán acerca de que toda radiación electromagnética, desde las ondas radio hasta los rayos gamma, viajan en el vacío a la misma velocidad (la de la luz). Sin embargo, no ha sido verificado mediante experimento, con lo cual, Einstein sigue teniendo razón.

… protagonizada por la “luz” como la propia …

Ya en los años 30, los físicos predijeron que un campo eléctrico muy fuerte, que no es sino un espacio alterado por la actividad de un montón de fotones coordinados, podría impulsar a las partículas virtuales con carga opuesta en diferentes direcciones, impidiendo que la materia y la antimateria se aniquilen.

![]()

Según el efecto de creación de pares, un fotón con energía suficiente, lo que equivale a tener el doble de la energía que posee un electrón en reposo, da lugar a una pareja de electrón y positrón.

Aunque esto ya se consiguió en los años 90 a pequeña escala, gracias al desarrollo de la tecnología láserlos científicos creen que estarán cerca de conseguir crear materia “en serie” mediante este proceso en unos pocos años.

![]()

Sabemos desde 1932, que un fotón gama con suficiente energía, puede formar un par de antipartículas, al interactuar con un átomo masivo, como el plomo. Pero el problema no termina, sino que, el electrónformado por un rayo gama, no interactúa con este tipo de fotón (gama), sino uno de luz visible,

Por otra parte, una vez que existen las partículas, los fotones interactúan sin cesar con ellas, siendo absorbidos y emitidos por las mismas de manera ininterrumpida.

Y de ello nace el movimiento gracias al cual todo existe en el espacio-tiempo. Sin movimiento, nuestra realidad desaparecería.

La carencia de masa de un fotón está ligada a su movimiento. Para que un cuerpo alcance la velocidad de la luz, su masa ha de ser cero. Y, como Einstein explicó en su día, la luz se mueve siempre a la velocidad de la luz. Si pretendemos que un fotón se pare, en lugar de ralentizarse observaremos que desaparece. Y, como se ha dicho al principio, si estos “fotones saltarines” desaparecieran, toda la materia dejaría de existir.

![Resultado de imagen de los fotones saltarines que hacen girar la rueda de la existncia]()

Su esencia es el movimiento y su misión, según parece, hacer girar la rueda de la existencia.

Ello es así debido al impacto de los fotones sobre las partículas elementales. La energía transmitida por un fotón es inversamente proporcional a su longitud de onda. Cuanto menos longitud de onda, más energía. Así, un fotón de luz visible tiene la energía suficiente para hacer reaccionar a un bastón de la retina. Si nos movemos en el espectro electromagnético, los fotones con longitud de onda ultravioleta pueden expulsar a los electrones de los átomos. Más allá, los rayos gamma pueden romper protones y neutrones…

![]()

Y ahora, vayamos al meollo de la cuestión e indaguemos en la cita con que se iniciaba este artículo: ¿qué hace que los electrones absorban y emitan fotones? Esto, en otros términos, vendría a ser lo mismo que preguntarnos: ¿por qué existe nuestro universo?

…con un misterio: el 137…

¿Qué determina el momento exacto en que un electrón emite un fotón? La física cuántica dice que nada lo hace, pues la Naturaleza es caprichosa en sus niveles más elementales. Aunque no es caótica en extremo, sólo probabilística.

A diferencia de la física newtoniana, la mecánica cuántica nunca predice el futuro en función del pasado. En su lugar, ofrece reglas muy precisas para computar la probabilidad de varios resultados alternativos de un experimento.

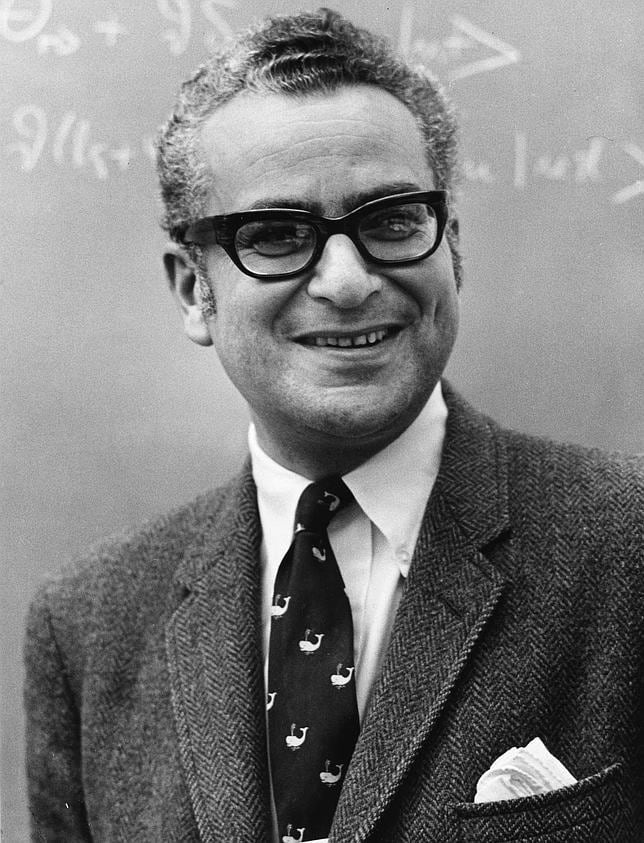

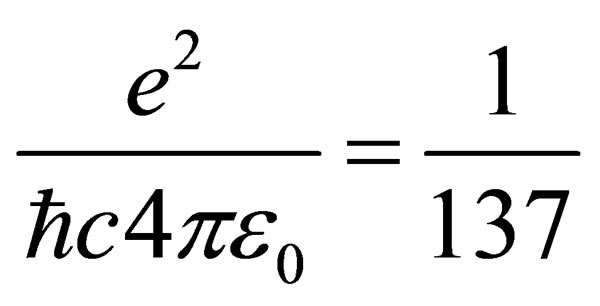

Y la probabilidad de que un electrón emita o absorba un fotón es la constante de estructura fina. El valor de esa constante es 1/137.

![]()

En otras palabras, sólo un afortunado electrón de cada 137 emite un fotón. Este es el significado de alfa: es la probabilidad de que un electrón, cuando se mueve a lo largo de su trayectoria, emita caprichosamente un fotón.

El inverso de la constante de estructura fina es 137. Desde su descubrimiento, éste número ha traído de cabeza a los grandes científicos.

![\alpha^{-1} = 137.035 999 710 (96)]()

No puedo recordar si fue Richard Feynman o León Lederman, quien sugirió que todos los físicos pusiesen un cartel en sus despachos o en sus casas que les recordara cuánto es lo que no sabemos. En el cartel no pondría nada más que esto: 137. Ciento treinta y siete es el inverso de algo que lleva el nombre de constante de estructura fina. Este número guarda relación con la probabilidad de que un electrónemita o absorba un fotón. La constante de estructura fina responde también al nombre de alfa, y sale de dividir el cuadrado de la carga del electrón por el producto de la velocidad de la luz y la constante de Planck. Tanta palabra no significa otra cosa sino que ese solo número, 137, encierra los meollos del electromagnetismo (el electrón), la relatividad (la velocidad de la luz) y la teoría cuántica (la constante de Planck). Menos perturbador sería que la relación entre todos estos importantes conceptos hubiera resultado ser un uno o un tres o quizás un múltiplo de pi. Pero ¿137?

![]()

… es un número que determina la fuerza de una interacción) y equivale a 1/137,03599911.

![]()

“Lo más notable de este notable número es su adimensionalidad. La velocidad de la luz es de unos 300.000 kilómetros por segundo. Abraham Lincoln medía 1,98 metros. La mayoría de los números vienen con dimensiones. Pero resulta que cuando uno combina las magnitudes que componen alfa, ¡se borran todas las unidades! El 137 está solo: se exhibe desnudo a donde va. Esto quiere decir que a los científicos de Marte, o a los del decimocuarto planeta de la estrella Sirio, aunque usen Dios sabe qué unidades para la carga y la velocidad y qué versión de la constante de Planck, también les saldrá 137. Es un número puro.”

(Leon Ledderman, La partícula divina)

Uno de los padres de la mecánica cuántica, Wolfgang Pauli, se obsesionó tanto con este número que dijo que, de poder hacerle una pregunta a Dios, sería esta: “¿Por qué 137?”

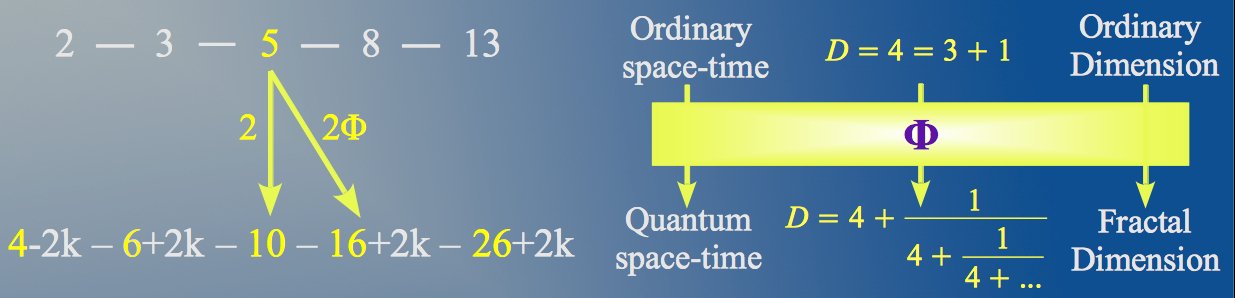

Gracias a su gran amistad con Carl G. Jung, Pauli conoció el mundo “alternativo” de los estudios sobre la psique y accedió a la tradición esotérica que ha acompañado al hombre desde el principio de los tiempos. Es así como supo que 137 se aproxima al valor correspondiente al ángulo áureo. Esto es, la versión circular del número áureo o φ (phi).

![]()

Sin fotones… ¡El Universo sería inestable, sería otro universo diferente!

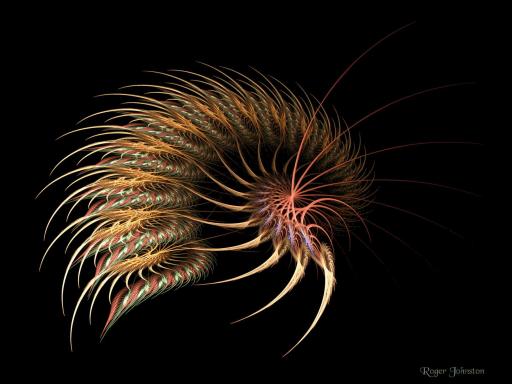

En realidad, el ángulo de oro es, más o menos, 137,5º, y está presente en todo proceso natural donde se dé una combinación de espirales. Así, por ejemplo, las hojas de una planta surgen a lo largo del tallo cada 137,5º, pues así se logra la mayor eficiencia de espacio y de captación de la luz solar, ya que únicamente con éste ángulo es posible evitar que ninguna hoja obstaculice a las demás en la toma de luz sin que existan espacios muertos o vacíos.

Esta semejanza entre los valores de la constante de estructura fina y el ángulo áureo llevó a la doctora Raji Heyrovska a buscar el ángulo áureo en el universo atómico (véase versión en español de su estudio).

Que esto sea así no debería extrañarnos, pues si el número áureo es una constante en toda la Naturaleza, su versión angular es la apropiada para estar presente en el universo cuántico, donde, recordemos, los elementos básicos de la realidad se reducen a funciones de onda.

![]()

…y un final místico.

Los fotones no tienen masa ni carga eléctrica. Sin embargo, pueden “extraer” del vacío partículas con masa y carga, tanto negativa como positiva.

Más allá de la matería y la energía, del tiempo y del espacio, el concepto de función de onda nos introduce en una realidad abstracta de donde surge todo.Y si, como hemos dicho, a menor longitud de onda mayor energía, también es posible afirmar que, en eso que David Bohm llamaba “orden implicado”, cuanto menor es la longitud de una onda cuántica, mayor es la presencia de masa en el espacio-tiempo.

Para la física, las matemáticas se han mostrado como la realidad que subyace a la materia. Todo se puede reducir a números, entidades que forman y organizan el espacio-tiempo. En este nivel de realidad, ni la materia ni la energía existen como tales, sino que demuestran ser el resultado de la interacción de entidades abstractas.

![]()

En esta pasión por los números, no podemos evitar recordar la versión cabalística de la filosofía perenne. Para la Kabbalah, lo divino responde a la “Nada”, ya que lo trascendente no puede ser aprehendido desde nuestra posición en el mundo finito.

En el momento de la Creación, la luz infinita se habría divido, quedando encerrada en conductos que, al romperse, producen la materia y, en definitiva, la fractura de la unidad primordial de la luz.

Esta materia o qelippot, en el sentido de “conchas” o caparazones que “encierran” la luz y rompen la armonía unitaria de la luz, es el origen del mundo, de su finitud y causa del mal en la realidad no-divina. El mundo creado es así una fractura de la harmonía de la luz que crea la diferenciación y la tensión entre unas cosas y otras: este es el origen del mal, de la falta de armonía que debe recuperarse en el curso de la historia.

La Kabbalah enseña, según esto, el camino para desarrollar la Vasija interior donde recibir la Luz, la cual, según va llenando dicha vasija, nos acerca a la unidad del Espíritu. Es así que la Luz, al tiempo que “absorbida” por el alma, puede ser “proyectada” en el mundo mediante los actos del hombre trascendido.

Que la luz ha sido usada por todos los movimientos espirituales para referirse a lo divino es algo que a nadie se le escapa. La imagen que la Kabbalah ofrece aquí no es muy diferente de la que podríamos encontrar en textos rosacruces o en escritos orientales, entre otros.

Sin embargo, si esta vez he preferido usar el hermetismo hebreo es, como he mencionado, por su pasión hacia los números. Y es que el valor numérico para el término hebreo de “kabbalah” (cuya traducción es “recepción”) es…

como muchos ya sabrán…

Efectivamente…

137.

![]()

Ciencia y tradición hermética unidas por un número que, en ambas, define la interacción entre luz y materia.

Cosas…

Luz que, también en ambos casos, procede de la Nada.

Decía Jung que el espacio y el tiempo son conceptos hipostasiados, fenómenos que hemos decidido convertir en reales. La física teórica y la consolidación de la mecánica cuántica han dejado claro, a lo largo de las últimas décadas, que toda esta realidad por la que combatimos, matamos, morimos, odiamos, repudiamos, humillamos, codiciamos, envidiamos o ansiamos consiste, simplemente, en Nada.

Nada…

![]()

Una ilusión de la psique por la que renunciamos a indagar en el misterio de la Vida y nuestra experiencia momentánea en el espacio-tiempo se convierte en un vagar ausentes, asumiendo que todo es un sinsentido.

A veces, en momentos de bajón, me pregunto si no será por eso por lo que, casi cien años después, nos siguen diciendo que la física cuántica es muy complicada para que lleguemos a entenderla…

Lo más triste, sin embargo, es que lo aceptamos…

Todo esto lo he leido o aprendido de gente que son más sabias que yo, ideas que tienen sus fuentes en trabajos realizados con la misión y el propósito de desvelar los secretos de la Naturaleza para saber, como es el Universo.

Lo conseguiremos alguna ve?

emilio silvera

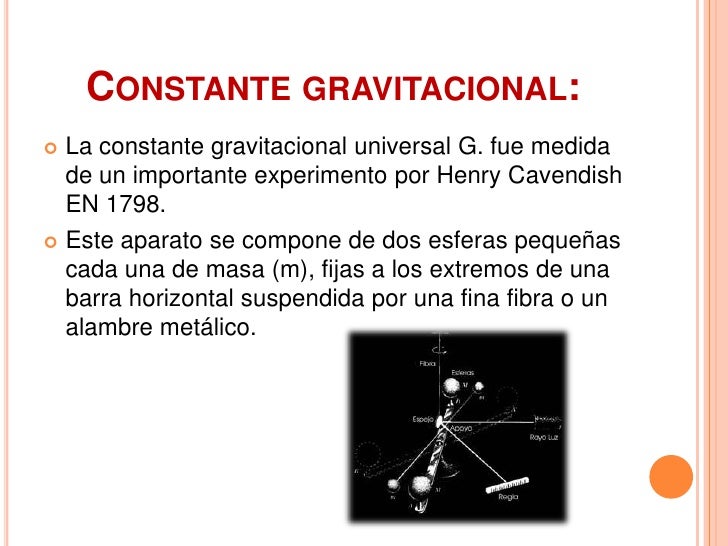

, es la constante de Boltzmann.

, es la constante de Boltzmann.  , es la velocidad de la luz.

, es la velocidad de la luz.  , es la constante gravitacional universal.

, es la constante gravitacional universal. , es la

, es la  , es la

, es la

![[foto de la noticia] [foto de la noticia]](http://estaticos01.elmundo.es/elmundo/imagenes/2009/03/31/1238489169_extras_ladillos_3_2.jpg)

![[stephan_quinteto_2009_hubble.jpg]](http://3.bp.blogspot.com/_xBXZbW6ivIs/SqpvjP3SBJI/AAAAAAAAEqc/fh3ULAFurbs/s1600/stephan_quinteto_2009_hubble.jpg)

, es la constante que frecuentemente se define como el cuanto elemental de acción.Planck la denominaría precisamente «cuanto de acción»

, es la constante que frecuentemente se define como el cuanto elemental de acción.Planck la denominaría precisamente «cuanto de acción» de un

de un  de su onda electromagnética asociada. Esta relación entre la energía y la frecuencia se denomina «relación de Planck»:

de su onda electromagnética asociada. Esta relación entre la energía y la frecuencia se denomina «relación de Planck»: