![gran-muralla-galaxias gran-muralla-galaxias]()

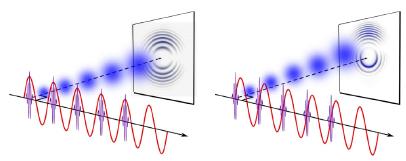

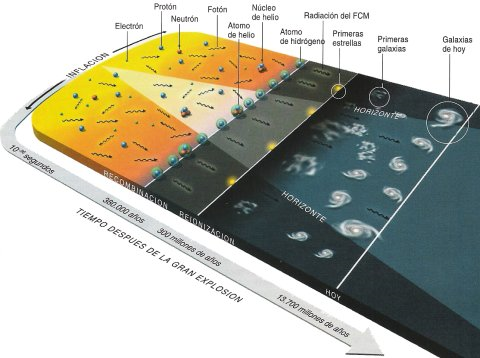

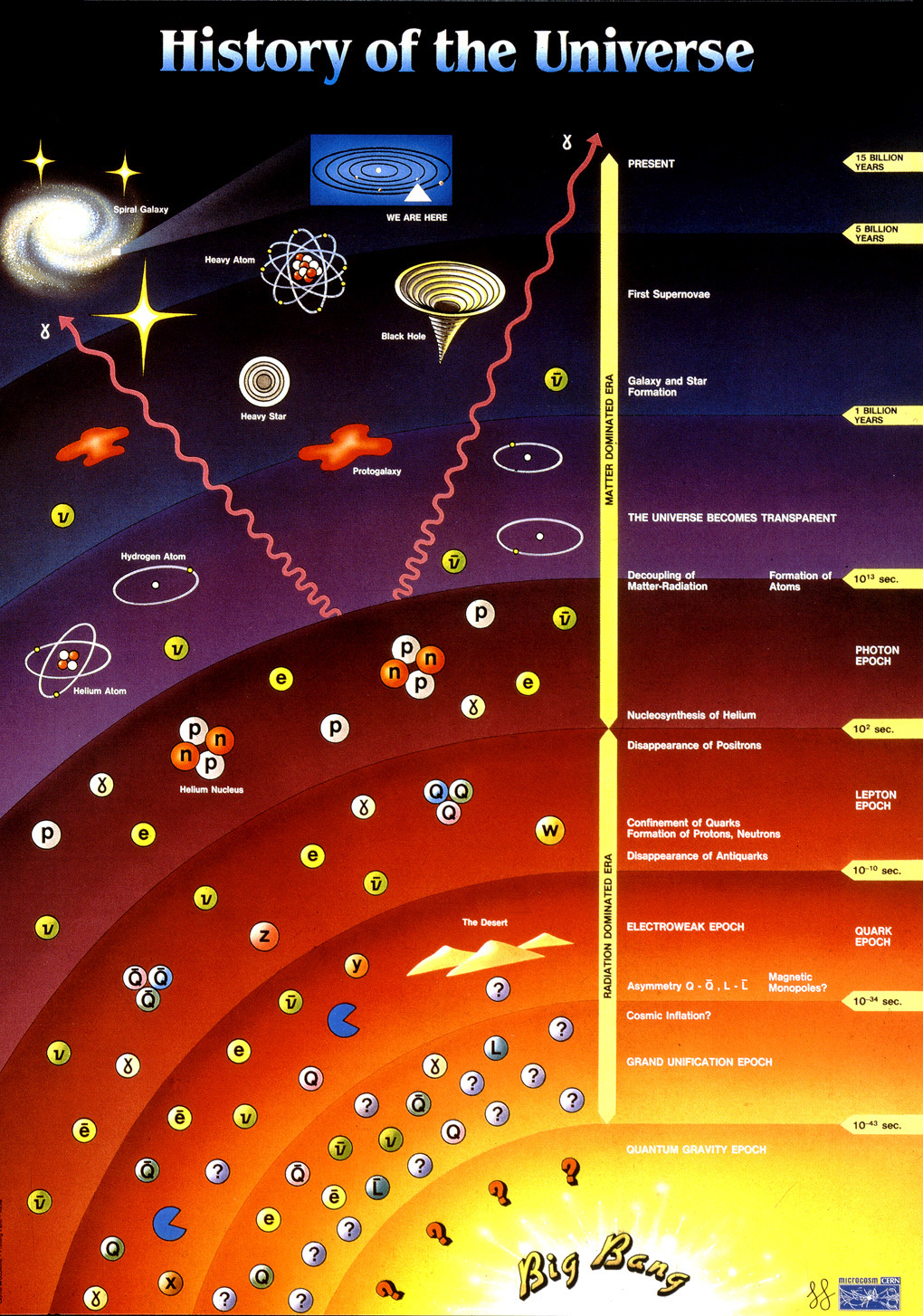

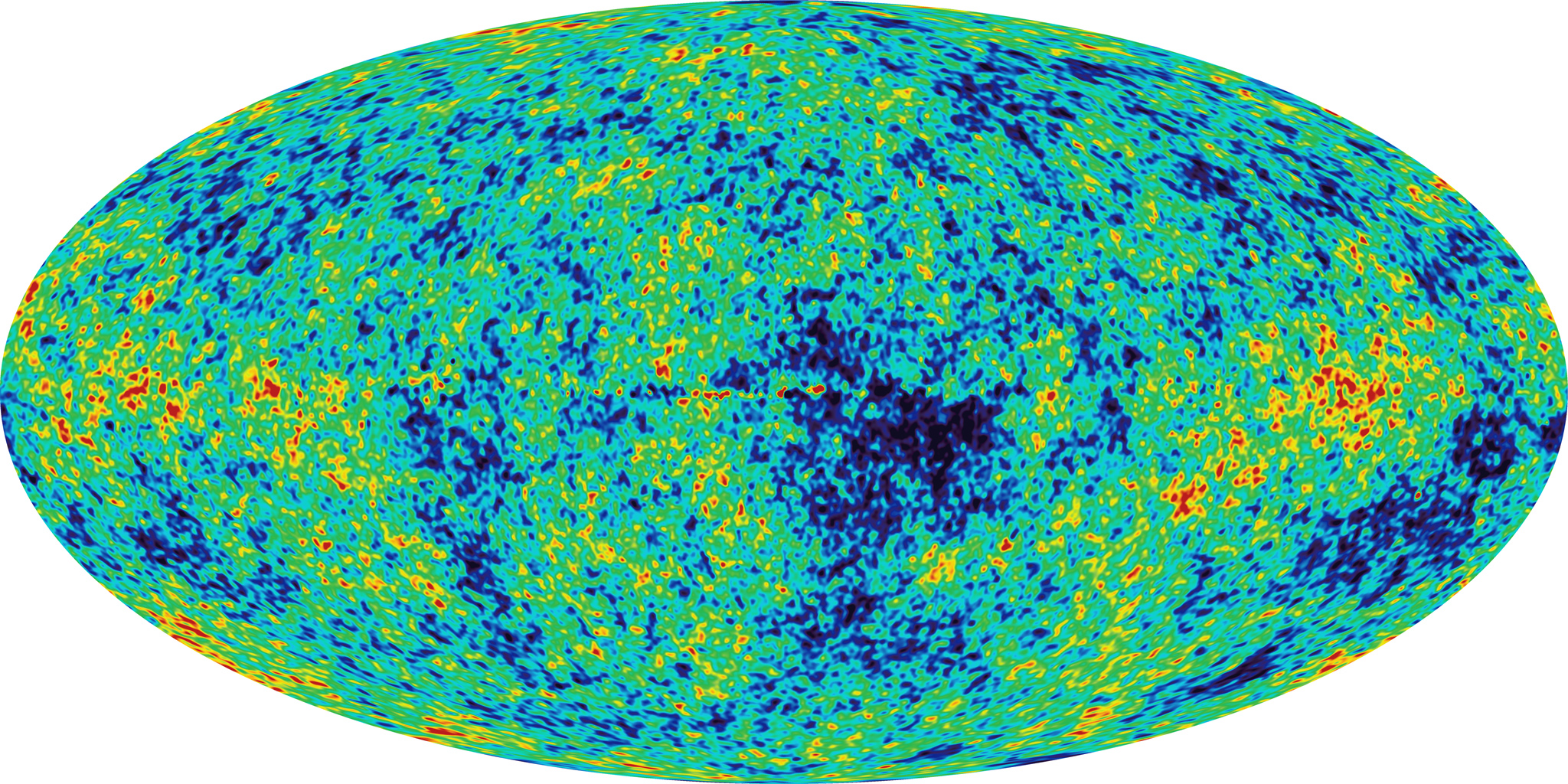

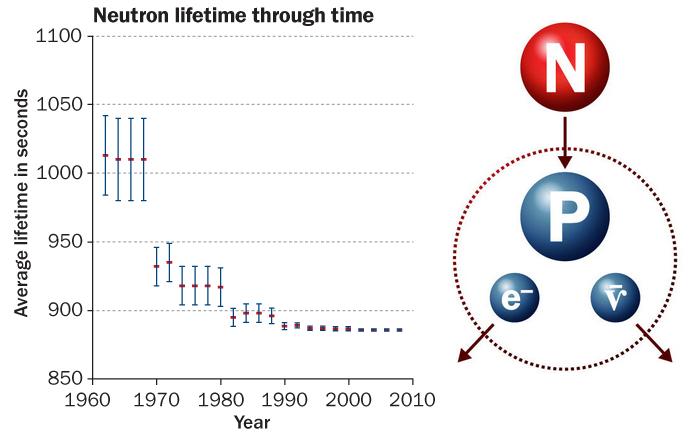

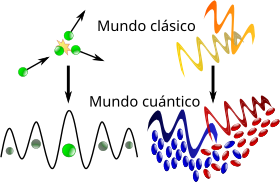

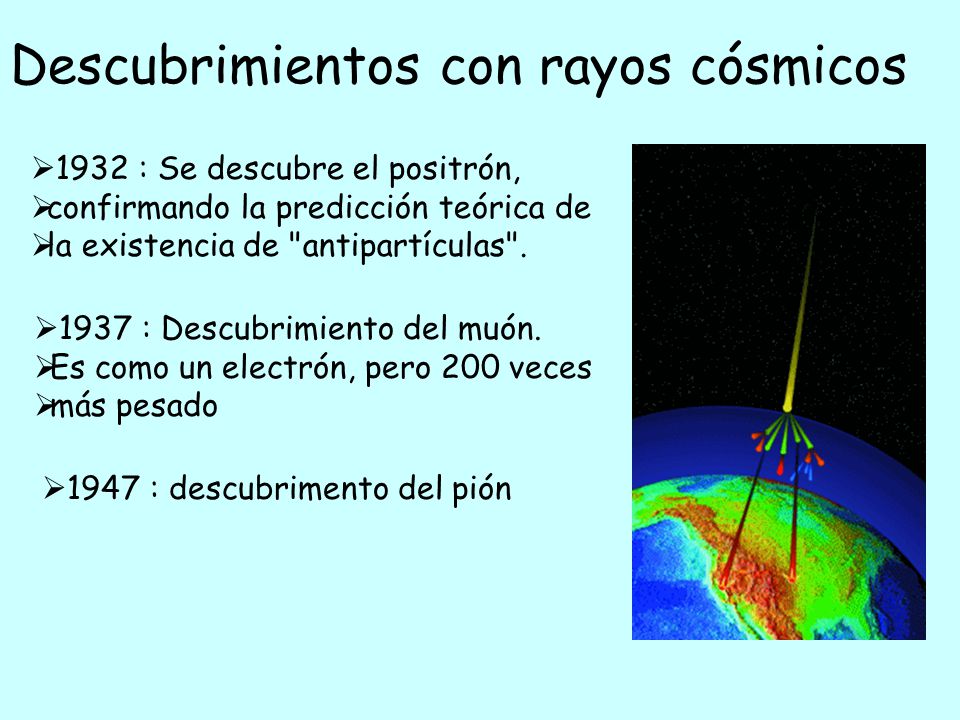

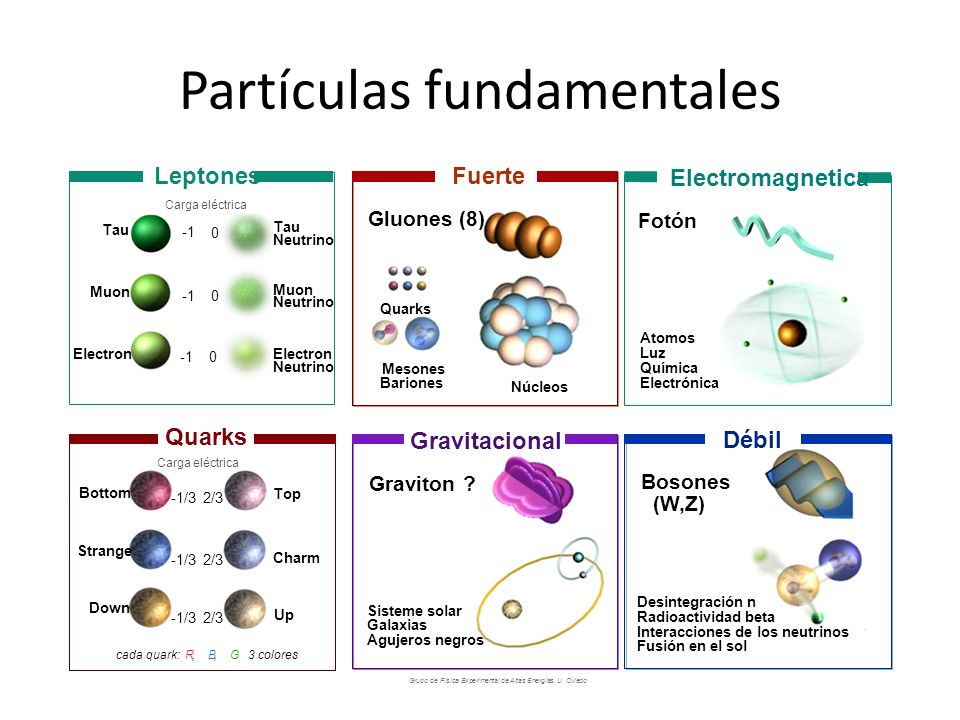

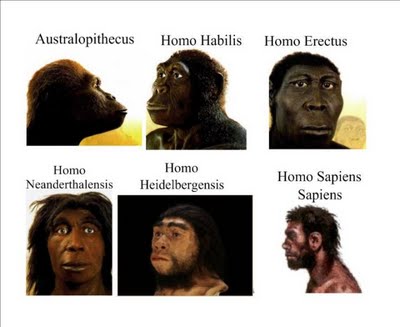

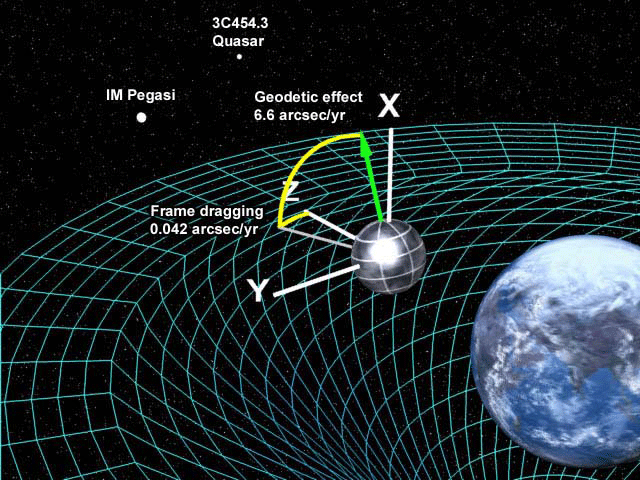

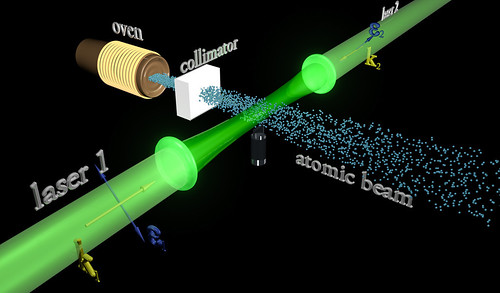

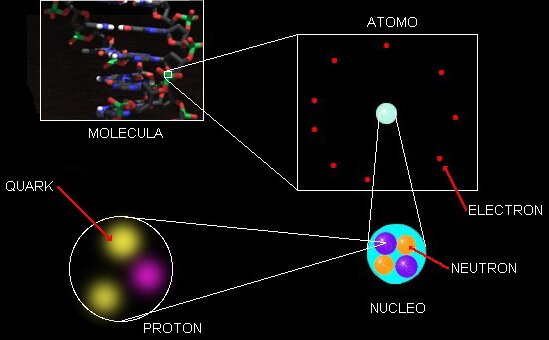

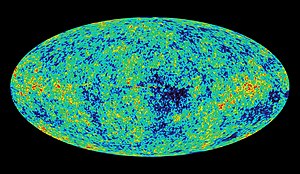

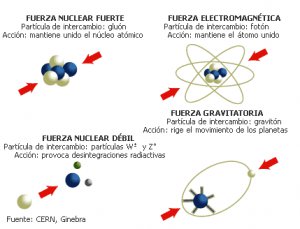

Los científicos para lograr conocer la estructura del universo a su escala más grande, deben retroceder en el tiempo, centrando sus teorías en el momento en que todo comenzó. Para ello, como todos sabeis, se han formulado distintas teorías unificadoras de las cuatro fuerzas de la naturaleza, con las cuales se han modelado acontecimiento y en el universo primitivo casi a todo lo largo del camino hasta el principio. Pero cómo se supone que debió haber habido un «antes», aparece una barrera que impide ir más allá de una frontera que se halla fijada a los 10-43 [s] después del Big Bang, un instante conocido como « de Planck», en homenaje al físico alemán Max Planck.

![Resultado de imagen de La barrera de la era de Planck]()

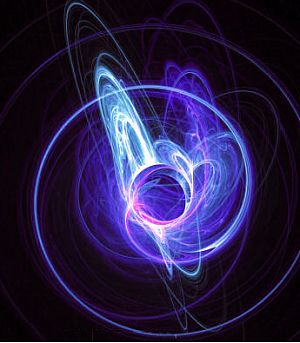

Esta barrera existe debido a que antes del momento de Planck, durante el período llamado la «era de Planck o cuántica», se supone que las cuatro fuerza fundamentales conocidas de la naturaleza eran indistinguibles o se hallaban unificadas , que era una sola fuerza. Aunque los físicos han diseñado teorías cuánticas que unen tres de las fuerzas, una por una, a través de eras que se remontan al momento de Planck, hasta les ha sido prácticamente imposible armonizar las leyes de la teoría cuántica con la gravedad de la relatividad general de Einstein, en un sólo modelo teórico ampliamente convincente y con posibilidades claras de ser contrastado en experimentos de laboratorio y, mucho , con observaciones.

![Más...]()

![]()

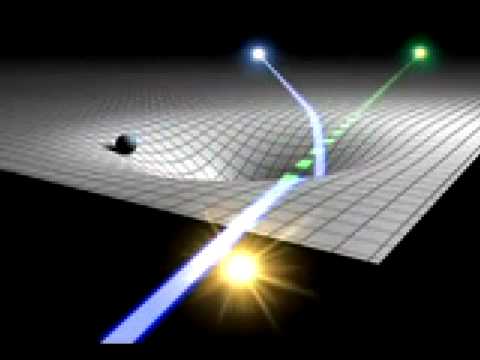

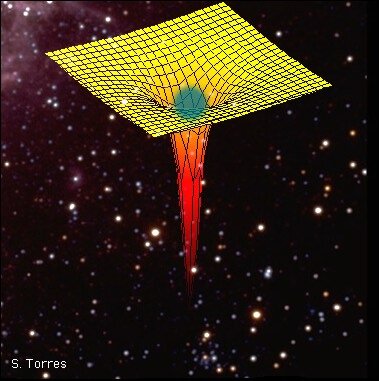

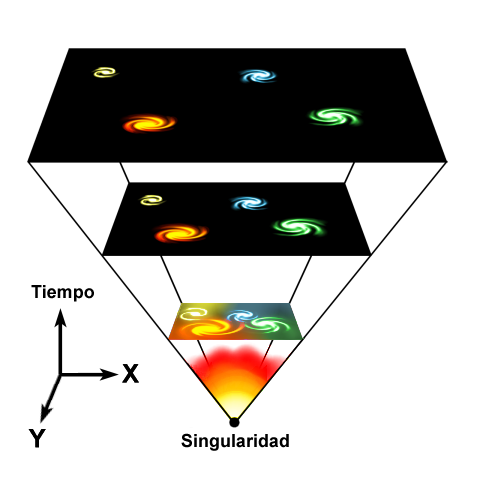

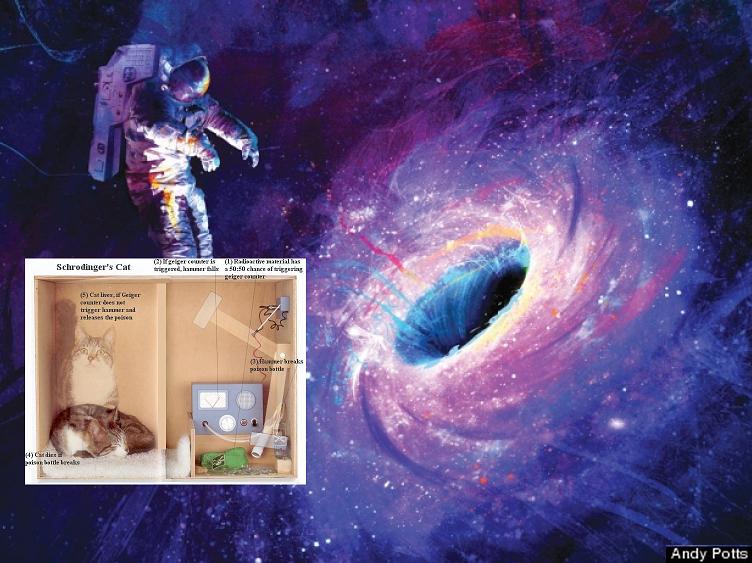

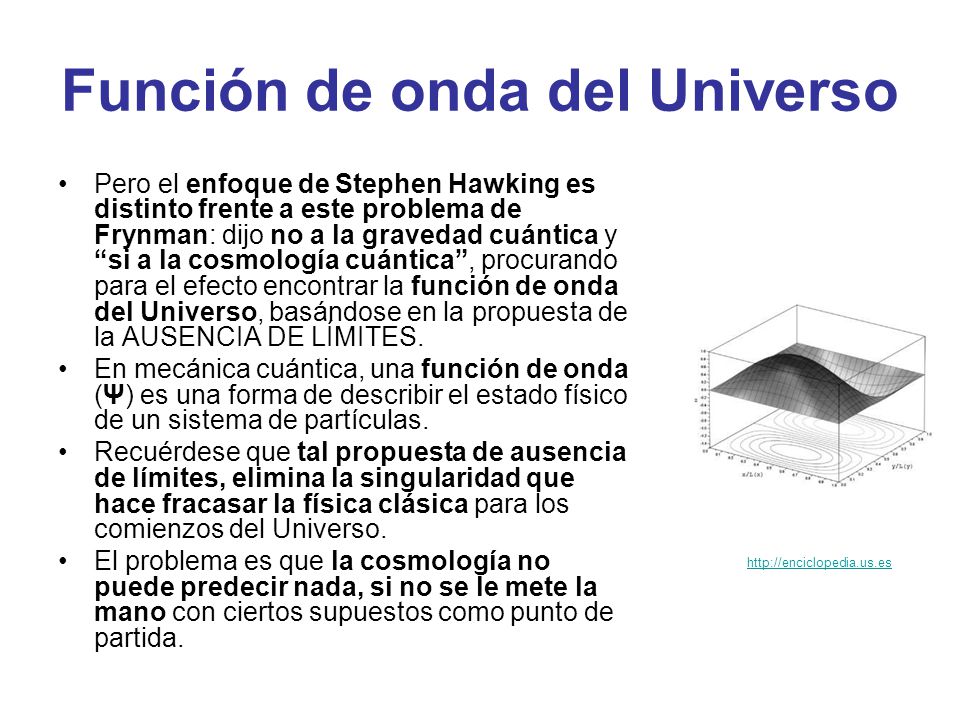

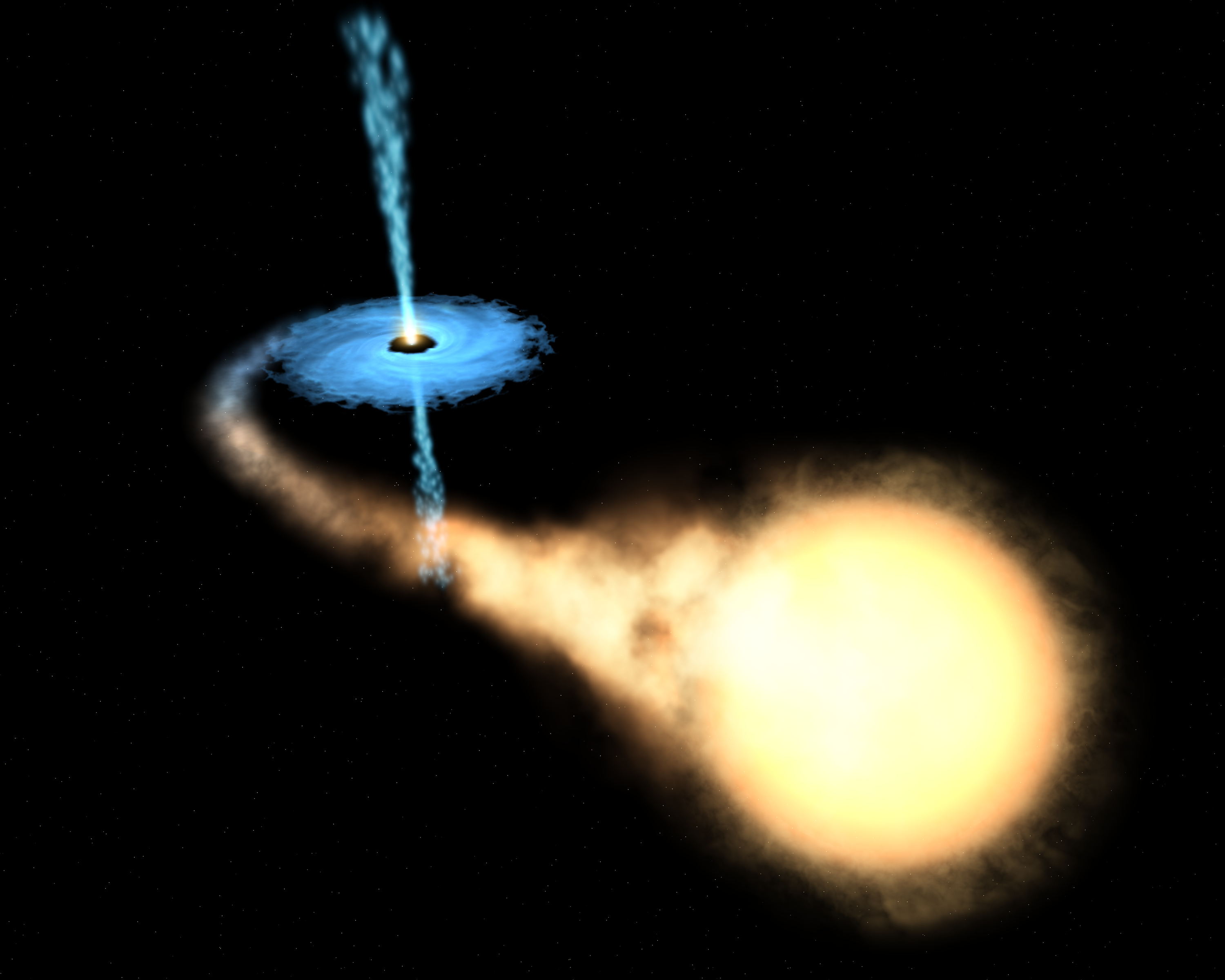

Si hablamos de singularidades en agujeros negros, debemos dejar la R.G. y acudir a la M.C. “…según las leyes de la Relatividad, el eje más horizontal siempre es espacio, mientras que el más vertical siempre es tiempo. Por tanto, al cruzar el horizonte lo que nosotros entendemos por tiempo y espacio ¡habrán intercambiado sus papeles! sonar raro y, definitivamente, es algo completamente anti intuitivo, pero es la clave de que los agujeros negros sean son y jueguen el papel tan importante que juegan en la física teórica actual. Al fin y al cabo, dentro no es lo mismo que fuera…”

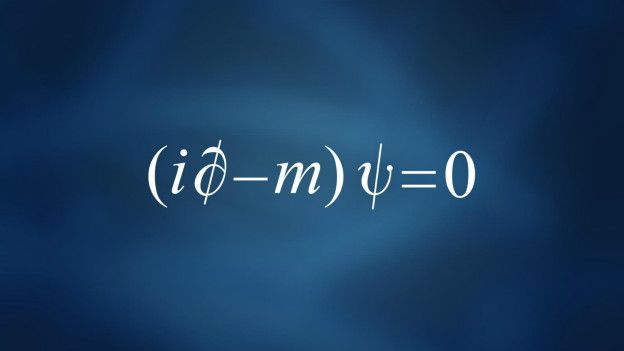

Si queremos cuantizar, es decir encontrar la versión cuántica, la gravedad escrita como RG lo que tenemos que hacer es encontrar la teoría cuántica para la métrica. Sin embargo, esto no conduce a una teoría apropiada, surgen muchos problemas para dar sentido a esta teoría, aparecen infinitos y peor que eso, muchos cálculos no tienen ni tan siquiera un sentido claro. Así que hay que buscar otra forma de intentar llegar a la teoría cuántica.

![Resultado de imagen de TeorÃa cuántica de la Gravedad]()

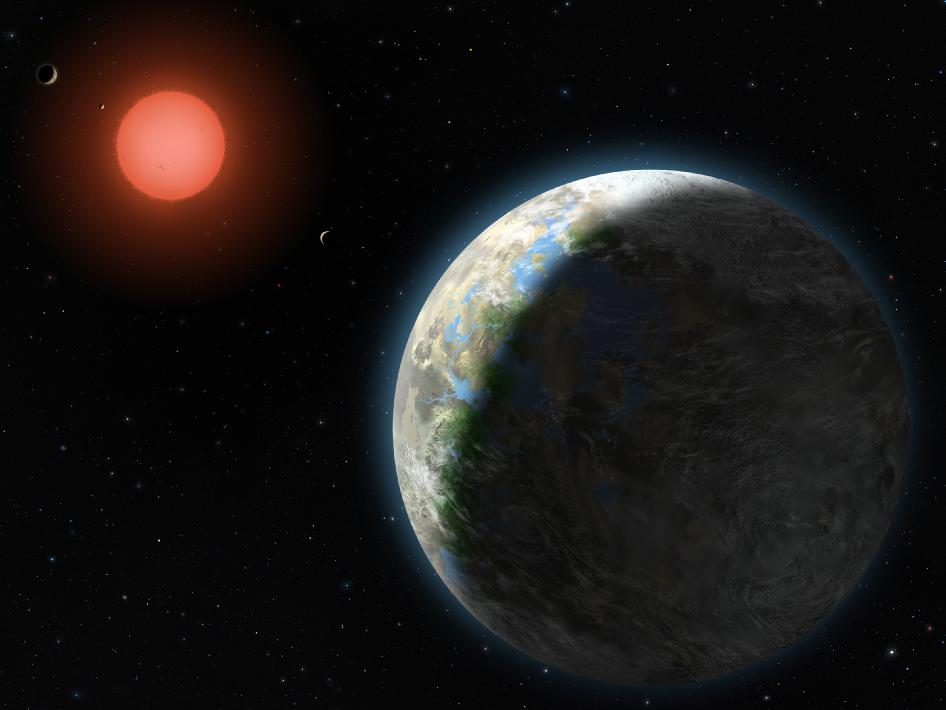

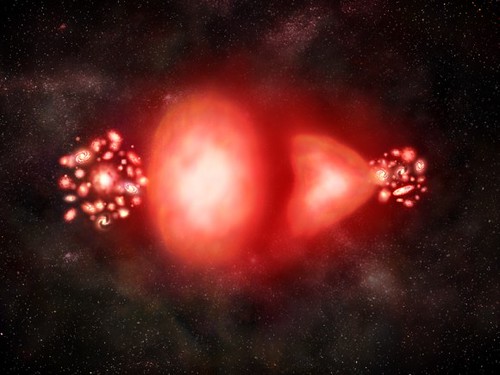

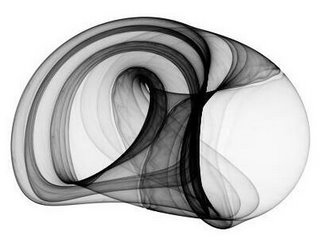

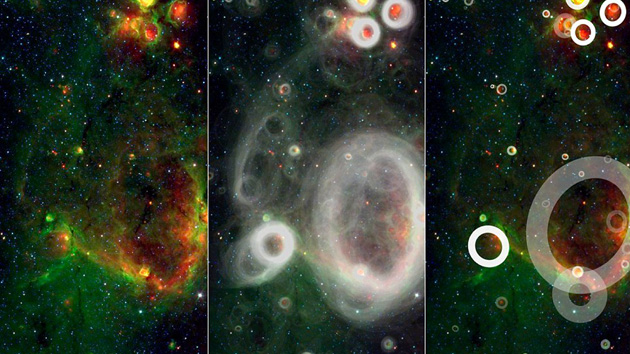

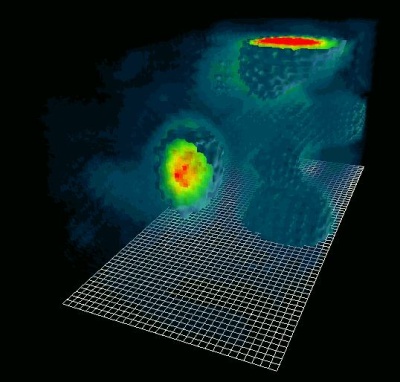

Como tantas veces hemos comentado, los trabajos que se han realizado sobre poder construir una teoría cuántica de la gravedad nos llevan a un sorprendente de implicaciones. Por un lado, sólo se ha podido conceptuar a la gravedad cuántica, siempre y cuando, el universo tenga más de cuatro dimensiones. Además, se llega a considerar que en la era de Planck, tanto el universo como la gravedad pudieron ser una sola cosa compacta estructurada por objetos cuánticos infinitamente diminutos, como los que suponemos que conforman las supercuerdas. A esta escala, el mismísimo espaciotiempo estaría sometido a imprescindibles fluctuaciones muy semejantes a las que causan las partículas al nacer y desaparecer de la existencia en el espacio.tiempo ordinario. Esta noción ha conducido a los teóricos a describir el universo de la era cuántica como una especie de extremadamente densa y agitada espuma que pudo haber contenido las vibrantes cuerdecillas que propugnan los cosmólogos cuerdistas.

Los físicos especulan que el cosmos ha crecido a una «nada» primigenia que al nacer comenzó el principio del tiempo y que, en ese parto, contenía toda la materia y toda la energía.

![Imagen relacionada]()

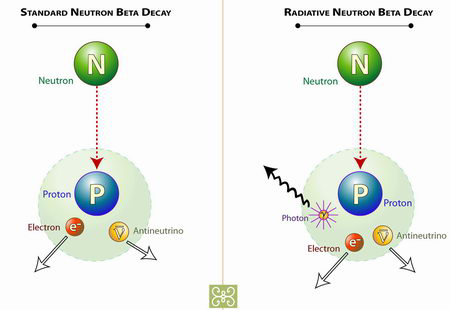

Según los primeros trabajos sobre la teoría cuántica de la gravedad, el propio espaciotiempo varió en su topografía, dependiendo de las dimensiones del universo niño. Cuando el universo era del tamaño de un núcleo atómico (ver imagen de abajo), las eran relativamente lisas y uniformes; a los 10-30cm (centro) es evidente una cierta granulidad; y a la llamada longitud de Planck, todavía unas 1.000 veces más pequeño (abajo), el espacio tiempo fluctúa violentamente.

![]()

Los físicos han intentado con denuedo elaborar una teoría completa de la gravedad que incluya la mecánica cuántica. Los cálculos de la mayoría de las teorías propuesta de la «gravedad cuántica» arrojan numerosos infinitos. Los físicos no están seguros si el problema es técnico o conceptual. No obstante, incluso prescindiendo de una teoría completa de gravedad cuántica, se deducir que los efectos de la teoría cuántica, habrían sido cruciales durante los primeros 10-43 segundos del inicio del universo, éste tenía una densidad de 1093 gramos por centímetro cúbico y mayor. (El plomo sólido tiene una densidad de aproximadamente diez gramos por centímetro cúbico.) Este período, que es el que corresponde a la era de Planck, y a su estudio se le llama cosmología cuántica. Como el universo en su totalidad habría estado sujeto a grandes incertidumbres y fluctuaciones durante la era de Planck o era cuántica, con la materia y la energía apareciendo y desapareciendo de un vacío en grandes cantidades, el concepto de un principio del universo podría no tener un significado bien definido. En todo caso, la densidad del universo durante este período es de tal magnitud que escapa a nuestra comprensión. Para propósitos prácticos, la era cuántica podría considerarse el estado inicial, o principio, del universo. En consecuencia, los procesos cuánticos ocurridos durante este período, cualquiera sea su naturaleza, determinaron las iniciales del universo.

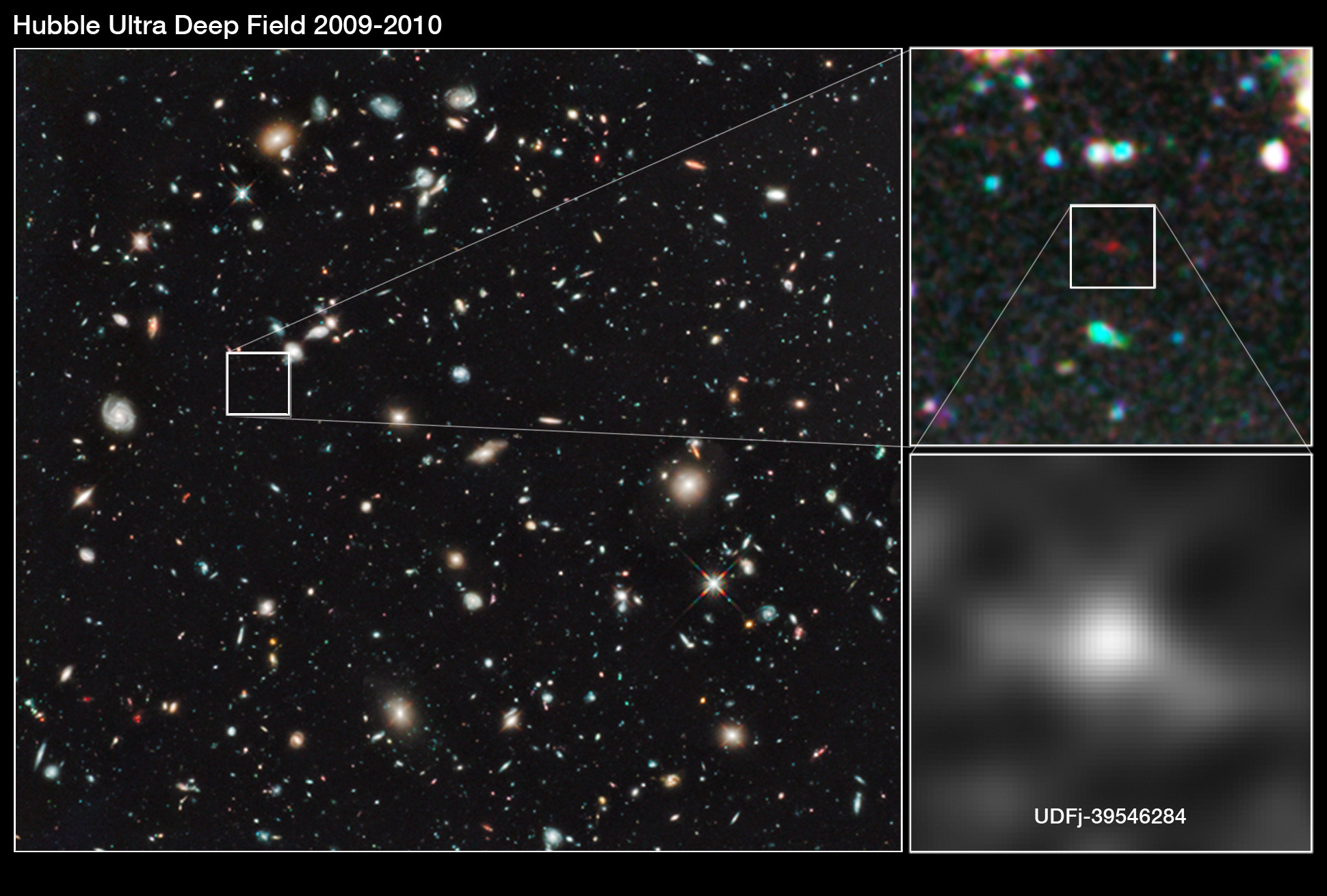

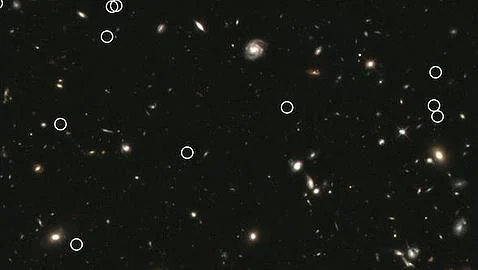

![]()

Dicen haber descubierto la estructura más grande del Universo. Se trata de una «gran muralla» de 10.000 millones de años luz de un extremo a otro, que pone en jaque lo que creíamos saber sobre la distribución de la materia. De todas las maneras nada de esto es sorprendente. El Universo es muy grande y en su vastedad esconde secretos que debemos resolver.

El universo estaba a 3.000° K hace doce mil quinientos millones de años; a 10 mil millones de grados (1010° K) un millón de años , y, tal vez, a 1028° K un par de millones más temprano. Pero, y antes de ese tiempo ¿qué pasaba? Los fósiles no faltan, pero no sabemos interpretarlos. Mientras más elevada se va haciendo la temperatura del universo primigenio, la situación se va complicando los científicos. En la barrera fatídica de los 1033° K –la temperatura de Planck–, nada funciona. Nuestros actuales conocimientos de la física dejan de ser útiles. El comportamiento de la materia en estas condiciones tan extremas deja de estar a nuestro alcance de juicio. Peor aún, nuestras nociones tradicionales pierden su valor. Es una barrera infranqueable para el saber de la física contemporánea. Por eso, lo que se suele decir cómo era el universo inicial en esos tempranos períodos, no deja de tener visos de especulación.

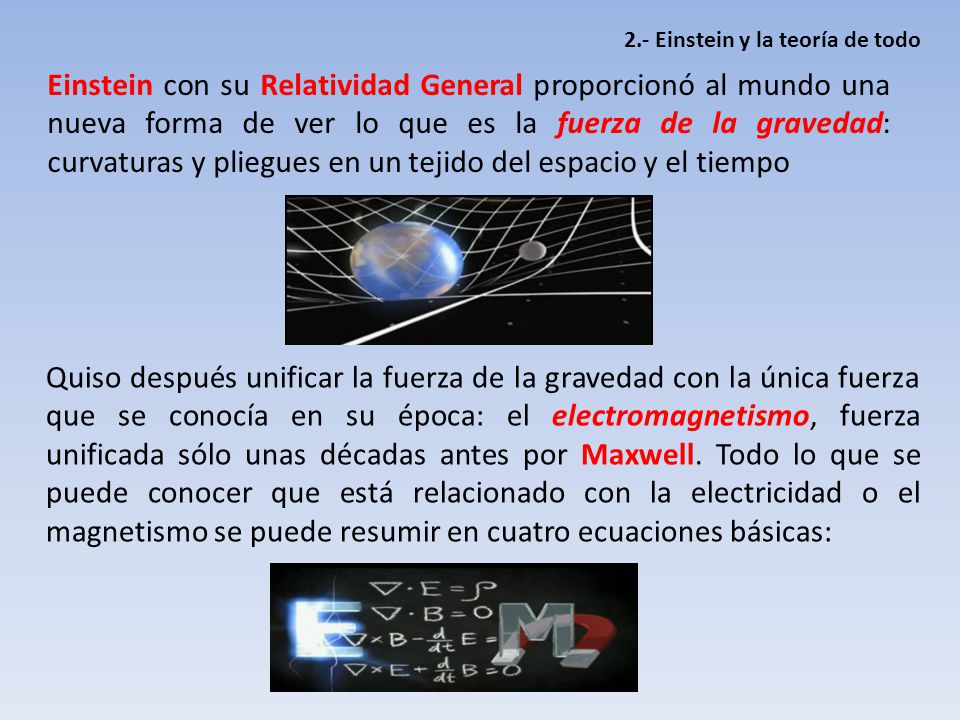

Los progresos que se han obtenido en física teórica se manifiestan a menudo en términos de síntesis de campos diferentes. Varios son los ejemplos que de ello encontramos en diversos estudios especializados, que hablan de la unificación de las fuerzas fundamentales de la naturaleza.

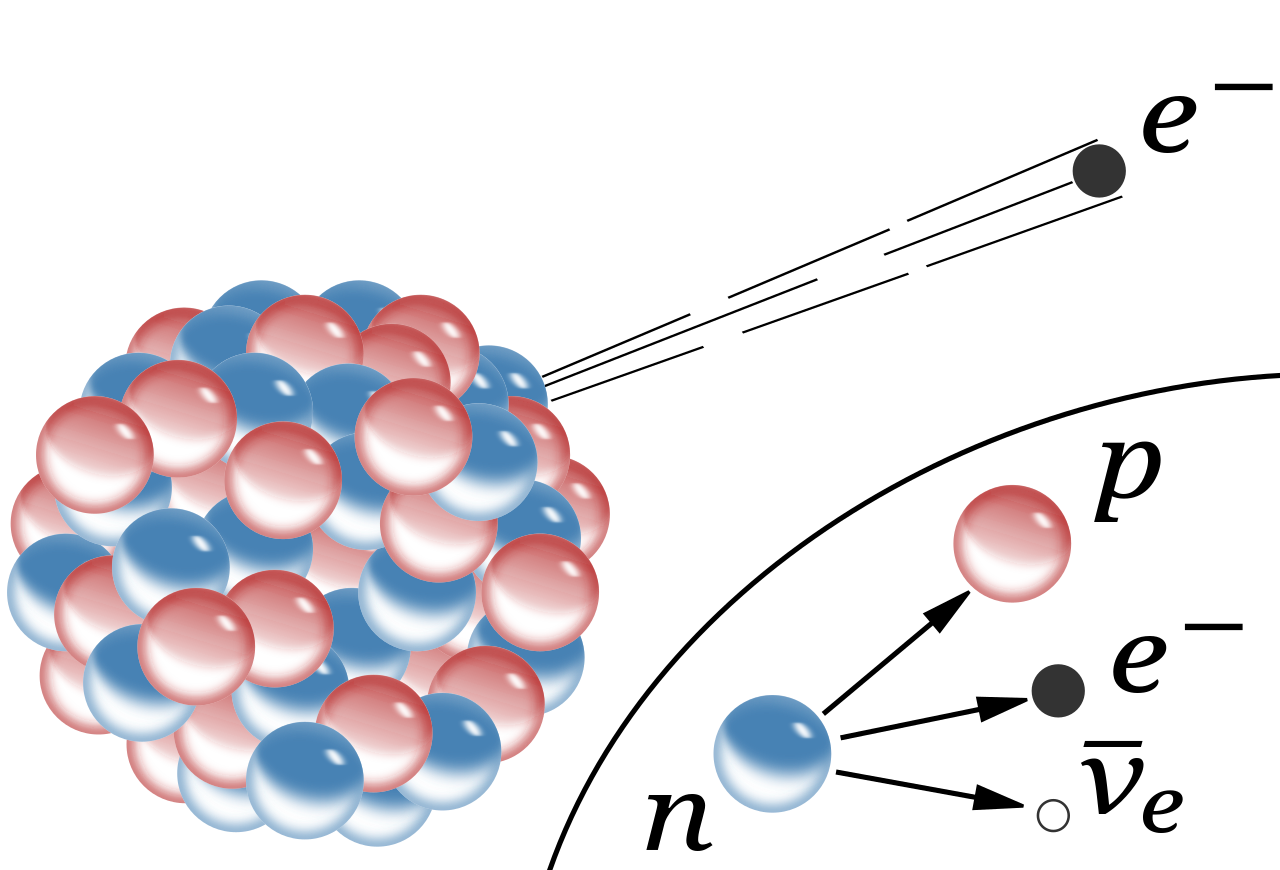

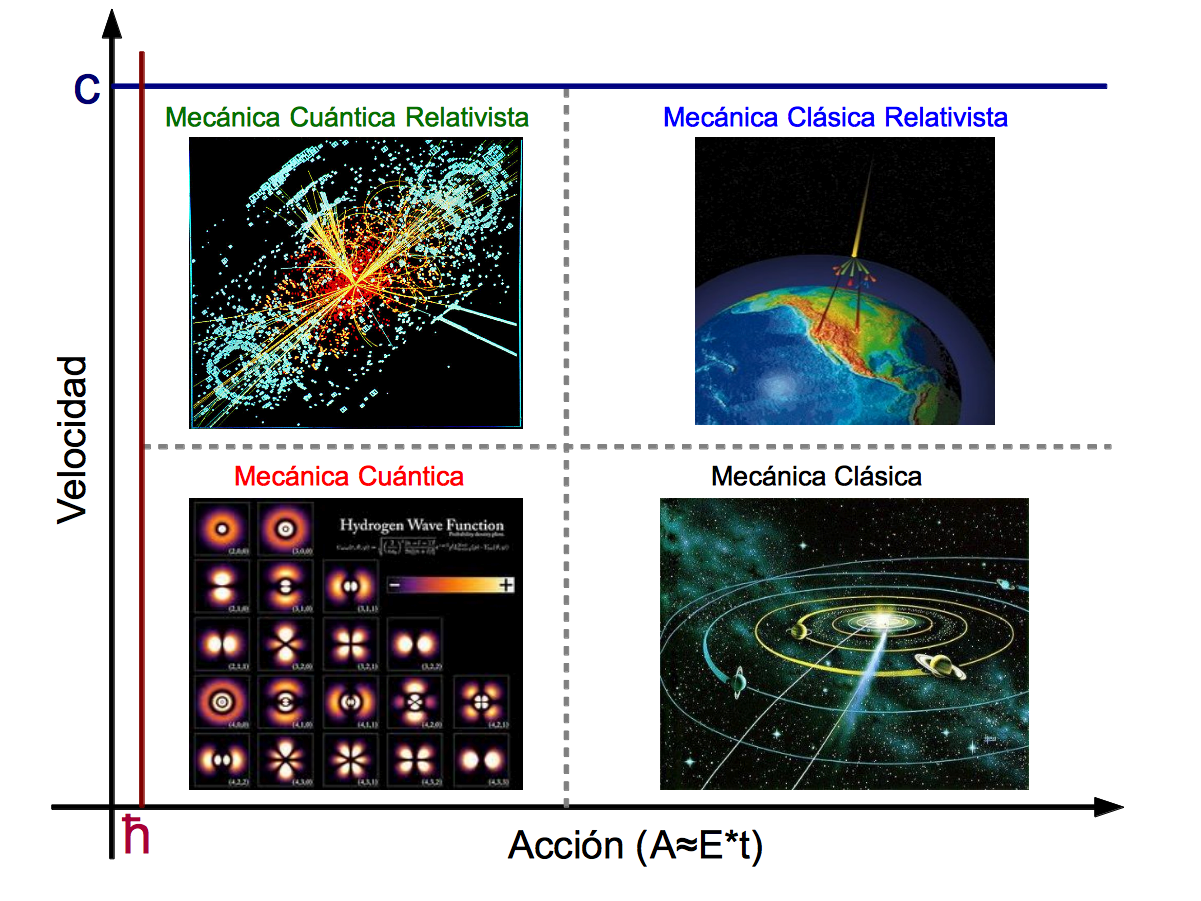

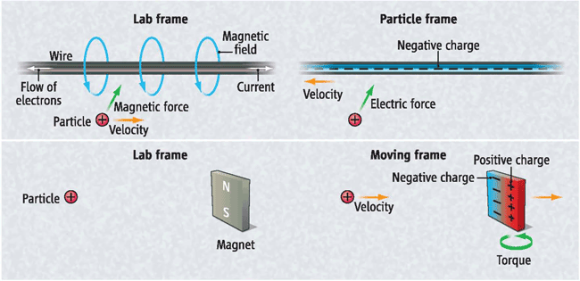

En física se cuentan con dos grandes teorías de éxito: la cuántica y la teoría de la relatividad general.

![]()

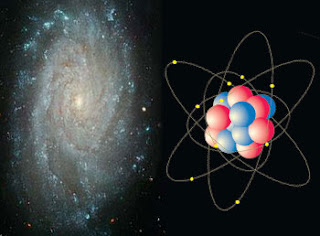

Grande y pequeño: ¡Todo la misma cosa!

Cada una de ellas ha demostrado ser muy eficiente en aplicaciones dentro de los límites de su ámbito propio. La teoría cuántica ha otorgado resultados más que satisfactorios en el estudio de las radiaciones, de los átomos y de sus interacciones. La ciencia contemporánea se presenta como un conjunto de teorías de campos, aplicables a tres de las grandes interacciones: electromagnética, nuclear fuerte, nuclear débil. Su poder predictivo es bastante elocuente, pero no universal. Esta teoría es, por , incapaz de describir el comportamiento de partículas inmersas en un campo de gravedad intensa. Ahora, no sabemos si esos fallos se deben a un problema conceptual de fondo o falta de capacidad matemática para encontrar las ecuaciones precisas que permitan la estimación del comportamiento de las partículas en esos ambientes.

La teoría de la relatividad general, a la inversa, describe con gran precisión el efecto de los campos de gravedad sobre el comportamiento de la materia, pero no sabe explicar el ámbito de la mecánica cuántica. Ignora todo acerca de los campos y de la dualidad onda-partícula, y en ella el «vacío» es verdaderamente vacío, mientras que la física cuántica hasta la «nada» es «algo»…

![]()

Nada está vacío, ya que, de donde surge es porque había

Claro está, que esas limitaciones representativas de ambas teorías no suelen tener mucha importancia práctica. Sin embargo, en algunos casos, esas limitantes se hacen sentir con agresividad frustrando a los físicos. Los primeros instantes del universo son el ejemplo más elocuente.

El científico investigador, al requerir estudiar la temperatura de Planck, se encuentra con un cuadro de densidades y gravedades extraordinariamente elevadas. ¿Cómo se comporta la materia en esas ? Ambas teorías, no dicen mucho al respecto, y entran en serias contradicciones e incompatibilidades. De ahí la resistencia de estas dos teorías a unirse en una sólo teoría de Gravedad-Cuantíca, ya que, cada una de ellas reina en un universo diferente, el de lo muy grande y el de lo muy pequeño.

Todo se desenvuelve alrededor de la noción de localización. La teoría cuántica limita nuestra aptitud asignar a los objetos una posición exacta. A cada partícula le impone un volumen mínimo de localización. La localización de un electrón, por ejemplo, sólo puede definirse alrededor de trescientos fermis (más o menos un centésimo de radio del átomo de hidrógeno). , si el objeto en cuestión es de una mayor contextura másica, más débiles son la dimensión de este volumen mínimo. Se puede localizar un protón en una esfera de un décimo de fermi, pero no mejor que eso. Para una pelota de ping-pong, la longitud correspondiente sería de 10-15 cm, o sea, bastante insignificante.La física cuántica, a toda partícula de masa m le asigna una longitud de onda Compton: lc = h / 2p mc

![]()

Por su , la relatividad general igualmente se focaliza en la problemática del lugar que ocupan los objetos. La gravedad que ejerce un cuerpo sobre sí mismo tiende a confinarlo en un espacio restringido. El caso límite es aquel del agujero negro, que posee un campo de gravedad tan intenso que, salvo la radiación térmica, nada, ni siquiera la luz, escapársele. La masa que lo constituye está, según esta teoría, irremediablemente confinada en su interior.

En lo que hemos inmediatamente descrito, es donde se visualizan las diferencias esos dos campos del conocimiento. Uno alocaliza, el otro localiza. En general, esta diferencia no presenta problemas: la física cuántica se interesa sobre todo en los microobjetos y la relatividad en los macro-objetos. Cada cual en su terreno.

![Resultado de imagen de Macroobjetos]()

Vista de detalle, macro de una ronda simétrico de flor de la Pasionaria

Sin embargo, ambas teorías tienen una frontera común entrar en dificultades. Se encuentran objetos teóricos de masa intermedia entre aquella de los microobjetos como los átomos y aquella de los macro-objetos como los astros: las partículas de Planck. Su masa es más o menos la de un grano de sal: 20 microgramos. Equivale a una energía de 1028 eV o, más aún, a una temperatura de 1033° K. Es la «temperatura de Planck».

bien, si queremos estimar cuál debería ser el radio en que se debe confinar la masita de sal para que se vuelva un agujero negro, con la relatividad general la respuesta que se logra encontrar es de que sería de 10-33 cm, o sea ¡una cien mil millonésima de mil millonésima de la dimensión del protón! Esta dimensión lleva el de «radio de Planck». La densidad sería de ¡1094 g/cm3! De un objeto así, comprimido en un radio tan, pero tan diminuto, la relatividad general sólo nos señala que tampoco nada puede escapar de ahí. No es mucha la información.

![]()

Si recurrimos a la física cuántica estimar cuál sería el radio mínimo de localización para un objeto semejante al granito de sal, la respuesta que encontramos es de un radio de 10-33 cm. Según teoría, en una hipotética experiencia se lo encontrará frecuentemente fuera de ese volumen. ¡Ambos discursos no son coincidentes! Se trata de discrepancias que necesitan ser conciliadas para poder progresar en el conocimiento del universo. ¿Se trata de entrar en procesos de revisión de ambas teoría, o será necesaria una absolutamente nueva? Interrogantes que solamente el devenir de la evolución de la física teórica las podrá responder en el futuro.

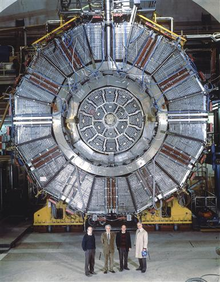

De todas las maneras, en lo que se refiere a una Teoría cuántica de la Gravedad, tendremos que esperar a que se confirmen las teorías de supergravedad, supersimetría, cuerdas, la cuerda heterótica, supercuerdas y, la compendiada por Witten Teoría M. Aquí, en estas teorías (que dicen ser del futuro), sí que están apaciblemente unidas las dos irreconciliables teorías: la cuántica y la relativista, no sólo no se rechazan ni emiten infinitos, sino que, se necesitan y complementan para formar un todo armónico y unificador.

¡Si pudiéramos verificarla!

, contar con la energía de Planck (1019 GeV), no parece que, al menos de , sea de este mundo. Ni todos los aceleradores de partículas del mundo unidos, podrían llegar a conformar una energía semejante.

![http://francisthemulenews.files.wordpress.com/2010/08/dibujo20100822_hoag_object_a1515_2146_hubble_space_telescope1.png]()

Aunque de extraña y atípica figura, también, galaxia, está hecha de materia

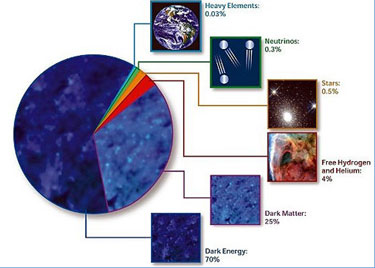

Tiene y encierra tantos misterios la materia que estamos aún a muchos años-luz de saber y conocer sobre su verdadera naturaleza. Es algo que vemos en sus distintas formas materiales que configuran y conforman todo lo material desde las partículas elementales hasta las montañas y los océanos. Unas veces está en “inerte” y otras, se eleva hasta la vida que incluso, en ocasiones, alcanza la consciencia de SER. Sin embargo, no acabamos de dilucidar de dónde viene su verdadero origen y que era antes de “ser” materia. ¿Existe acaso una especie de sustancia cósmica anterior a la materia? Y, si realmente existe esa sustancia… ¿Dónde está? Aristóteles la llamaba Ylem, la sustancia o materia cósmica antes de la materia, a partir del Ylem llegaría la materia bariónica, la ue conocemos y de la que todo está hecho.

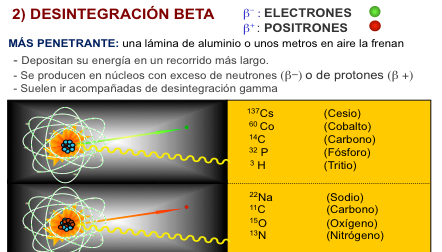

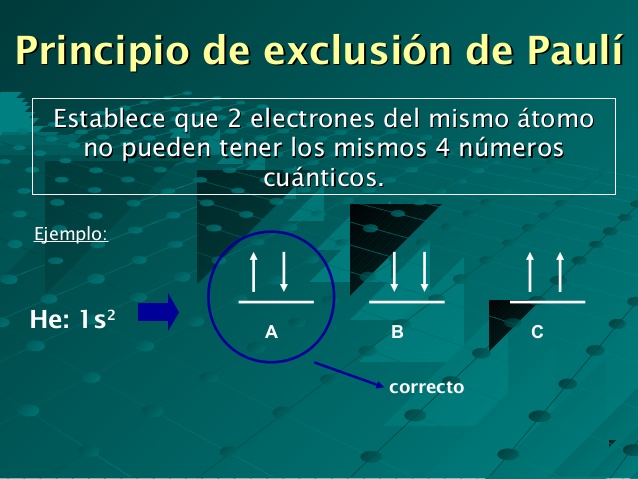

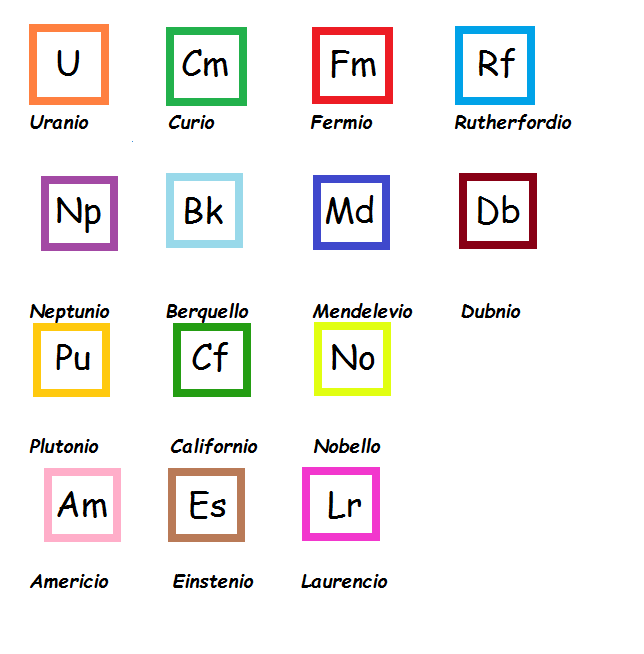

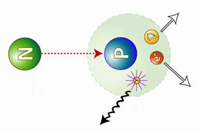

![]()

Nos podríamos preguntar miles de cosas que no sabríamos contestar. Nos maravillan y asombran fenómenos naturales que ocurren ante nuestros ojos pero que tampoco sabemos, en realidad, a que son debidos. Sí, sabemos ponerles etiquetas , por ejemplo, la fuerza nuclear débil, la fisión espontánea que tiene lugar en algunos elementos como el protactinio o el torio y, con mayor frecuencia, en los elementos que conocemos como transuránicos.

A medida que los núcleos se hacen más grandes, la probabilidad de una fisión espontánea aumenta. En los elementos más pesados de todos (einstenio, fermio y mendelevio), esto se convierte en el método más importante de ruptura, sobrepasando a la emisión de partículas alfa.

¡Parece que la materia está viva!

![]()

Son muchas las cosas que desconocemos y, nuestra curiosidad nos empuja continuamente a buscar esas respuestas.

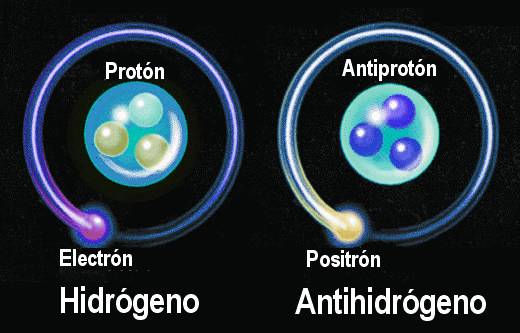

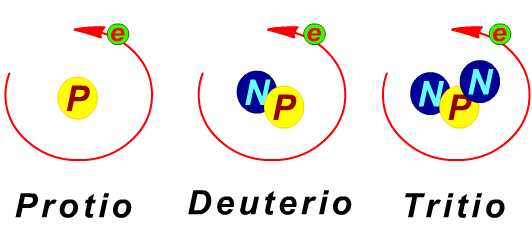

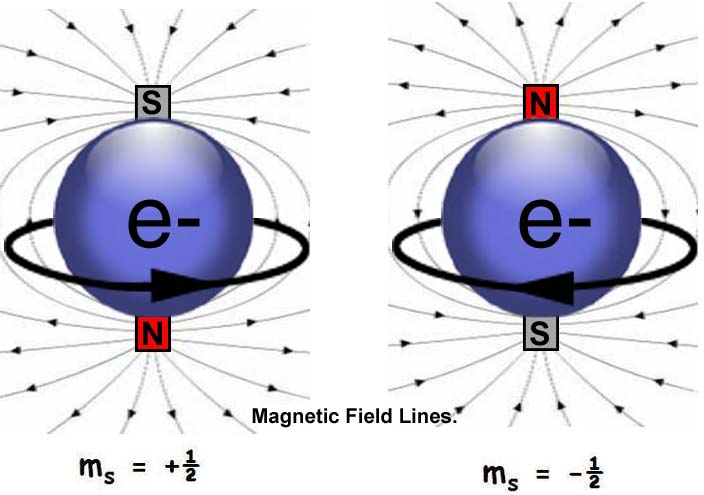

El electrón y el positrón son notables por sus pequeñas masas (sólo 1/1.836 de la del protón, el neutrón, el antiprotón o antineutrón), y, por lo tanto, han sido denominados leptones (de la voz griega lepto que significa “delgado”).

Aunque el electrón fue descubierto en 1.897 por el físico británico Josepth John Thomson (1856-1940), el problema de su estructura, si la hay, no está resuelto. Conocemos su masa y su carga negativa que responden a 9,1093897 (54)x10-31kg la primera y, 1,602 177 33 (49)x10-19 culombios, la segunda, y su radio clásico. No se ha descubierto aún ninguna partícula que sea menos masiva que el electrón (o positrón) y que lleve una carga eléctrica, sea lo que fuese (sabemos como actúa y cómo medir sus propiedades, pero aun no sabemos qué es), tenga asociada un mínimo de masa, y que es la que se muestra en el electrón.

![Resultado de imagen de Joseph John Thomson]()

Josepth John Thomson

Lo cierto es que, el electrón, es una maravilla en sí mismo. El Universo no sería lo conocemos si el electrón (esa cosita “insignificante”), fuese distinto a como es, bastaría un cambio infinitesimal para que, por ejemplo, nosotros no pudiéramos estar aquí .

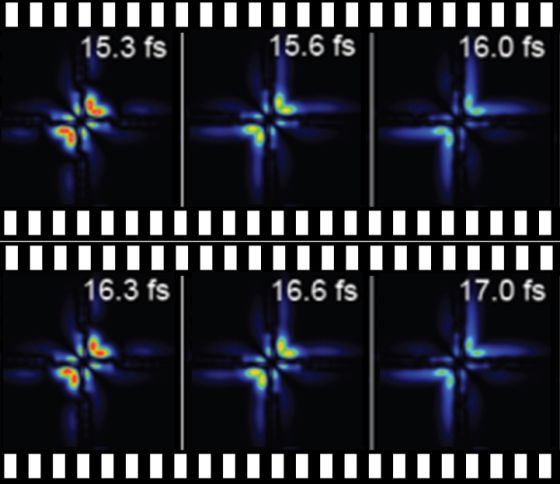

(“Aunque no se trata propiamente de la imagen real de un electrón, un equipo de siete científicos suecos de la Facultad de Ingeniería de la Universidad de Lund consiguieron captar en vídeo por primera vez el movimiento o la distribución energética de un electrón sobre una onda de luz, tras ser desprendido previamente del átomo correspondiente.

![Resultado de imagen de películas de electrones que se movían a través de helio líquido en el International Symposium on Quantum Fluids and Solids del 2006]()

Previamente dos físicos de la Universidad Brown habían mostrado películas de electrones que se movían a través de helio líquido en el International Symposium on Quantum Fluids and Solids del 2006. Dichas imágenes, que mostraban puntos de luz que bajaban por la pantalla fueron publicadas en línea el 31 de mayo de 2007, en el Journal of Low Temperature Physics.

En el experimento que ahora nos ocupa y dada la altísima velocidad de los electrones el equipo de investigadores ha tenido que usar una nueva tecnología que genera pulsos cortos de láser de luz intensa (“Attoseconds Pulses”), habida que un attosegundo equivalente a la trillonésima parte de un segundo”.)

¡No por pequeño, se es insignificante! Recordémoslo, todo lo grande está hecho de cosas pequeñas.

![Haga clic para mostrar el resultado de "Louis de Broglie" número 12]()

Louis de Broglie

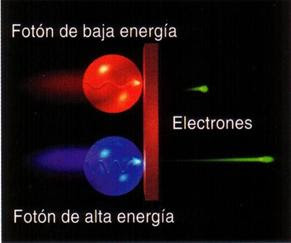

En realidad, existen partículas que no tienen en absoluto asociada en ellas ninguna masa (es decir, ninguna masa en reposo). Por ejemplo, las ondas de luz y otras formas de radiación electromagnéticas se comportan partículas (Einstein en su efecto fotoeléctrico y De Broglie en la difracción de electrones.)

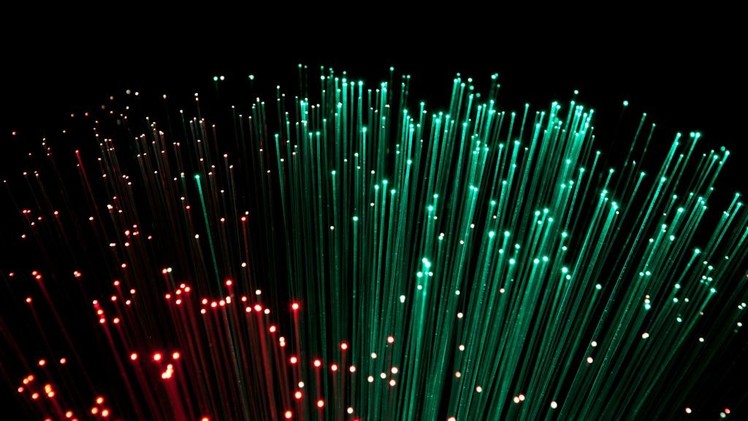

![]()

Imagen ilustrativa de la dualidad onda-partícula, en el cual se puede ver cómo un mismo fenómeno puede tener dos percepciones distintas. Esta manifestación en de partículas de lo que, de ordinario, concebimos como una onda se denomina fotón, de la palabra griega que significa “luz”.

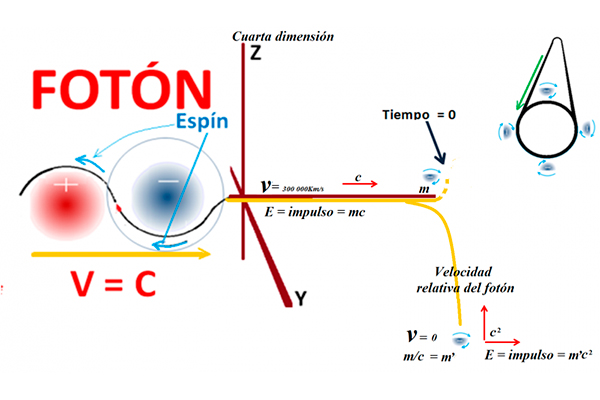

El fotón una masa de 1, una carga eléctrica de 0, pero posee un espín de 1, por lo que es un bosón. ¿Cómo se definir lo que es el espín? Los fotones toman en las reacciones nucleares, pero el espín total de las partículas implicadas antes y después de la reacción deben permanecer inmutadas (conservación del espín). La única forma que esto suceda en las reacciones nucleares que implican a los fotones radica en suponer que el fotón tiene un espín de 1. El fotón no se considera un leptón, puesto que este termino se reserva la familia formada por el electrón, el muón y la partícula Tau con sus correspondientes neutrinos: Ve, Vu y VT.

![]()

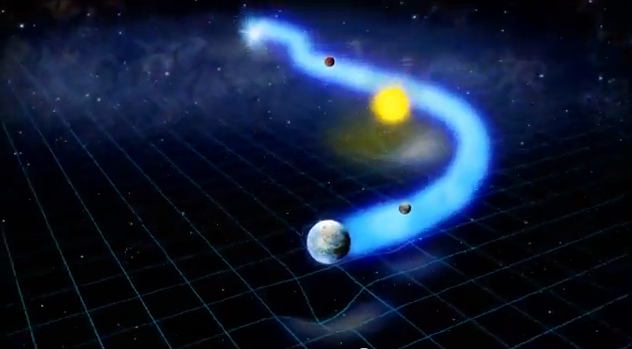

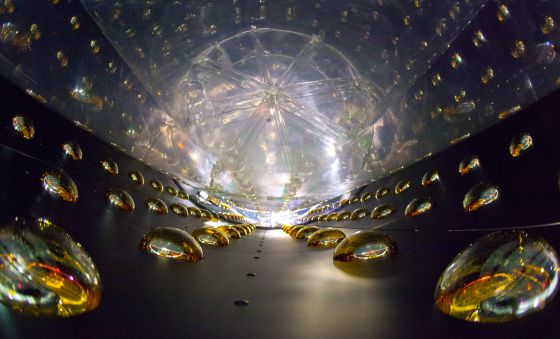

Existen razones teóricas para suponer que, cuando las masas se aceleran (como cuando se mueven en órbitas elípticas en torno a otra masa o llevan a cabo un colapso gravitacional), emiten energía en forma de ondas gravitacionales. Esas ondas pueden así mismo poseer aspecto de partícula, por lo que toda partícula gravitacional recibe el de gravitón.

La fuerza gravitatoria es mucho, mucho más débil que la fuerza electromagnética. Un protón y un electrón se atraen gravitacionalmente con sólo 1/1039 de la fuerza en que se atraen electromagnéticamente. El gravitón (aún sin ) debe poseer, correspondientemente, menos energía que el fotón y, por tanto, ha de ser inimaginablemente difícil de detectar.

De todos modos, el físico norteamericano Joseph Weber emprendió en 1.957 la formidable tarea de detectar el gravitón. Llegó a emplear un par de cilindros de aluminio de 153 cm. De longitud y 66 de anchura, suspendidos de un cable en una cámara de vacío. Los gravitones (que serían detectados en de ondas), desplazarían levemente esos cilindros, y se empleó un sistema para detectar el desplazamiento que llegare a captar la cienmillonésima parte de un centímetro.

![]()

Joseph Weber

El interferómetro funciona enviando un haz de luz que se separa en dos haces; éstos se envían en direcciones diferentes a espejos donde se reflejan de regreso, entonces los haces al combinarse presentarán interferencia.

Las débiles ondas de los gravitones, que producen del espacio profundo, deberían chocar contra todo el planeta, y los cilindros separados por grandes distancias se verán afectados de simultánea. En 1.969, Weber anunció haber detectado los efectos de las ondas gravitatorias. Aquello produjo una enorme excitación, puesto que apoyaba una teoría particularmente importante (la teoría de Einstein de la relatividad general). Desgraciadamente, nunca se pudo comprobar mediante las pruebas realizadas por otros equipos de científicos que duplicaran el hallazgo de Weber.

![Resultado de imagen de Dónde están los gravitones]()

De todas formas, no creo que, a estas alturas, nadie pueda dudar de la existencia de los gravitones, el bosón mediador de la fuerza gravitatoria. La masa del gravitón es cero, su carga es cero, y su espín de 2. el fotón, no antipartícula, ellos mismos hacen las dos versiones.

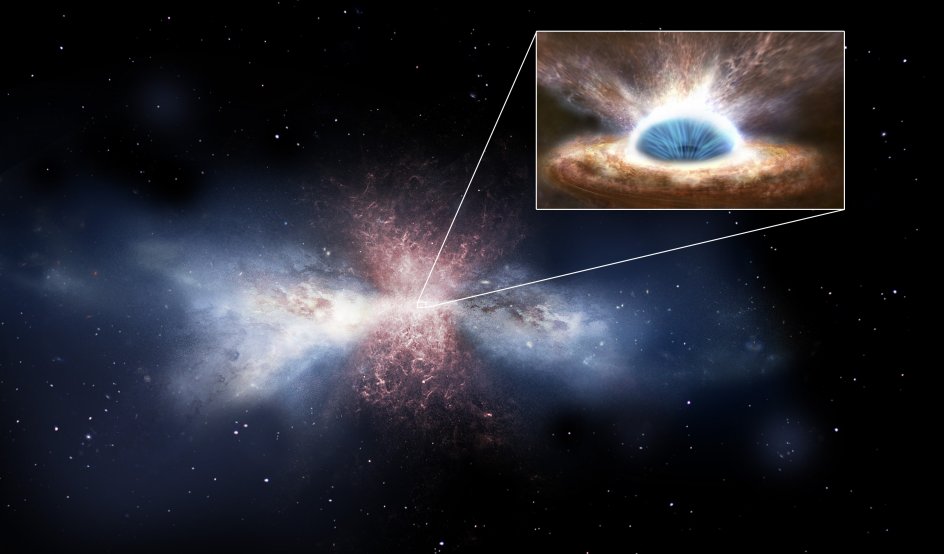

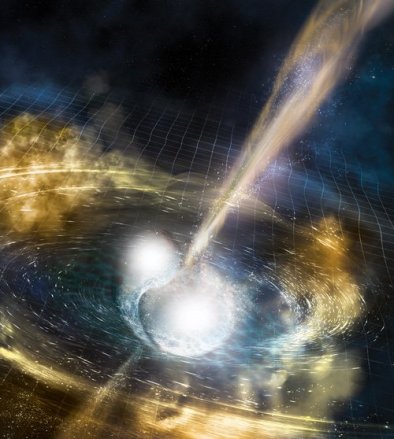

Tenemos que volver a los que posiblemente son los objetos más misteriosos de nuestro Universo: Los agujeros negros. Si estos objetos son lo que se dice (no parece que se pueda objetar nada en contrario), seguramente serán ellos los que, finalmente, nos faciliten las respuestas sobre las ondas gravitacionales y el esquivo gravitón.

![Resultado de imagen de Imagen de un <a href=]()

Imagen de un agujero negro en el núcleo de una galaxia arrasando otra próxima- NASA

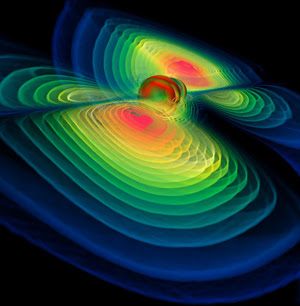

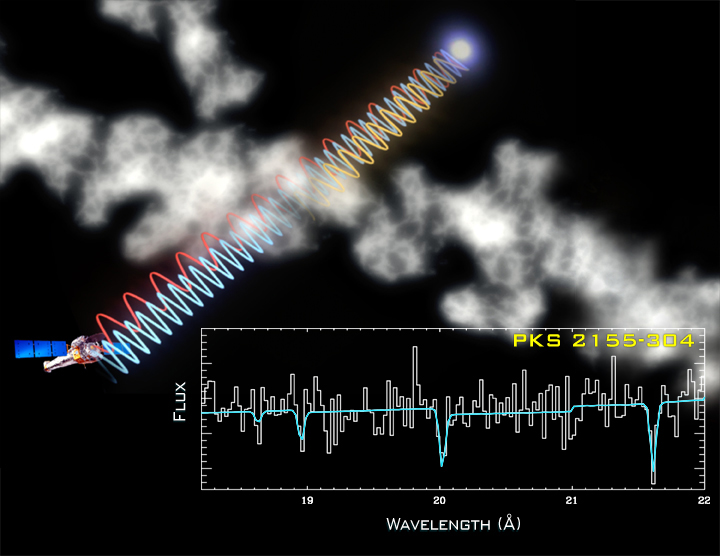

La onda gravitacional emitida por el agujero negro produce una ondulación en la curvatura del espacio-temporal que viaja a la velocidad de la luz transportada por los gravitones. Tenemos varios proyectos en marcha de la NASA y otros Organismos oficiales que buscan las ondas gravitatorias de los agujeros negros, de colisiones estrellas de neutrones y de otras fuentes análogas que, según se cree, nos hablará de “otro universo”, es decir, nos dará información desconocida hasta y sabremos “ver” un universo distinto al reflejado por las ondas electromagnéticas que es el que ahora conocemos.

![]()

¿Espuma cuántica? Si profundizamos mucho en la materia…

Hay aspectos de la física que me dejan totalmente sin habla, me obligan a pensar y me transporta de mundo material nuestro a otro fascinante donde residen las maravillas del Universo. Hay magnitudes asociadas con las leyes de la gravedad cuántica. La longitud de Planck-Wheeler, ![limite_planck limite_planck]() es la escala de longitud por debajo de la cual el espacio tal lo conocemos deja de existir y se convierte en espuma cuántica. El tiempo de Planck-Wheeler (1/c veces la longitud de Planck-Wheeler o aproximadamente 10-43 segundos), es el intervalo de tiempo más corto que existir; si dos sucesos están separados por menos que esto, no se puede decir cuál sucede antes y cuál después. El área de Planck-Wheeler (el cuadrado de la longitud de Planck-Wheeler, es decir, 2,61×10-66cm2) un papel clave en la entropía de un agujero negro.

es la escala de longitud por debajo de la cual el espacio tal lo conocemos deja de existir y se convierte en espuma cuántica. El tiempo de Planck-Wheeler (1/c veces la longitud de Planck-Wheeler o aproximadamente 10-43 segundos), es el intervalo de tiempo más corto que existir; si dos sucesos están separados por menos que esto, no se puede decir cuál sucede antes y cuál después. El área de Planck-Wheeler (el cuadrado de la longitud de Planck-Wheeler, es decir, 2,61×10-66cm2) un papel clave en la entropía de un agujero negro.

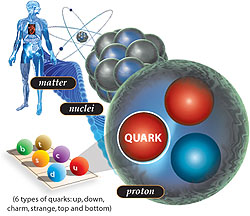

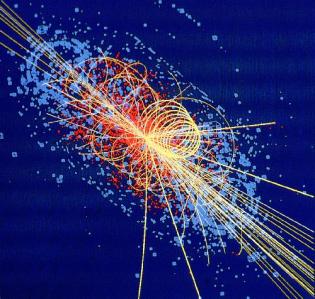

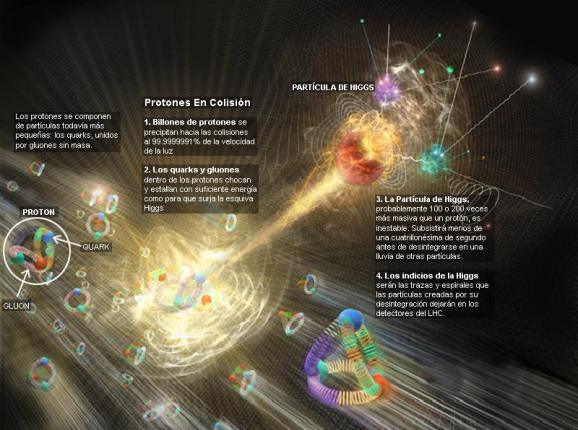

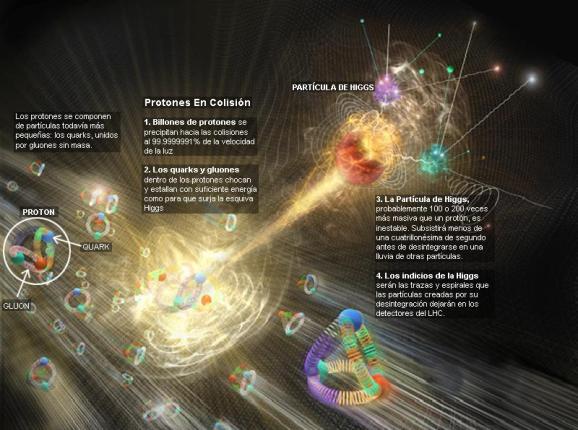

![]()

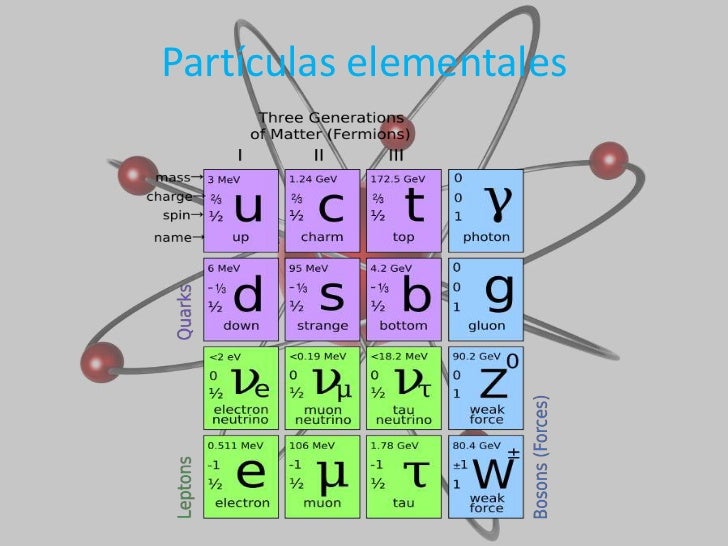

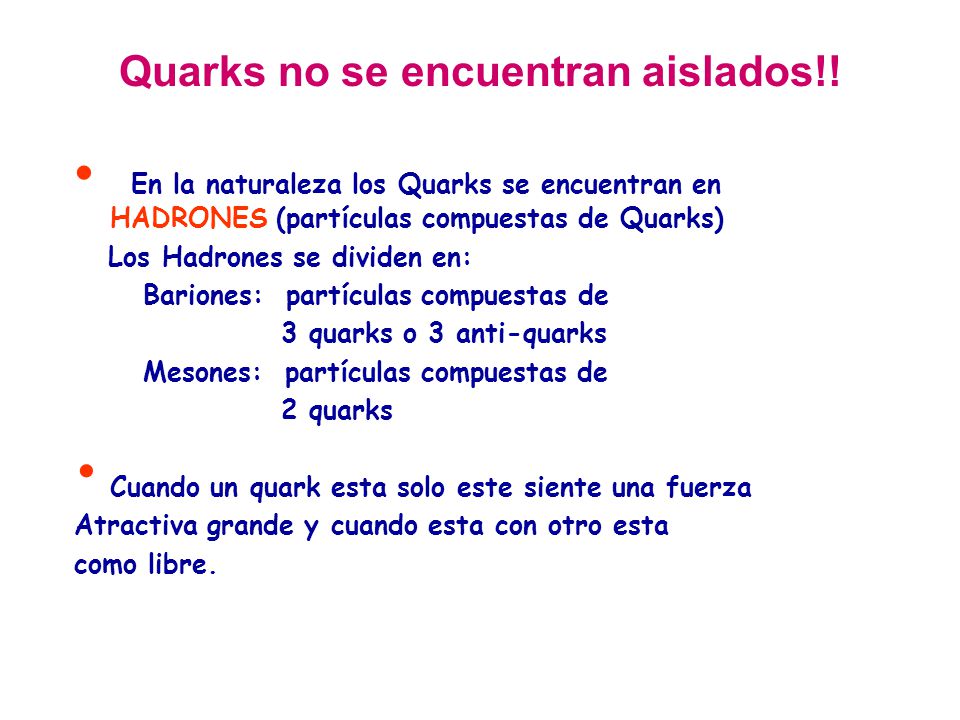

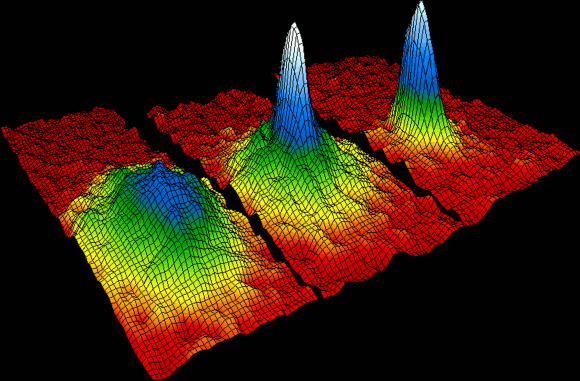

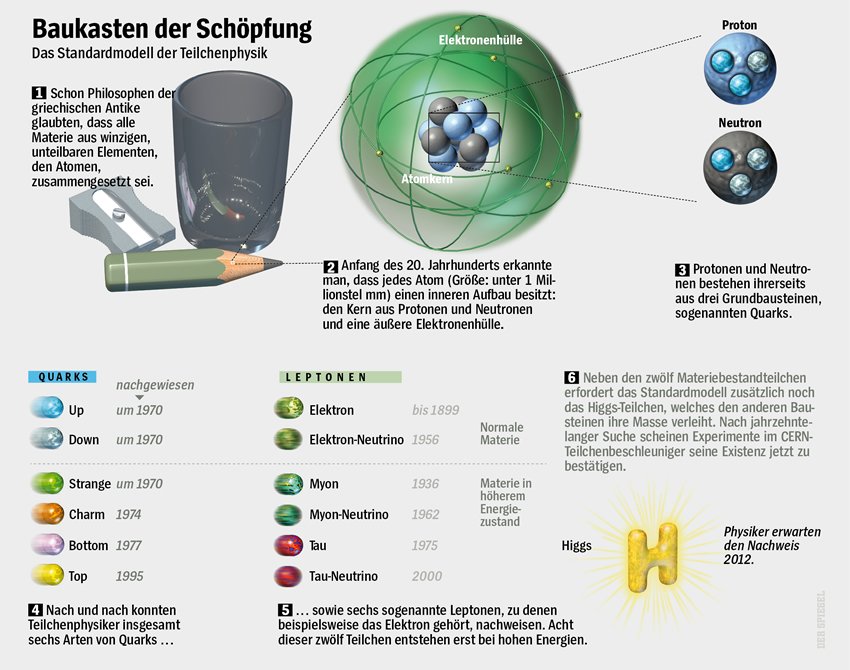

“Una investigación ha llevado a pensar que, la materia se construye sobre fundamentos frágiles. Los físicos acaban de confirmar que la materia, aparentemente sustancial, es en realidad nada más que fluctuaciones en el vació cuántico. Los investigadores simularon la frenética actividad que sucede en el interior de los protones y neutrones, que sabéis son las partículas que aportan casi la totalidad de la masa a la materia común. Estas dos partículas, protones y neutrones, se comportan como si en su interior, los quarks de los que están hechas ambas partículas, lucharan por escapar del confinamiento a que se ven sometidos por la fuerza nuclear fuerte por medio de los Gluones que forman un océano en el que se ven confinados sin remedio. De hecho, nunca nadie ha podido ver a un quark libre.

Así que, si estudiamos el vacío cuántico, parece que eso permitirá a los físicos someter a prueba a la Cromo Dinámica Cuántica y buscar sus efectos más allá de la física conocida. Por , los cálculos demuestran que la QCD describe partículas basadas en quarks de precisa, y que la mayor parte de nuestra masa viene de quarks virtuales y gluones que burbujean en el vacío cuántico.

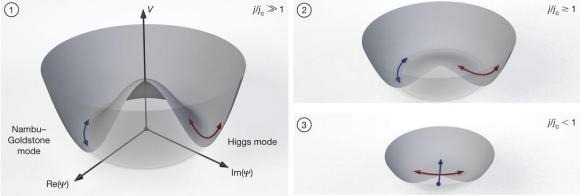

![Resultado de imagen de Campos de Higgs]()

Se cree que el campo de Higgs hace también su pequeña contribución, dando masa a los quarks individuales, así como a los electrones y a otras varias partículas. El campo de Higgs también crea masa a partir del vacío cuántico, en forma de bosones virtuales de Higgs. De modo que si el LHC confirma la existencia del bosón de Higgs, eso significará que toda la realidad es virtual, es menos virtual de lo que se pensaba. No creo que hasta el momento, y, a pesar de las declaraciones salidas el CERN, se tenga la seguridad de haber detectado el Bosón de Higgs.

De todo lo anterior, no podemos obtener una respuesta cierta y científicamente probada de que todo eso sea así, más , los resultados indican que todo eso “podría ser así”, lo que ocurre es que, los científicos, a veces se dejan llevar por las emociones. Al fin y al cabo, ellos como el común de los mortales, también son humanos.

![]()

Ya nos gustaría saber cómo es, ese vacío cuántico y qué pasa allí

Me llama poderosamente la atención lo que conocemos las fluctuaciones de vacío, esas oscilaciones aleatorias, impredecibles e ineliminables de un campo (electromagnético o gravitatorio), que son debidas a un tira y afloja en el que pequeñas regiones del espacio toman prestada momentáneamente energía de regiones adyacentes y luego la devuelven. Hace un par de días que hablamos de ello.

Ordinariamente, definimos el vacío como el espacio en el que hay una baja presión de un gas, es decir, relativamente pocos átomos o moléculas. En ese sentido, un vacío perfecto no contendría ningún átomo o molécula, pero no se obtener, ya que todos los materiales que rodean ese espacio tienen una presión de vapor finita. En un bajo vacío, la presión se reduce hasta 10-2 pascales, mientras que un alto vacío una presión de 10-2-10-7 pascales. Por debajo de 10-7 pascales se conoce como un vacío ultra-alto.

![]()

No puedo dejar de referirme al vacío theta (vació θ) que, es el de vacío de un campo gauge no abeliano (en ausencia de campos fermiónicos y campos de Higgs). En el vacío theta hay un infinito de estados degenerados con efecto túnel entre estos estados. Esto significa que el vacío theta es análogo a una función de Bloch en un cristal.

Se derivar tanto como un resultado general o bien usando técnicas de instantón. Cuando hay un fermión sin masa, el efecto túnel estados queda completamente suprimido. Cuando hay campos fermiónicos con masa pequeña, el efecto túnel es mucho menor que campos gauge puros, pero no está completamente suprimido.

![]()

¡Es tanto lo que hay pero que no podemos ver!

Si buscamos por ahí podremos leer explicaciones como : “En la Teoría cuántica de campos, el vacío cuántico ( llamado el vacío) es el cuántico con la menor energía posible. Generalmente no contiene partículas físicas. El término “Energía de punto cero” es usado ocasionalmente como sinónimo para el vacío cuántico de un determinado campo cuántico.

De acuerdo a lo que se entiende actualmente por vacío cuántico o “ de vacío”, este “no es desde ningún punto de vista un simple espacio vacío” , y otra vez: “es un error pensar en cualquier vacío físico como un absoluto espacio vacío.” De acuerdo con la mecánica cuántica, el vacío cuántico no está verdaderamente vacío sino que contiene ondas electromagnéticas fluctuantes y partículas que saltan adentro y fuera de la existencia.

Según las modernas teorías de las partículas elementales, el vacío es un objeto físico, se puede cargar de energía y se puede convertir en varios estados distintos. Dentro de su terminología, los físicos hablan de vacíos diferentes. El de partículas elementales, su masa y sus interacciones están determinados por el vacío subyacente. La relación entre las partículas y el vacío es similar a la relación entre las ondas del sonido y la materia por la que se propagan. Los tipos de ondas y la velocidad a la que viajan varía dependiendo del material.”

![]()

Como nos dicen en este anuncio del Kybalion, nada es estático en el Universo y, todo está en continuo movimiento o vibración. Habréis oído hablar de la energía de punto cero que permanece en una sustancia en el cero absoluto (cero K). Está de acuerdo con la teoría cuántica, según la cual, una partícula oscilando con un movimiento armónico simple no tiene estado estacionario de energía cinética nula. Es más, el Principio de Incertidumbre no permite que esta partícula esté en reposo en el punto central exacto de sus oscilaciones. Del vacío surgen sin cesar partículas virtuales que desaparecen en fracciones de segundo, y, ya conocéis, por ejemplo, el Efecto Casimir en el que dos placas pueden producir energía negativa surgidas del vacío.

De todas las maneras, en momento sabemos tanto de la espuma cuántica como de nuestra presencia en el Universo, es decir, nada. Todo son conjeturas, suposiciones e hipótesis que nos hacen imaginar lo que pueda existir a la distancia de Planck. Claro que en una longitud de 10-35 metros, sí que es fácil imaginar que lo que podamos ver allí sería simplemente una especie de espuma cuántica asociada a lo que estimamos que sería la gravedad cuántica.

emilio silvera

con μ,υ = 1, 2, 3, 4, corresponde a la métrica 4-dimensional del espacio-tiempo de la RG, Aμproporciona el campo electromagnético, Φ es un campo escalar conocido posteriormente como dilatón, y α = √2k es la constante de acoplo relacionada con la constante de

con μ,υ = 1, 2, 3, 4, corresponde a la métrica 4-dimensional del espacio-tiempo de la RG, Aμproporciona el campo electromagnético, Φ es un campo escalar conocido posteriormente como dilatón, y α = √2k es la constante de acoplo relacionada con la constante de  no dependiera de la quinta coordenada.

no dependiera de la quinta coordenada.

, en unidades naturales ћ = c = 1, y carga qn (modos de

, en unidades naturales ћ = c = 1, y carga qn (modos de

del orden de 10-8 Kg = 1011 GeV; es la masa de una partícula cuya longitud de onda compton es igual a la

del orden de 10-8 Kg = 1011 GeV; es la masa de una partícula cuya longitud de onda compton es igual a la

es la escala de longitud por debajo de la cual el espacio tal

es la escala de longitud por debajo de la cual el espacio tal

(Longitud de Planck que al cuadrado sería de 10-66 cm2)

(Longitud de Planck que al cuadrado sería de 10-66 cm2)

, donde c es la velocidad de la luz. La hipótesis original atribuía esta contracción a una contracción real que acompaña al movimiento absoluto del cuerpo. La contracción es en cualquier caso despreciable a no ser que v sea del mismo orden o cercana a c.

, donde c es la velocidad de la luz. La hipótesis original atribuía esta contracción a una contracción real que acompaña al movimiento absoluto del cuerpo. La contracción es en cualquier caso despreciable a no ser que v sea del mismo orden o cercana a c.

.jpg)

![[stephan_quinteto_2009_hubble.jpg]](http://3.bp.blogspot.com/_xBXZbW6ivIs/SqpvjP3SBJI/AAAAAAAAEqc/fh3ULAFurbs/s1600/stephan_quinteto_2009_hubble.jpg)